使用工具将<大规模语言模型:从理论到实践>转换成markdown,方便在线预览

感谢

张奇 桂韬 郑锐 ⻩萱菁 著

· 2024 年 10 月 7 日

前言

2018 年 Google 的研究团队开创性地提出了预训练语言模型 BERT[1],该模型在诸多自然语言 处理任务中展现了卓越的性能。这激发了大量以预训练语言模型为基础的自然语言处理研究,也 引领了自然语言处理领域的预训练范式的兴起。然而,尽管这一变革影响深远,但它并没有改变 每个模型只能解决特定问题的基本模式。2020 年,OpenAI 发布了 GPT-3 模型,其在文本生成任务 上的能力令人印象深刻,并在许多少标注(Few-shot)的自然语言处理任务上取得了优秀的成绩。 但是,其性能并未超越专门针对单一任务训练的有监督模型。之后,研究者们陆续提出了针对大 语言模型(Large Language Model,LLM)的提示词(Prompt)学习方法,并在各式各样的自然语 言处理任务中进行了试验,同时也提出了模型即服务范式(Model as a Service,MaaS)概念。然 而,在大部分情况下,这些方法的性能并未明显地超过基于预训练微调范式的模型。所以,这些 方法的影响力主要还是局限在自然语言处理的研究人员群体中。

2022 年 11 月,ChatGPT 的问世展示了大语言模型的强大潜能,并迅速引起了广泛关注。Chat-GPT 能够有效理解用户需求,并根据上下文提供恰当的回答。它不仅可以进行日常对话,还能够 完成复杂任务,如撰写文章、回答问题等。令人惊讶的是,所有这些任务都由一个模型完成。在许 多任务上,ChatGPT 的性能甚至超过了针对单一任务进行训练的有监督算法。这对于人工智能领 域具有重大意义,并对自然语言处理研究产生了深远影响。然而,由于 OpenAI 并未公开 ChatGPT 的详细实现细节,整体训练过程包括语言模型、有监督微调、类人对齐等多个方面,这些方面之 间还存在大量的关联,这对于研究人员的自然语言处理和机器学习基础理论要求很高。此外,大 语言模型的参数量非常庞大,与传统的自然语言处理研究范式完全不同。使用大语言模型还需要 分布式并行计算的支持,这对自然语言处理算法研究人员又进一步提高了要求。为了使得更多的 自然语言处理研究人员和对大语言模型感兴趣的读者能够快速了解大语言模型和理论基础,并开 展大语言模型实践,结合之前在自然语言处理领域研究经验,以及分布式系统和并行计算的教学 经验,我们在大语言模型实践和理论研究的过程中,历时 8 个月完成本书。希望这本书能够帮助 读者快速入门大语言模型的研究和应用,并解决相关技术挑战。

自然语言处理的研究历史可以追溯到 1947 年,当时第一台通用计算机 ENIAC 刚刚问世。自 然语言处理经历了 20 世纪 50 年代末到 60 年代初的初创期,20 世纪 70 年代到 80 年代的理性主 义时代,20 世纪 90 年代到 21 世纪初的经验主义时代,以及 2006 年至今的深度学习时代。自 2017 年 Transformer 架构[2] 提出并在机器翻译领域取得巨大成功后,自然语言处理进入了爆发式的发 展阶段。2018 年,动态词向量 ELMo[3] 模型开启了语言模型预训练的先河。随后,以 GPT[4] 和 BERT[1] 为代表的基于 Transformer 模型的大规模预训练语言模型相继提出,自然语言处理进入了 预训练微调的新时代。2019 年,OpenAI 发布了拥有 15 亿参数的 GPT-2 模型[4],2020 年,Google 发布了拥有 110 亿参数的 T5 模型。同年,OpenAI 发布了包含 1750 亿参数的 GPT-3 模型[5],从而 开启了大语言模型的时代。直到 2022 年 11 月,ChatGPT 的问世将大语言模型的研究推向了新的 高度,引发了大语言模型研究的热潮。尽管大语言模型的发展历程只有不到五年的时间,但其发 展速度相当惊人。截至 2023 年 6 月,国内外已经发布了超过百种大语言模型。

大语言模型的研究融合了自然语言处理、机器学习、分布式计算、并行计算等多个学科领域。 其发展历程可以分为基础模型阶段、能力探索阶段和突破发展阶段。基础模型阶段主要集中在 2018 年至 2021 年期间,期间发布了一系列代表性的大语言模型,如 BERT、GPT、百度 ERNIE、华为盘 古-α、Palm 等。这些模型的发布为大语言模型的研究打下了基础。能力探索阶段主要发生在 2019 年至 2022 年期间。由于大语言模型在针对特定任务上微调方面存在一定困难,研究人员开始探索 如何在不进行单一任务微调的情况下发挥大语言模型的能力。同时,研究人员还开始尝试指令微 调(Instruction Tuning)方案,将各种类型的任务统一为生成式自然语言理解框架,并使用构造的 训练语料对模型进行微调。突破发展阶段以 2022 年 11 月 ChatGPT 的发布为起点。ChatGPT 通过 一个简单的对话框,利用一个大语言模型就能够实现问题回答、文稿撰写、代码生成、数学解题 等多种任务,而以往的自然语言处理系统需要使用多个小模型进行定制开发才能分别实现这些能 力。ChatGPT 在开放领域问答、各类生成式自然语言任务以及对话理解等方面展现出的能力远超 过大多数人的想象。这些阶段的发展推动了大语言模型的突破,为自然语言处理研究带来了巨大 的进展,并在各个领域展示了令人瞩目的成果。

本书围绕大语言模型构建的四个主要阶段:预训练、有监督微调、奖励建模和强化学习,详细 介绍各阶段使用的算法、数据、难点以及实践经验。预训练,需要利用包含数千亿甚至数万亿单词 的训练数据,并借助由数千块高性能 GPU 和高速网络组成的超级计算机,花费数十天完成深度神 经网络参数的训练。这一阶段的核心难点在于如何构建训练数据以及如何高效地进行分布式训练。 有监督微调阶段利用少量高质量的数据集,其中包含用户输入的提示词(Prompt)和对应的理想输 出结果。提示词可以是问题、闲聊对话、任务指令等多种形式和任务。这个阶段是从语言模型向 对话模型转变的关键,其核心难点在于如何构建训练数据,包括训练数据内部多个任务之间的关 系、训练数据与预训练之间的关系以及训练数据的规模。奖励建模阶段的目标是构建一个文本质量 对比模型,用于对有监督微调模型对于同一个提示词给出的多个不同输出结果进行质量排序。这 一阶段的核心难点在于如何限定奖励模型的应用范围以及如何构建训练数据。强化学习阶段根据数 十万提示词,利用前一阶段训练的奖励模型,对有监督微调模型对用户提示词补全结果的质量进 行评估,与语言模型建模目标综合得到更好的效果。这一阶段的难点在于解决强化学习方法稳定 性不高、超参数众多以及模型收敛困难等问题。除了大语言模型的构建,本书还进一步介绍了大 语言模型的应用和评估方法。主要内容包括如何将大语言模型与外部工具和知识源进行连接、如

何利用大语言模型进行自动规划完成复杂任务,以及针对大语言模型的各类评估方法。

本书旨在为对大语言模型感兴趣的读者提供一个入门指南,并可作为高年级本科生和研究生 自然语言处理相关课程的大语言模型部分的补充教材。鉴于大语言模型的研究仍在快速发展阶段, 许多方面尚未达成完整结论或普遍共识。在撰写本书时,我们力求全面展现大模型研究的各个方 面,并避免给出没有广泛共识的观点和结论。大语言模型涉及深度学习、自然语言处理、分布式 计算、并行计算等众多领域。因此,建议读者在阅读本书之前,首先系统地学习深度学习和自然 语言处理的相关课程。在分布式计算和异构计算方面,也需要读者具备基本的概念。如果希望在 大语言模型训练和推理方面进行深入研究,还需要系统学习分布式系统、并行计算、CUDA 编程 等相关知识。

本书的写作过程得到了众多专家和同学的大力支持和帮助。特别感谢陈璐、陈天泽、陈文翔、 窦士涵、葛启明、郭昕、赖文斌、柳世纯、汪冰海、奚志恒、许诺、张明、周钰皓等同学(按照 拼音排序)为本书撰写提供的帮助。大语言模型研究进展之快,即便是在自然语言处理领域开展 了近三十年工作的我们也难以适从。其受关注的火爆程度令人咋舌,自然语言处理领域重要国际 会议 EMNLP,在 2022 年语言模型相关论文投稿占比只有不到 5%。然而,2023 年语言模型相关 投稿则超过了 EMNLP 整体投稿的 20%。如何能够兼顾大语言模型的基础理论,又能够在快速发 展的各种研究中选择最具有代表性的工作介绍给大家,是本书写作中面临的最大挑战。虽然本书 写作时间只有 8 个月,但是章节内部结构也是几易其稿,经过数次大幅度调整和重写。即便如此, 受限于我们的认知水平和所从事的研究工作的局限,对其中一些任务和工作的细节理解仍然可能 存在不少错误,也恳请专家、读者批评指正!

张奇 2023 年 9 月于复旦

数学符号

数与数组

| α | 标量 | |||

|---|---|---|---|---|

| α | 向量 | |||

| A | 矩阵 | |||

| A | 张量 | |||

| In | 行 n n | 列单位矩阵 | ||

| vw | 单词 w | 的分布式向量表示 | ||

| ew | 单词 w | 的独热向量表示:[0,0,…,1,0,…0],w | 下标处元素为 | 1 |

索引

| αi | 向量 α | 中索引 | i | 处的元素 | |

|---|---|---|---|---|---|

| α−i | 向量 α | 中除索引 | i | 之外的元素 | |

| wi:j | 序列 w | 中从第 | i | 个元素到第 j | 个元素组成的片段或子序列 |

| Aij | 矩阵 A | 中第 i | 行、第 | j 列处的元素 | |

| Ai: | 矩阵 A | 中第 i | 行 | ||

| A:j | 矩阵 A | 中第 j | 列 | ||

| Aijk | 三维张量 | A | 中索引为 | (i, j, k) | 处元素 |

| A::i | 三维张量 | A | 中的一个二维切片 |

集合

| A | 集合 | |

|---|---|---|

| R | 实数集 | |

| C | 复数集 | |

| {0, 1, …, n} | 含 0 和 | n 的正整数的集合 |

| [a, b] | a 到 b | 的实数闭区间 |

| (a, b] | a 到 b | 的实数左开右闭区间 |

线性代数

| A⊤ | 矩阵 | A | 的转置 | |||||||

|---|---|---|---|---|---|---|---|---|---|---|

| A | ⊙ B | 矩阵 | A | 与矩阵 | B 的 | Hadamard | 乘积 | |||

| det(A) | 矩阵 | A | 的行列式 | |||||||

| [x; | y] | 向量 | x | 与 y | 的拼接 | |||||

| [U; | V | ] | 矩阵 | U | 与 V | 沿行向量拼接 | ||||

| x · y | 或 | x | ⊤y | 向量 | x | 与 y | 的点积 |

微积分

| dy | 的导数 | |||

|---|---|---|---|---|

| dx | ||||

| €y | 对 | 的偏导数 | ||

| €x | ||||

| ▽xy | y | 对向量 | x | 的梯度 |

| ▽Xy | y | 对矩阵 | X | 的梯度 |

| y y y | ||||

| 对 x x | ||||

| X | ||||

| ▽Xy | 对张量 | 的梯度 |

概率与信息论

| a ⊥ b | 随机变量 a | 与 b | 独立 | |||||

|---|---|---|---|---|---|---|---|---|

| a ⊥ b | c | 随机变量 a | 与 b | 关于 | c | 条件独立 | ||

| P(a) | 离散变量概率分布 | |||||||

| p(a) | 连续变量概率分布 | |||||||

| a ∼ P | 随机变量 a | 服从分布 | P | |||||

| Ex∼P (f(x)) | 或 | f(x) 在分布 | P(x) | 下的期望 | ||||

| E(f(x)) | ||||||||

| Var(f(x)) | 在分布 f(x) | P(x) | 下的方差 | |||||

| Cov(f(x), g(x)) | 与 f(x) g(x) | 在分布 | P(x) | 下的协方差 | ||||

| H(f(x)) | 随机变量 x | 的信息熵 | ||||||

| DKL(P ∥ Q) | 概率分布 P | 与 | Q 的 | KL | 散度 | |||

| N (µ, | Σ) | 均值为 | µ、协方差为 | Σ | 的高斯分布 |

数据与概率分布

| D | 数据集 | ||||||

|---|---|---|---|---|---|---|---|

| (i) | 数据集中第 | i | 个样本(输入) | ||||

| y | (i) 或 | (i) y | 第 i | 个样本 | x | (i) 的标签(输出) | |

| X 或 x |

函数

| f : | A −→ B | 由定义域 | A 到值域 | B 的函数(映射)f | ||||||

|---|---|---|---|---|---|---|---|---|---|---|

| f ◦ g | f 与 g | 的复合函数 | ||||||||

| f(x; θ) | 由参数 | θ 定义的关于 | x 的函数(也可以直接写作 | f(x),省略 | θ) | |||||

| log x | x | 的自然对数函数 | ||||||||

| σ(x) | Sigmoid | 函数 | 1 | |||||||

| 1 + | exp(−x) | |||||||||

| x | 的 x L | 2 范数 | ||||||||

| condition 1 | 条件指示函数:如果 | 为真,则值为 condition | 1;否则值为 | 0 | ||||||

| x | p | 的 x L | p 范数 |

本书中常用写法

-

给定词表 V,其大小为 V - 序列 x = x1, x2, …, xn 中第 i 个单词 xi 的词向量 vxi

-

损失函数 L 为负对数似然函数:L(θ) = − P (x,y) log P(y x1…xn) - 算法的空间复杂度为 O(mn)

| 1 | 绪论 | 1 |

|---|---|---|

| 1.1 | 大规模语言模型基本概念 1 | |

| 1.2 | 大规模语言模型发展历程 4 | |

| 1.3 | 大规模语言模型构建流程 6 | |

| 1.4 | 本书的内容安排 | 11 |

| 2 | 大语言模型基础 | 13 |

| 2.1 | Transformer 结构 | 13 |

| 2.1.1 | 嵌入表示层 15 | |

| 2.1.2 | 注意力层 16 | |

| 2.1.3 前馈层 | 18 | |

| 2.1.4 | 残差连接与层归一化 19 | |

| 2.1.5 | 编码器和解码器结构 19 | |

| 2.2 | 生成式预训练语言模型 GPT 24 | |

| 2.2.1 | 无监督预训练 24 | |

| 2.2.2 | 有监督下游任务微调 26 | |

| 2.2.3 | 基于 HuggingFace 的预训练语言模型实践 26 | |

| 2.3 | 大语言模型结构 | 31 |

| 2.3.1 | LLaMA 的模型结构 32 | |

| 2.3.2 | 注意力机制优化 37 | |

| 2.4 | 实践思考 | 44 |

| 3 | 大语言模型预训练数据 46 | |

| 3.1 | 数据来源 | 46 |

| 3.1.1 | 通用数据 47 | |

| 3.1.2 | 专业数据 48 |

| 3.2 | 数据处理 | 49 |

|---|---|---|

| 3.2.1 | 低质过滤 49 | |

| 3.2.2 | 冗余去除 50 | |

| 3.2.3 | 隐私消除 51 | |

| 3.2.4 | 词元切分 52 | |

| 3.3 | 数据影响分析 | 57 |

| 3.3.1 数据规模影响 | 57 | |

| 3.3.2 数据质量影响 | 60 | |

| 3.3.3 数据多样性影响 | 62 | |

| 3.4 | 开源数据集合 | 64 |

| 3.4.1 | Pile 64 | |

| 3.4.2 ROOTS | 66 | |

| 3.4.3 RefinedWeb | 68 | |

| 3.4.4 SlimPajama | 71 | |

| 3.5 | 实践思考 | 74 |

| 4 | 分布式训练 | 75 |

| 4.1 | 分布式训练概述 | 75 |

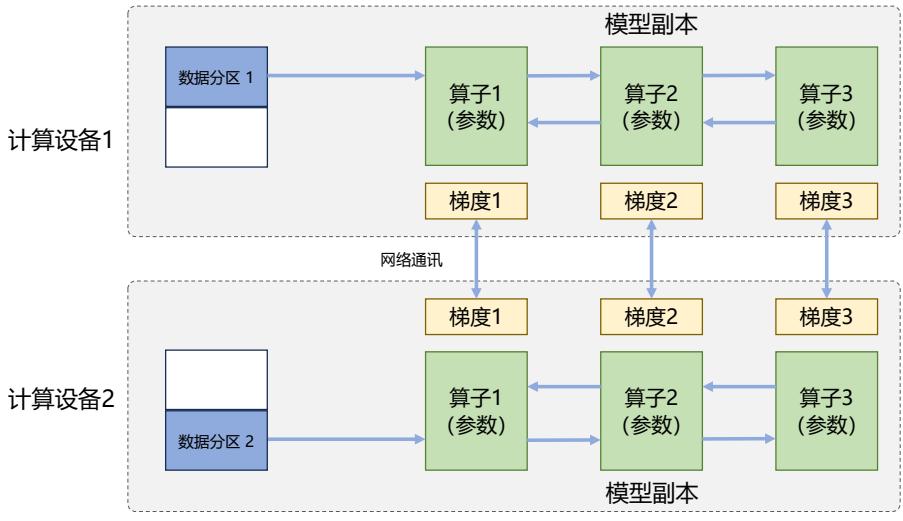

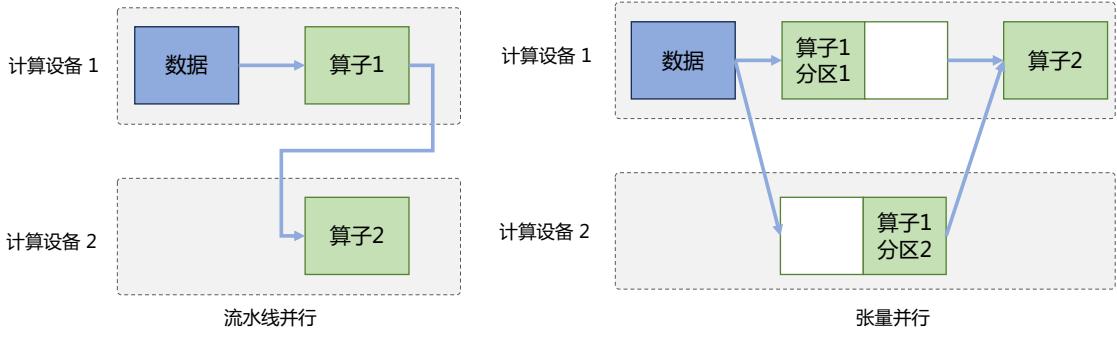

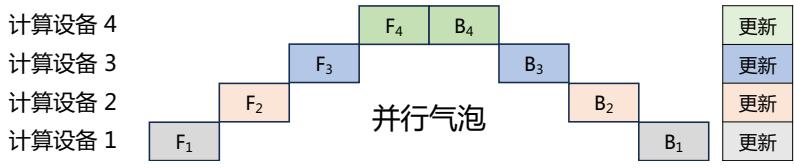

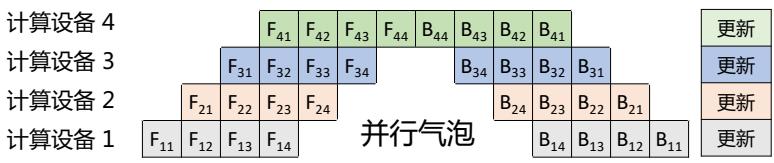

| 4.2 | 分布式训练并行策略 | 78 |

| 4.2.1 | 数据并行 79 | |

| 4.2.2 | 模型并行 82 | |

| 4.2.3 | 混合并行 90 | |

| 4.2.4 | 计算设备内存优化 91 | |

| 4.3 | 分布式训练的集群架构 | 95 |

| 4.3.1 | 高性能计算集群硬件组成 96 | |

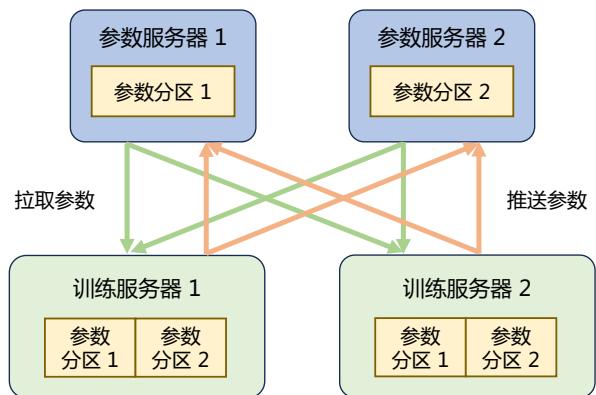

| 4.3.2 参数服务器架构 | 97 | |

| 4.3.3 去中心化架构 | 98 | |

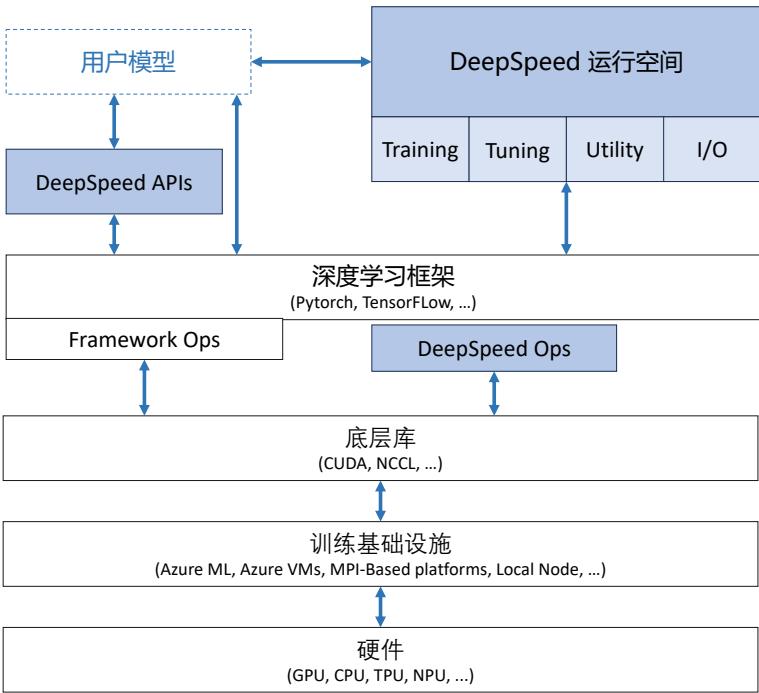

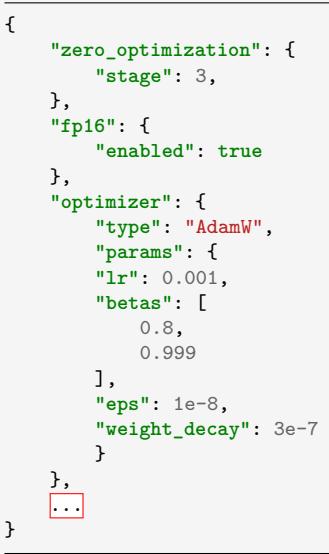

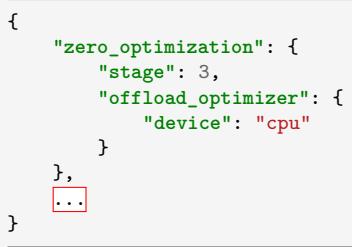

| 4.4 | DeepSpeed 实践 | 103 |

| 4.4.1 | 基础概念 105 | |

| 4.4.2 | LLaMA 分布式训练实践 108 | |

| 4.5 | 实践思考 | 118 |

| 5 | 有监督微调 | 120 |

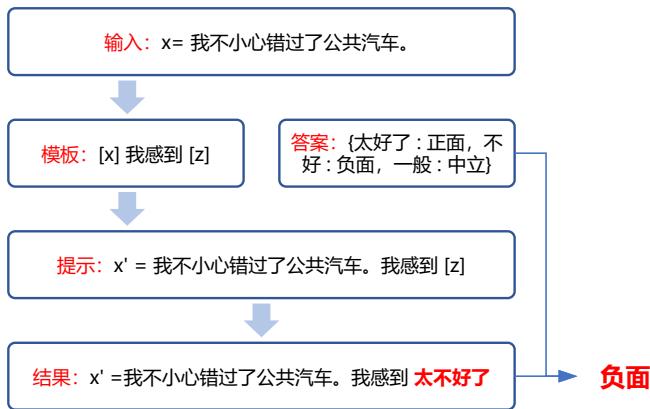

| 5.1 | 提示学习和语境学习 | 120 |

| 5.1.1 | 提示学习 120 |

| 5.1.2 语境学习 122 | ||

|---|---|---|

| 5.2 | 高效模型微调 123 | |

| 5.2.1 LoRA 123 | ||

| 5.2.2 LoRA 的变体 126 | ||

| 5.3 | 模型上下文窗口扩展 128 | |

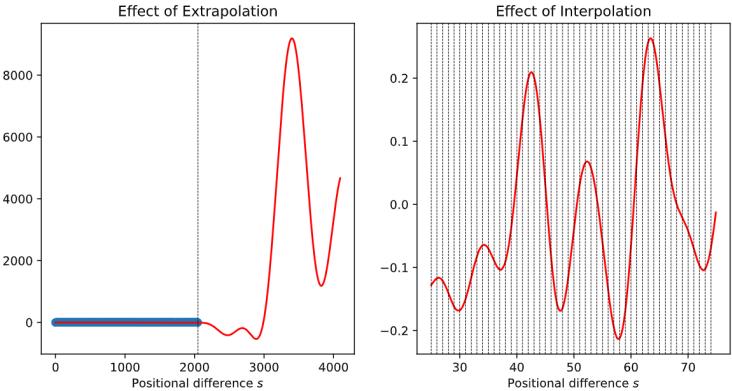

| 5.3.1 具有外推能力的位置编码 129 | ||

| 5.3.2 插值法 130 | ||

| 5.4 | 指令数据构建 132 | |

| 5.4.1 手动构建指令 132 | ||

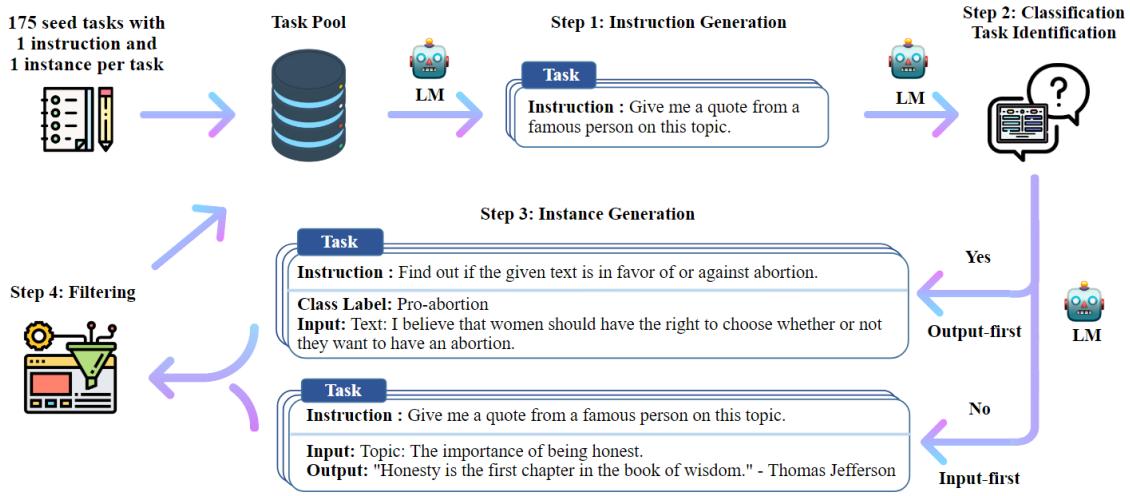

| 5.4.2 自动生成指令 133 | ||

| 5.4.3 开源指令数据集 136 | ||

| 5.5 | DeepSpeed-Chat SFT 实践 138 | |

| 5.5.1 代码结构 139 | ||

| 5.5.2 数据预处理 141 | ||

| 5.5.3 自定义模型 143 | ||

| 5.5.4 模型训练 145 | ||

| 5.5.5 模型推理 146 | ||

| 5.6 | 实践思考 146 | |

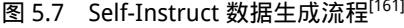

| 强化学习 148 | 6 | |

| 6.1 | 基于人类反馈的强化学习 148 | |

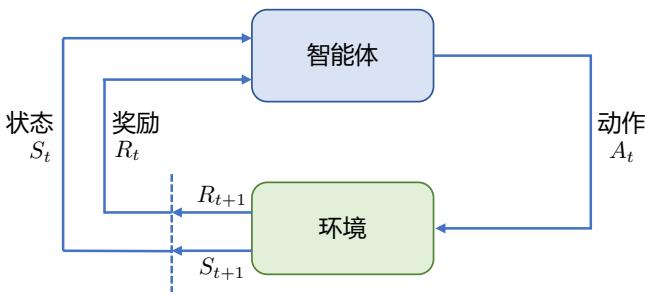

| 6.1.1 强化学习概述 148 | ||

| 6.1.2 强化学习与有监督学习的区别 150 | ||

| 6.1.3 基于人类反馈的强化学习流程 152 | ||

| 6.2 | 奖励模型 153 | |

| 6.2.1 数据收集 153 | ||

| 6.2.2 模型训练 155 | ||

| 6.2.3 开源数据 157 | ||

| 6.3 | 近端策略优化 157 | |

| 6.3.1 策略梯度 158 | ||

| 6.3.2 广义优势估计 159 | ||

| 6.3.3 近端策略优化算法 162 |

| 6.4 | MOSS-RLHF 实践 163 |

|---|---|

| 6.4.1 奖励模型训练 163 | |

| 6.4.2 PPO 微调 165 | |

| 6.5 | 实践思考 173 |

| 7 | 大语言模型应用 174 |

| 7.1 | 推理规划 174 |

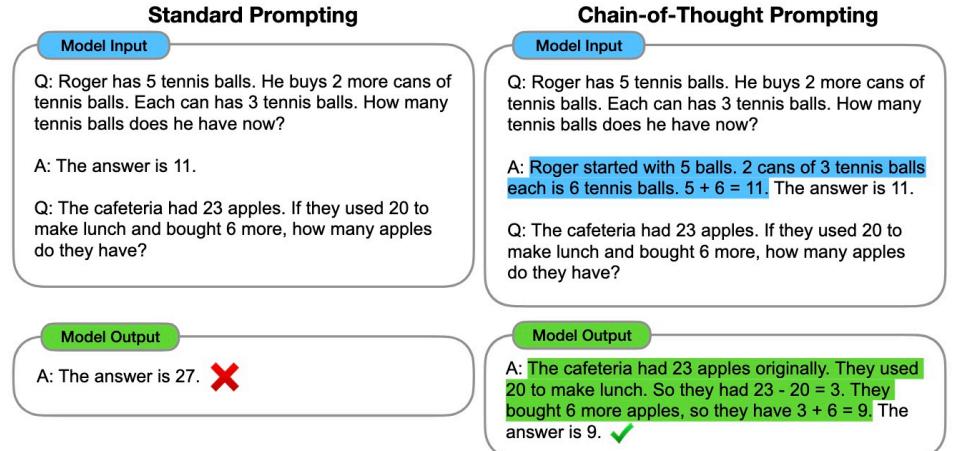

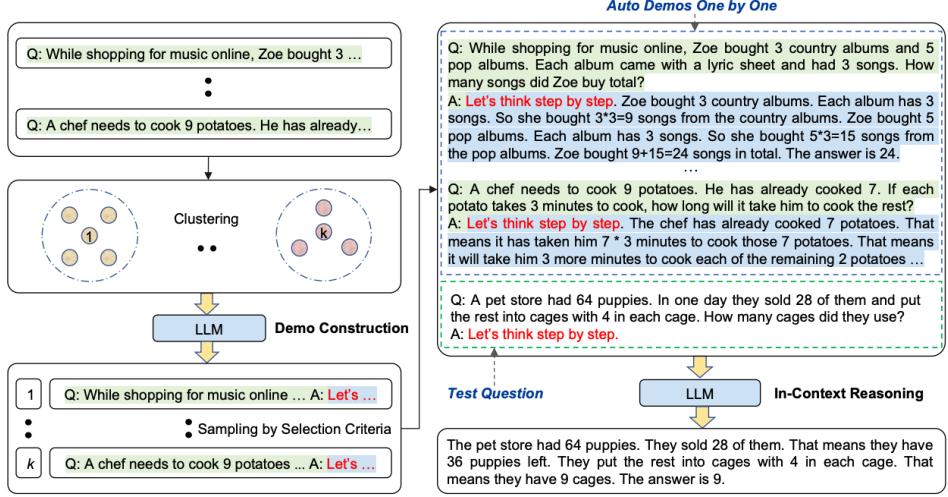

| 7.1.1 思维链提示(Chain-of-Thought Prompting) 174 | |

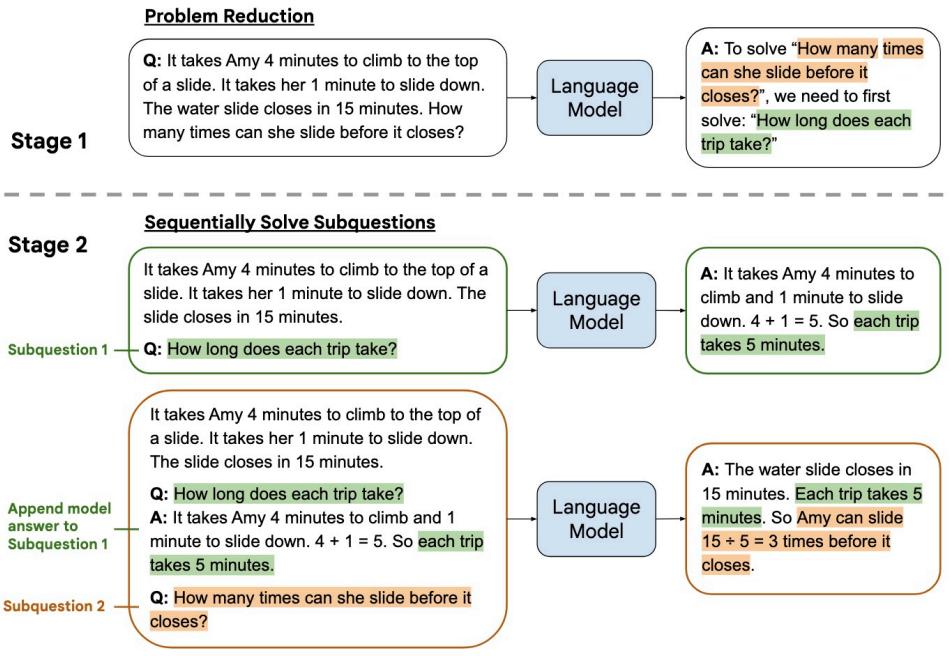

| 7.1.2 由少至多提示(Least-to-Most Prompting) 177 | |

| 7.2 | 综合应用框架 178 |

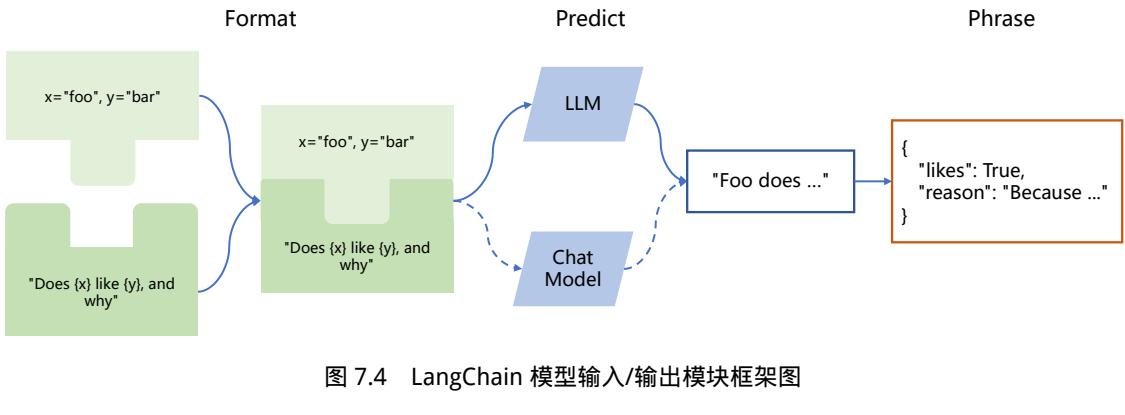

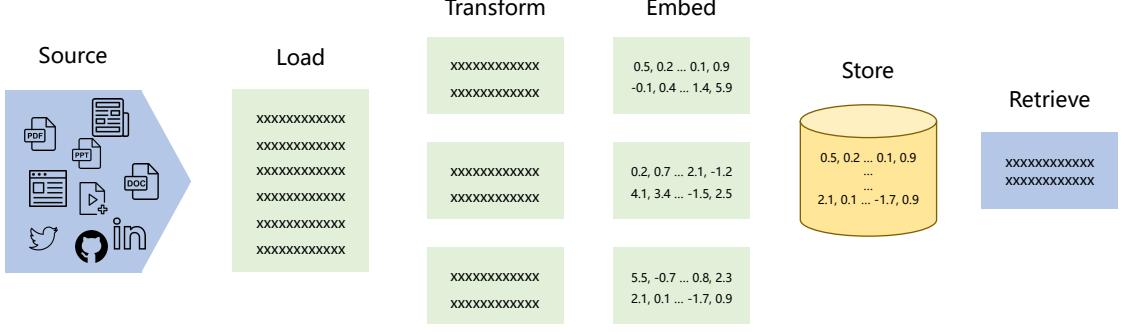

| 7.2.1 LangChain 框架核心模块 179 | |

| 7.2.2 知识库问答实践 195 | |

| 7.3 | 智能代理 197 |

| 7.3.1 智能代理的组成 197 | |

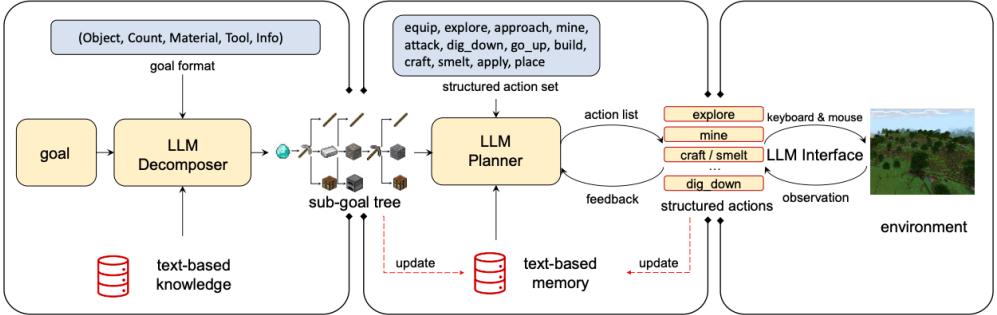

| 7.3.2 智能代理的应用实例 200 | |

| 7.4 | 多模态大模型 205 |

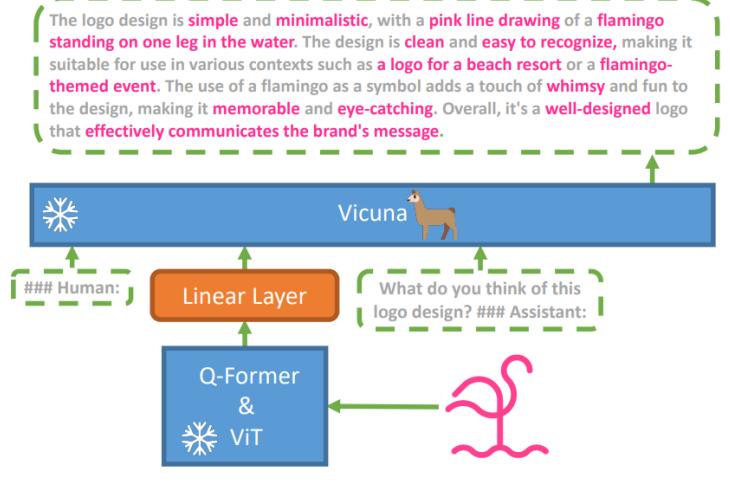

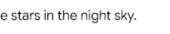

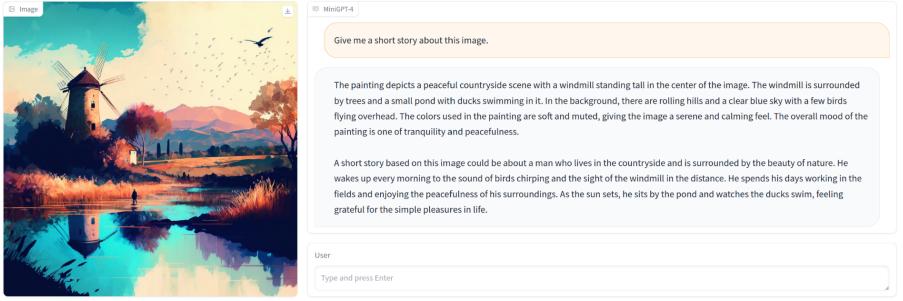

| 7.4.1 模型架构 206 | |

| 7.4.2 数据收集与训练策略 209 | |

| 7.4.3 多模态能力示例 213 | |

| 7.5 | 大语言模型推理优化 214 |

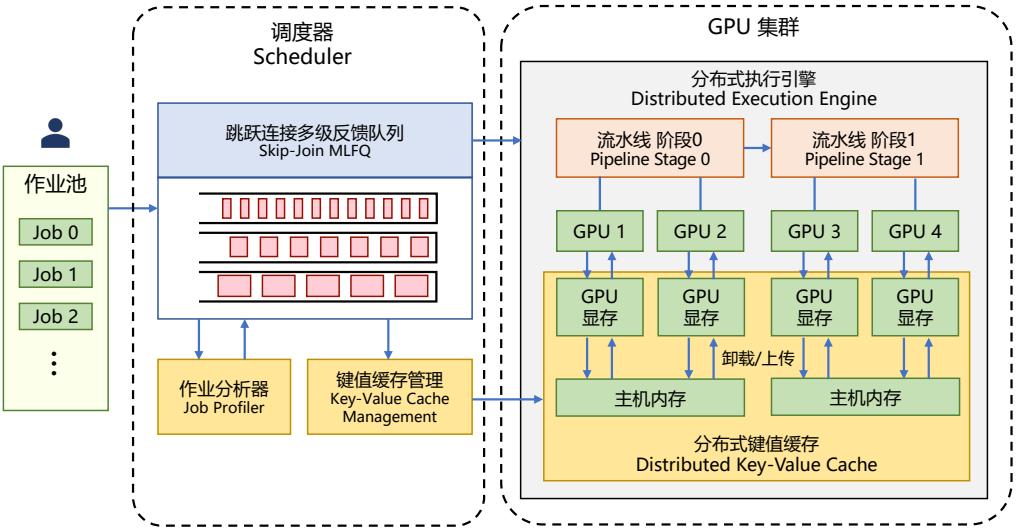

| 7.5.1 FastServe 框架 217 | |

| 7.5.2 vLLM 推理框架实践 219 | |

| 7.6 | 实践思考 220 |

| 8 | 大语言模型评估 222 |

| 8.1 | 模型评估概述 222 |

| 8.2 | 大语言模型评估体系 224 |

| 8.2.1 知识与能力 224 | |

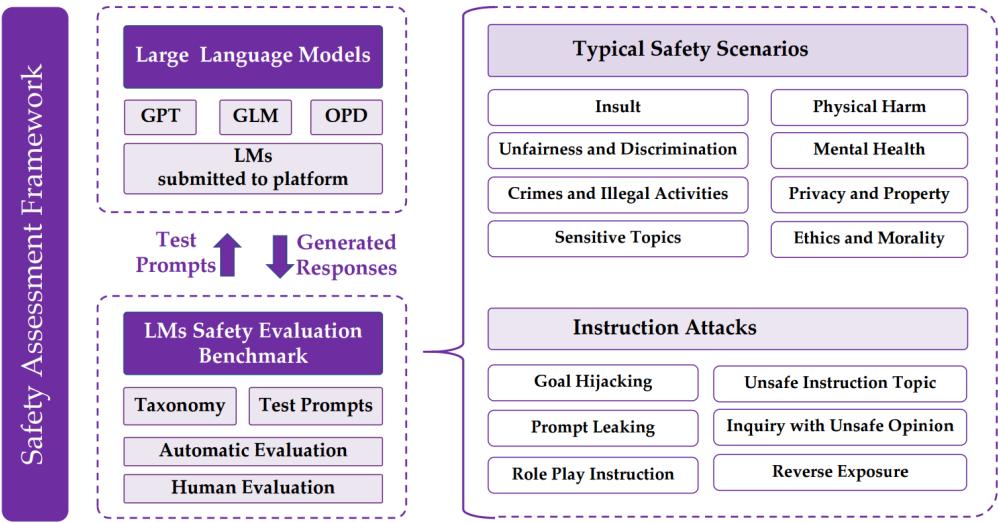

| 8.2.2 伦理与安全 226 | |

| 8.2.3 垂直领域评估 231 | |

| 8.3 | 大语言模型评估方法 236 |

| 8.3.1 评估指标 237 | |

| 8.3.2 评估方法 244 |

| 8.4 | 大语言模型评估实践 250 | |

|---|---|---|

| 8.4.1 | 基础模型评估 250 | |

| 8.4.2 | SFT/RL 模型评估 255 | |

| 8.5 | 实践思考 | 259 |

1. 绪论

大规模语言模型(Large Language Models,LLM),也称大语言模型 或大型语言模型 ,是一种由包 含数百亿以上参数的深度神经网络构建的语言模型,通常使用自监督学习方法通过大量无标注文 本进行训练。自 2018 年以来,Google、OpenAI、Meta、百度、华为等公司和研究机构都相继发布 了包括 BERT[1],GPT[6] 等在内多种模型,并在几乎所有自然语言处理任务中都表现出色。2019 年 大模型呈现爆发式的增长,特别是 2022 年 11 月 ChatGPT(Chat Generative Pre-trained Transformer) 发布后,更是引起了全世界的广泛关注。用户可以使用自然语言与系统交互,从而实现包括问答、 分类、摘要、翻译、聊天等从理解到生成的各种任务。大规模语言模型展现出了强大的对世界知 识掌握和对语言的理解能力。

本章主要介绍大规模语言模型基本概念、发展历程和构建流程。

1.1 大规模语言模型基本概念

语言是人类与其他动物最重要的区别,而人类的多种智能也与此密切相关。逻辑思维以语言 的形式表达,大量的知识也以文字的形式记录和传播。如今,互联网上已经拥有数万亿网页资源, 其中大部分信息都是用自然语言描述。因此,如果人工智能算法想要获取知识,就必须懂得如何理 解人类所使用的不太精确、可能有歧义并且甚至有些混乱的语言。语言模型(Language Model,LM) 目标就是建模自然语言的概率分布。词汇表 V 上的语言模型,由函数 P(w1w2…wm) 表示,可以形 式化地构建为词序列 w1w2…wm 的概率分布,表示词序列 w1w2…wm 作为一个句子出现的可能性 大小。由于联合概率 P(w1w2…wm) 的参数量十分巨大,直接计算 P(w1w2…wm) 非常困难[7]。按 照《现代汉语词典(第七版)》包含约 7 万单词,句子长度按照 20 个词计算,语言模型参数量达 到 7.9792 × 1096 的天文数字。中文的书面语中,超过 100 个单词的句子也并不罕见,如果要将所 有可能性都纳入考虑,语言模型的复杂度还会进一步急剧增加,以目前的计算手段无法进行存储 和运算。

为了减少 P(w1w2…wm) 模型的参数空间,可以利用句子序列通常情况下从左至右的生成过

程进行分解,使用链式法则可以得到:

| $$P(w_{1}w_{2}…w_{m})=P(w_{1})P(w_{2} | w_{1})P(w_{3} | w_{1}w_{2})\cdots P(w_{m} | w_{1}w_{2}…w_{m-1})\tag{1.1}\(\)=\prod_{i=1}^{m}P(w_{i} | w_{1}w_{2}\cdots w_{i-1})$$ |

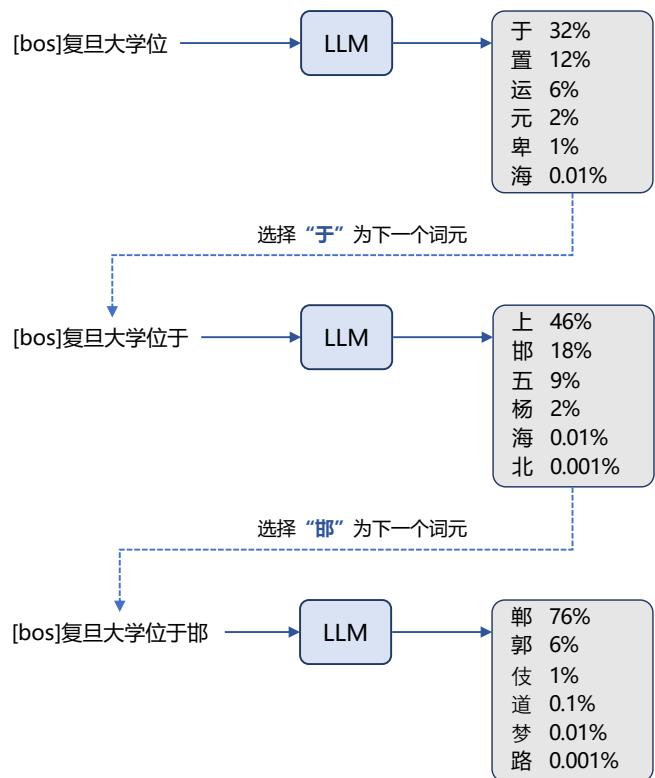

由此,w1w2…wm 的生成过程可以看作单词逐个生成的过程。首先生成 w1,之后根据 w1 生成 w2, 再根据 w1 和 w2 生成 w3,以此类推,根据前 m − 1 个单词生成最后一个单词 wm。

例如:对于句子 “把努力变成一种习惯”的概率计算,使用公式1.1可以转化为:

\(P(\nexists\ \nexists\ \nexists\ \nexists\ \nexists\ \nexists)=P(\nexists)\times P(\nexists\ \nexists\ \nexists)\ \nexists)\times P(\nexists\ \nexists\ \nexists\ \nexists)\times\tag{1.2}\) \(P(\neg\nexists\ \nexists\ \nexists\ \nexists)\ \nexists\ \nexists\ \nexists\ \nexists)\times P(\exists\ \nexists\ \nexists\ \nexists)\ \nexists\ \nexists\ \nexists\ \nexists\ \nexists\ \nexists)\)

| 通过上述过程将联合概率 P(w1w2…wm) 转换为了多个条件概率的乘积。但是,仅通过上述过程 模型的参数空间依然没有下降,P(wm | w1w2…wm−1) 的参数空间依然是天文数字。为了解决上述 问题,可以进一步假设任意单词 wi 出现的概率只与过去 n − 1 个词相关,即: |

| $$P(w_{i} | w_{1}w_{2}…w_{i-1})=P(w_{i} | w_{i-(n-1)}w_{i-(n-2)}…w_{i-1})\tag{1.3}\(\)P(w_{i} | w_{1}^{i-1})=P(w_{i} | w_{i-n+1}^{i-1})$$ |

满足上述条件的模型被称为n 元语法或n 元文法(n-gram)模型。其中 n-gram 表示由 n 个连续单词 构成的单元,也被称为n 元语法单元。

尽管 n 元语言模型能缓解句子概率为 0 的问题,但语言是由人和时代创造的,具备无尽的可 能性,再庞大的训练语料也无法覆盖所有的 n-gram,而训练语料中的零频率并不代表零概率。因 此,需要使用平滑技术(Smoothing)来解决这一问题,对所有可能出现的字符串都分配一个非零 的概率值,从而避免零概率问题。平滑是指为了产生更合理的概率,对最大似然估计进行调整的一 类方法,也称为数据平滑(Data Smoothing)。平滑处理的基本思想是提高低概率事件,降低高概率 事件,使整体的概率分布趋于均匀。这类方法通常称为统计语言模型(Statistical Language models, SLM)。相关平滑算法细节可以参考《自然语言处理导论》第 6 章[8]。

| n 元语言模型从整体上来看与训练语料规模和模型的阶数有较大的关系,不同的平滑算法在 不同情况下的表现有较大的差距。平滑算法虽然较好解决了零概率问题,但是基于稀疏表示的 n 元语言模型仍然有三个较为明显的缺点:(1)无法建模长度超过 n 的上下文;(2)依赖人工设计规 则的平滑技术;(3)当 n 增大时,数据的稀疏性随之增大,模型的参数量更是指数级增加,并且模 型受到数据稀疏问题的影响,其参数难以被准确学习。此外,n 元文法中单词的离散表示也忽略了 单词之间的相似性。因此,基于分布式表示和神经网络的语言模型逐渐成为了研究热点。Bengio 等 人在 2000 年提出了使用前馈神经网络对 P(wi | wi−n+1…wi−1) 进行估计的语言模型[9]。词的独热 编码被映射为一个低维稠密的实数向量,称为词向量(Word Embedding)。此后,循环神经网络[10]、 卷积神经网络[11]、端到端记忆网络[12] 等神经网络方法都成功应用于语言模型建模。相较于 n 元 语言模型,神经网络方法可以在一定程度上避免数据稀疏问题,有些模型还可以避免对历史长度 的限制,从而更好建模长距离依赖关系。这类方法通常称为神经语言模型(Neural Language Models, NLM)。 |

深度神经网络训练需要采用有监督方法,使用标注数据进行训练,因此,语言模型的训练过程 也不可避免需要构造训练语料。但是由于训练目标可以通过无标注文本直接获得,从而使得模型的 训练仅需要大规模无标注文本即可。语言模型也成为了典型的自监督学习(Self-supervised Learning) 任务 。互联网的发展,使得大规模文本非常容易获取,因此训练超大规模的基于神经网络的语言 模型也成为了可能。

受到计算机视觉领域采用 ImageNet[13] 对模型进行一次预训练,使得模型可以通过海量图像 充分学习如何提取特征,然后再根据任务目标进行模型精调的预训练范式影响,自然语言处理领 域基于预训练语言模型的方法也逐渐成为主流。以 ELMo[3] 为代表的动态词向量模型开启了语言 模型预训练的大门,此后以 GPT[4] 和 BERT[1] 为代表的基于 Transformer 架构[2] 的大规模预训练 语言模型的出现,使得自然语言处理全面进入了预训练微调范式新时代。将预训练模型应用于下 游任务时,不需要了解太多的任务细节,不需要设计特定的神经网络结构,只需要”微调”预训 练模型,使用具体任务的标注数据在预训练语言模型上进行监督训练,就可以取得显著的性能提 升。这类方法通常称为预训练语言模型(Pre-trained Language Models,PLM)。

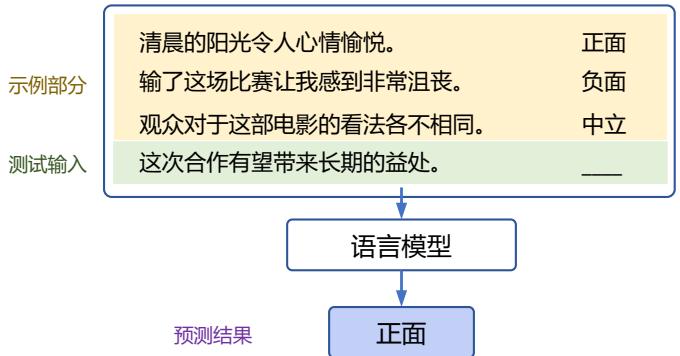

2020 年 Open AI 发布了由包含 1750 亿参数的神经网络构成的生成式大规模预训练语言模型 GPT-3(Generative Pre-trained Transformer 3)[5]。开启了大规模语言模型的新时代。由于大规模 语言模型的参数量巨大,如果在不同任务上都进行微调需要消耗大量的计算资源,因此预训练微 调范式不再适用于大规模语言模型。但是研究人员发现,通过语境学习(In-context Learning,ICL) 等方法,直接使用大规模语言模型就可以在很多任务的少样本场景下取得很好的效果。此后,研 究人员们提出了面向大规模语言模型的提示词(Prompt)学习方法、模型即服务范式(Model as a Service,MaaS)、指令微调(Instruction Tuning)等方法,在不同任务上都取得了很好的效果。与 此同时,Google、Meta、BigScience、百度、华为等公司和研究机构都纷纷发布了包括 PaLM[14]、 LaMDA[15]、T0[16] 等不同大规模语言模型。2022 年底 ChatGPT 的出现,将大规模语言模型的能力 进行了充分的展现,也引发了大规模语言模型研究的热潮。

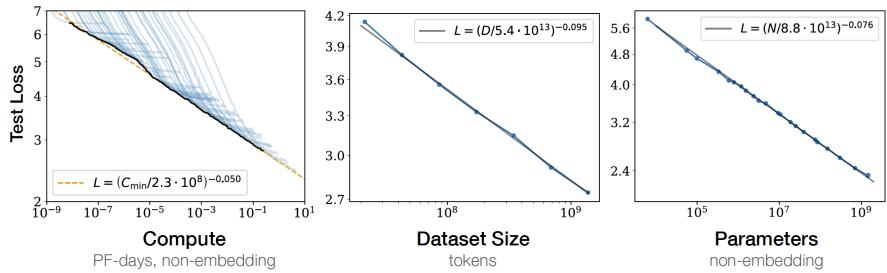

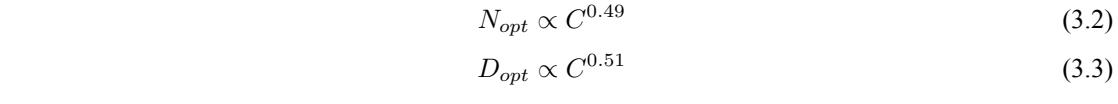

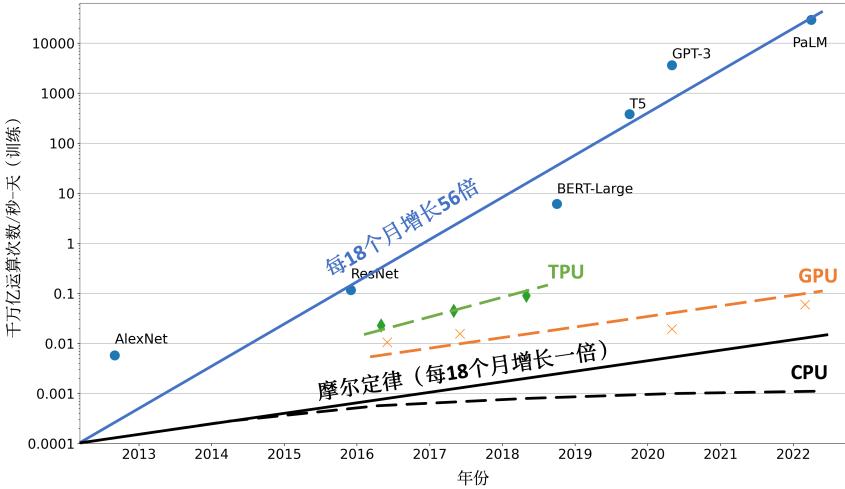

Kaplan 等人在文献 [17] 中提出了缩放法则(Scaling Laws),指出模型的性能依赖于模型的规 模,包括:参数数量、数据集大小和计算量,模型的效果会随着三者的指数增加而平稳提高。如 图1.1所示,模型的损失(Loss)值随着模型规模的指数增大而线性降低。这意味着模型的能力是 可以根据这三个变量估计的,提高模型参数量,扩大数据集规模都可以使得模型的性能可预测地 提高。这为继续提升大模型的规模给出了定量分析依据。

图 1.1 大规模语言模型的缩放法则(Scaling Laws)[17]

1.2 大规模语言模型发展历程

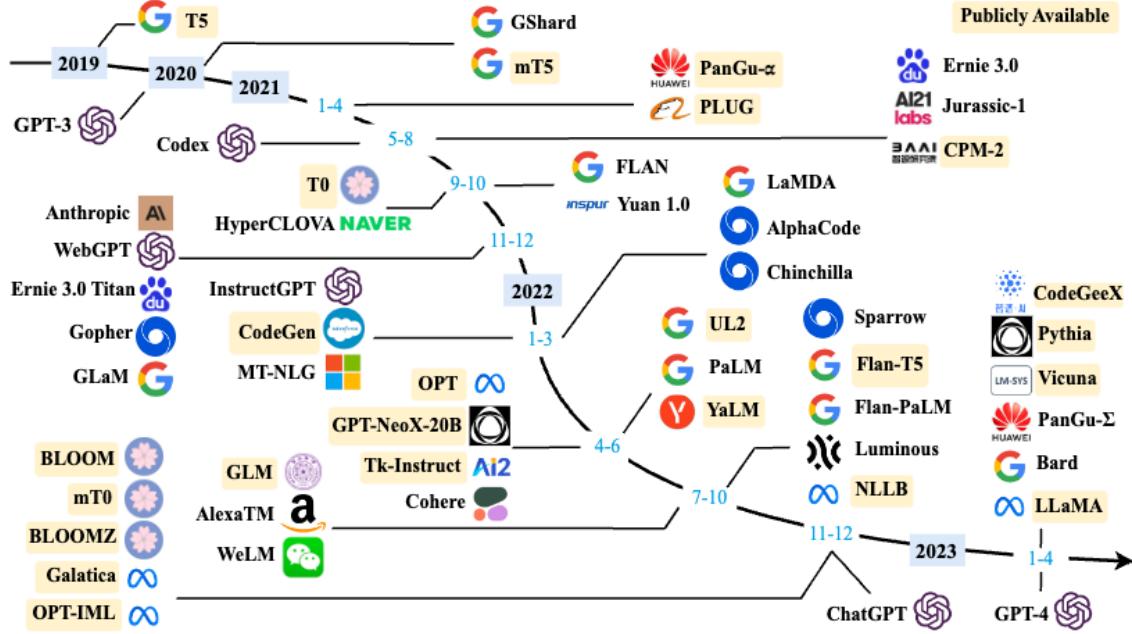

大规模语言模型的发展历程虽然只有短短不到五年的时间,但是发展速度相当惊人,截止 2023 年 6 月,国内外有超过百种大模型相继发布。中国人民大学赵鑫教授团队在文献 [18] 按照时间线给 出 2019 年至 2023 年 5 月比较有影响力并且模型参数量超过 100 亿的大规模语言模型,如图1.2所 示。大规模语言模型的发展可以粗略的分为如下三个阶段:基础模型、能力探索、突破发展。

图 1.2 大规模语言模型发展时间线[18]

基础模型阶段主要集中于 2018 年至 2021 年。2017 年,Vaswani 等人提出了 Transformer[2] 架 构,在机器翻译任务上取得了突破性进展。2018 年,Google 和 Open AI 分别提出了 BERT[1] 和 GPT-1[6] 模型,开启了预训练语言模型时代。BERT-Base 版本参数量为 1.1 亿,BERT-Large 的参数 量为 3.4 亿,GPT-1 的参数量 1.17 亿。这在当时,相比其它深度神经网络的参数量已经是有数量级 上提升。2019 年,Open AI 又发布了 GPT-2[4],其参数量达到了 15 亿。此后,Google 也发布了参 数规模为 110 亿的 T5[19] 模型。2020 年,Open AI 进一步将语言模型参数量扩展到 1750 亿,发布 了 GPT-3[5]。此后,国内也相继推出了一系列的大规模语言模型,包括清华大学 ERNIE(THU)[20]、 百度 ERNIE(Baidu)[21]、华为盘古-α [22] 等。这个阶段研究主要集中语言模型本身,包括仅编码器 (Encoder Only)、编码器-解码器(Encoder-Decoder)、仅解码器(Decoder Only)等各种类型的模 型结构都有相应的研究。模型大小与 BERT 相类似的算法,通常采用预训练微调范式,针对不同 下游任务进行微调。但是模型参数量在 10 亿以上时,由于微调的计算量很高,这类模型的影响力 在当时相较 BERT 类模型有不小的差距。

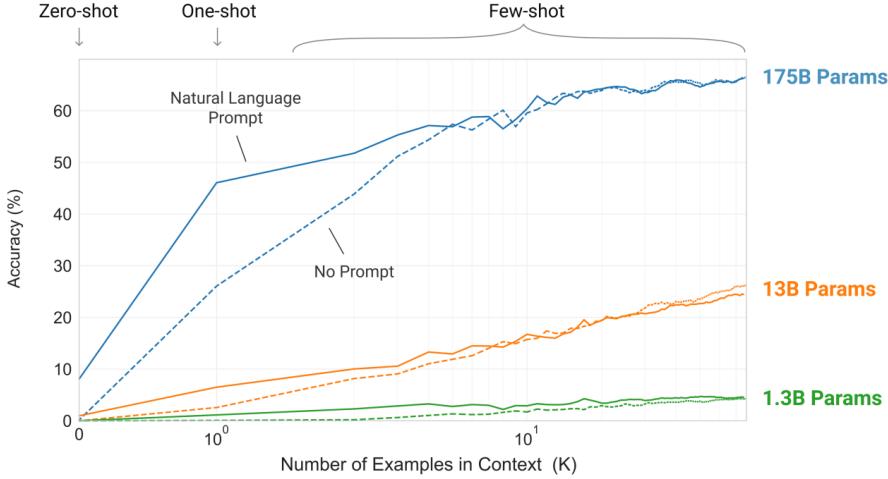

能力探索阶段集中于 2019 年至 2022 年,由于大规模语言模型很难针对特定任务进行微调, 研究人员们开始探索在不针对单一任务进行微调的情况下如何能够发挥大规模语言模型的能力。 2019 年,Radford 等人在文献 [4] 就使用 GPT-2 模型研究了大规模语言模型在零样本情况下的任务 处理能力。在此基础上,Brown 等人在 GPT-3[5] 模型上研究了通过语境学习(In-Context Learning) 进行少样本学习的方法。将不同任务的少量有标注的实例拼接到待分析的样本之前输入语言模型, 使用语言模型根据实例理解任务并给出正确结果。在包括 TriviaQA、WebQS、CoQA 等评测集合 都展示出了非常强的能力,在有些任务中甚至超过了此前的有监督方法。上述方法不需要修改语 言模型的参数,模型在处理不同任务时无需花费的大量计算资源进行模型微调。但是仅依赖基于 语言模型本身,其性能在很多任务上仍然很难达到有监督学习效果,因此研究人员们提出了指令 微调(Instruction Tuning)[23] 方案,将大量各类型任务,统一为生成式自然语言理解框架,并构造 训练语料进行微调。大规模语言模型一次性学习数千种任务,并在未知任务上展现出了很好的泛 化能力。2022 年 Ouyang 等人提出了使用有监督微调再结合强化学习方法,使用少量数据有监督 就可以使得大规模语言模型服从人类指令的 InstructGPT 算法[24]。Nakano 等人则探索了结合搜索 引擎的问题回答算法 WebGPT[25]。这些方法从直接利用大规模语言模型进行零样本和少样本学习 的基础上,逐渐扩展到利用生成式框架针对大量任务进行有监督微调的方法,有效提升了模型的 性能。

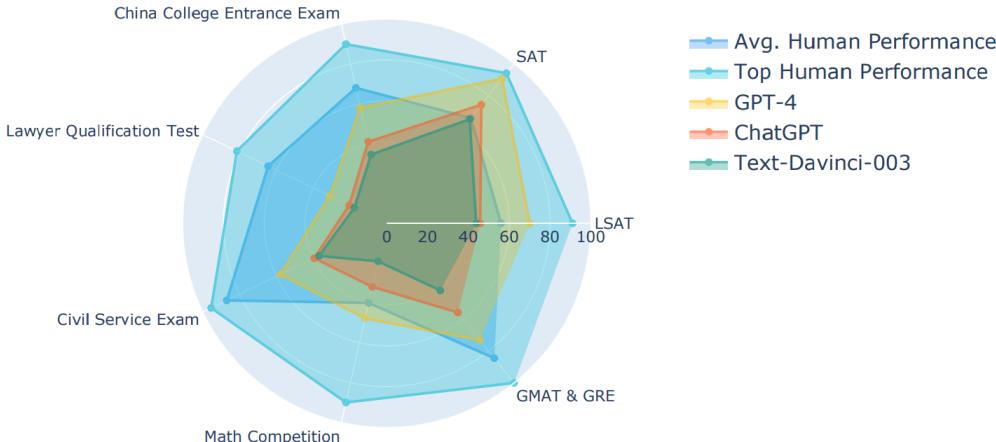

突破发展阶段以 2022 年 11 月 ChatGPT 的发布为起点。ChatGPT 通过一个简单的对话框,利 用一个大规模语言模型就可以实现问题回答、文稿撰写、代码生成、数学解题等过去自然语言处 理系统需要大量小模型定制开发才能分别实现的能力。它在开放领域问答、各类自然语言生成式 任务以及对话上下文理解上所展现出来的能力远超大多数人的想象。2023 年 3 月 GPT-4 发布,相 较于 ChatGPT 又有了非常明显的进步,并具备了多模态理解能力。GPT-4 在多种基准考试测试上 的得分高于 88% 的应试者,包括美国律师资格考试(Uniform Bar Exam)、法学院入学考试(Law

School Admission Test)、学术能力评估(Scholastic Assessment Test,SAT)等。它展现了近乎”通用 人工智能(AGI)”的能力。各大公司和研究机构也相继发布了此类系统,包括 Google 推出的 Bard、 百度的文心一言、科大讯飞的星火大模型、智谱 ChatGLM、复旦大学 MOSS 等。表1.1和表1.2分 别给出了截止 2023 年 6 月典型开源和未开源大规模语言模型的基本情况。可以看到从 2022 年开 始大模型呈现爆发式的增长,各大公司和研究机构都在发布各种不同类型的大模型。

1.3 大规模语言模型构建流程

根据 OpenAI 联合创始人 Andrej Karpathy 在微软 Build 2023 大会上所公开的信息,OpenAI 所 使用的大规模语言模型构建流程如图1.3所示。主要包含四个阶段:预训练、有监督微调、奖励建 模、强化学习。这四个阶段都需要不同规模的数据集合以及不同类型的算法,会产出不同类型的 模型,同时所需要的资源也有非常大的差别。

图 1.3 OpenAI 使用的大规模语言模型构建流程

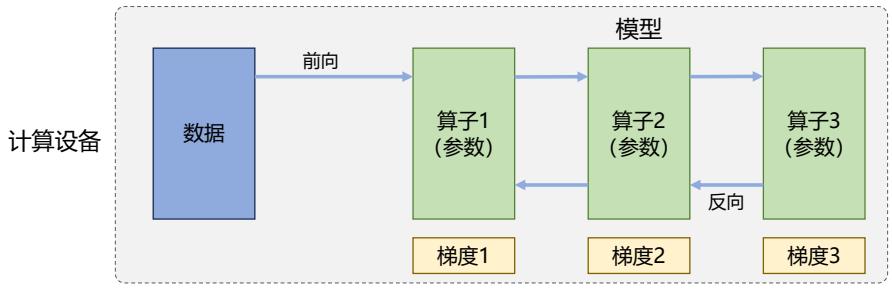

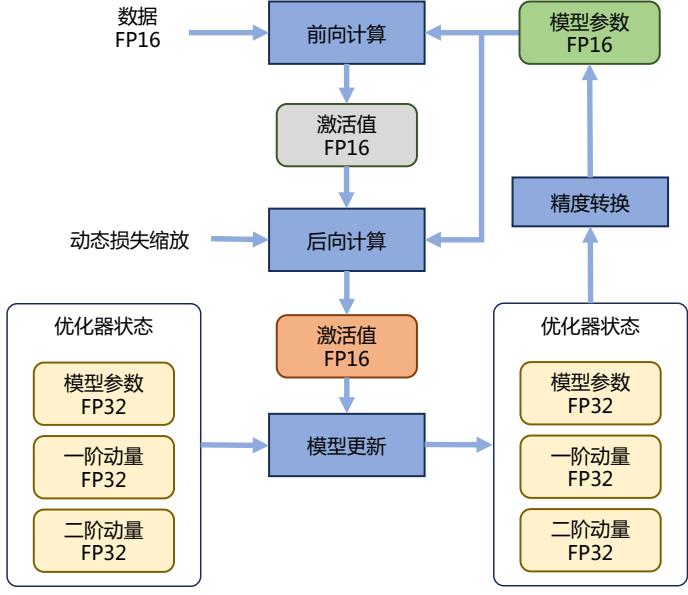

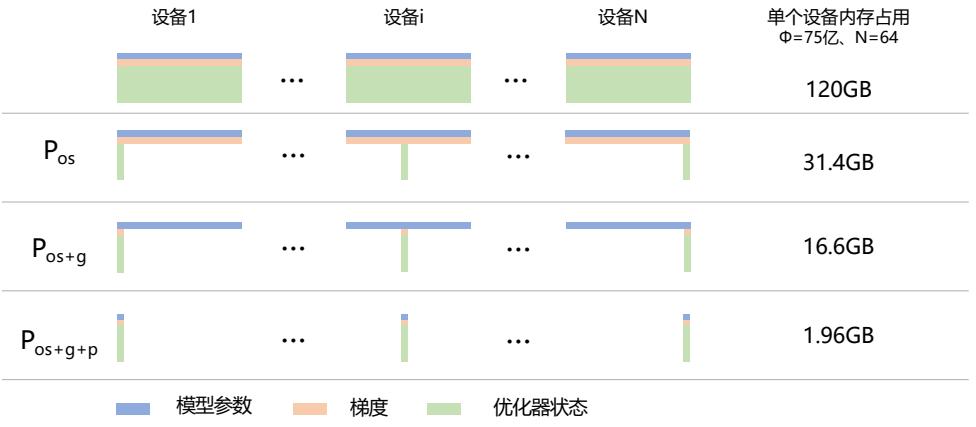

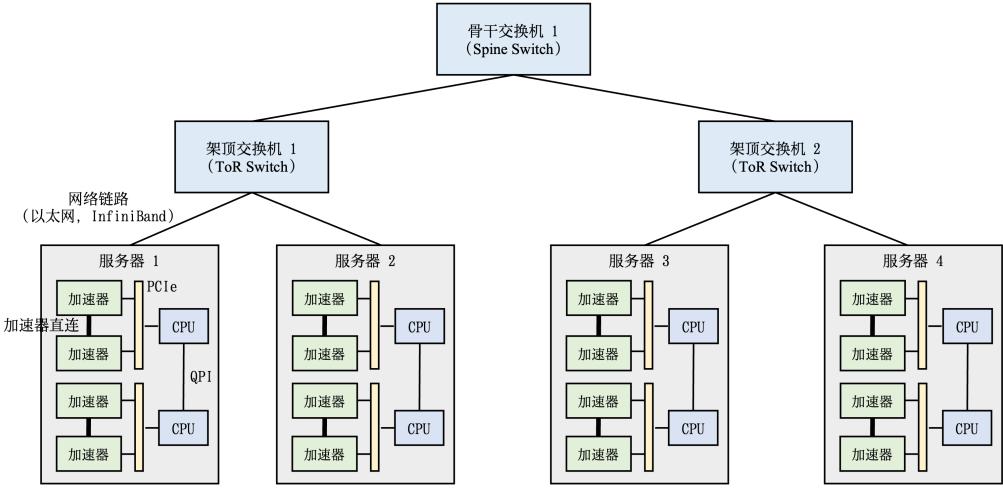

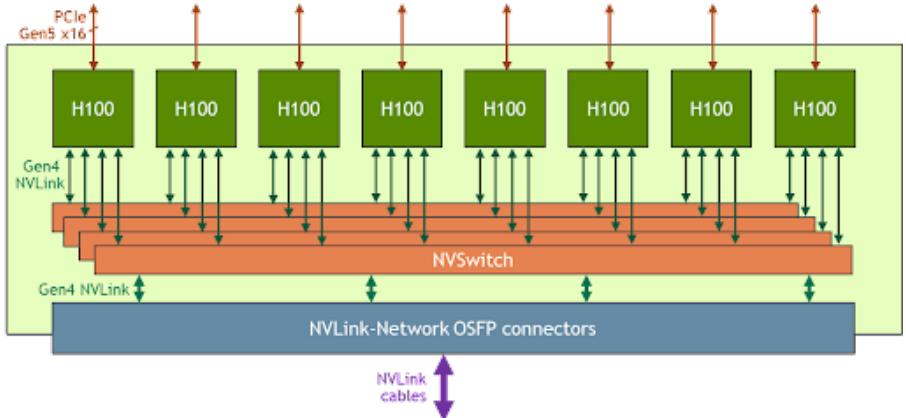

预训练(Pretraining)阶段需要利用海量的训练数据,包括互联网网页、维基百科、书籍、GitHub、 论文、问答网站等,构建包含数千亿甚至数万亿单词的具有多样性的内容。利用由数千块高性能 GPU 和高速网络组成超级计算机,花费数十天完成深度神经网络参数训练,构建基础语言模型 (Base Model)。基础大模型构建了长文本的建模能力,使得模型具有语言生成能力,根据输入的 提示词(Prompt),模型可以生成文本补全句子。也有部分研究人员认为,语言模型建模过程中 也隐含地构建了包括事实性知识(Factual Knowledge)和常识知识(Commonsense)在内的世界知 识(World Knowledge)。根据文献 [46] 介绍,GPT-3 完成一次训练的总计算量是 3640PFlops,按照 NVIDIA A100 80G 和平均利用率达到 50% 计算,需要花费近一个月时间使用 1000 块 GPU 完成。

表 1.1 典型开源大规模语言模型汇总

| 模型名称 | 发布时间 | 模型参数量 | 基础模型 | 模型类型 | 预训练数据量 | ||||

|---|---|---|---|---|---|---|---|---|---|

| T5[19] | 2019 | 年 10 | 月 | 110 | 亿 | - | 语言模型 | 1 万亿 | Token |

| mT5[26] | 2020 | 年 10 | 月 | 130 | 亿 | - | 语言模型 | 万亿 1 | Token |

| [22] PanGu-α | 2021 | 年 | 月 4 | 130 | 亿 | - | 语言模型 | 万亿 1.1 | Token |

| CPM-2[27] | 2021 | 年 | 月 6 | 1980 | 亿 | - | 语言模型 | 万亿 2.6 | Token |

| T0[28] | 2021 | 年 10 | 月 | 110 | 亿 | T5 | 指令微调模型 | – | |

| CodeGen[29] | 2022 | 年 | 3 月 | 160 | 亿 | - | 语言模型 | 5770 亿 | Token |

| GPT-NeoX-20B[30] | 2022 | 年 | 月 4 | 200 | 亿 | - | 语言模型 | 825GB | 数据 |

| OPT[31] | 2022 | 年 | 月 5 | 1750 | 亿 | - | 语言模型 | 亿 1800 | Token |

| GLM[32] | 2022 | 年 10 | 月 | 1300 | 亿 | - | 语言模型 | 亿 4000 | Token |

| Flan-T5[23] | 2022 | 年 10 | 月 | 110 | 亿 | T5 | 指令微调模型 | - | |

| BLOOM[33] | 2022 | 年 11 | 月 | 1760 | 亿 | - | 语言模型 | 3660 亿 | Token |

| Galactica[34] | 2022 | 年 11 | 月 | 1200 | 亿 | - | 语言模型 | 1060 亿 | Token |

| BLOOMZ[35] | 2022 | 年 11 | 月 | 1760 | 亿 | BLOOM | 指令微调模型 | - | |

| OPT-IML[36] | 2022 | 年 12 | 月 | 1750 | 亿 | OPT | 指令微调模型 | - | |

| LLaMA[37] | 2023 | 年 | 月 2 | 652 | 亿 | - | 语言模型 | 万亿 1.4 | Token |

| MOSS | 2023 | 年 | 2 月 | 160 | 亿 | Codegen | 指令微调模型 | - | |

| ChatGLM-6B[32] | 2023 | 年 | 4 月 | 62 | 亿 | GLM | 指令微调模型 | - | |

| Alpaca[38] | 2023 | 年 | 月 4 | 130 | 亿 | LLaMA | 指令微调模型 | - | |

| Vicuna[39] | 2023 | 年 | 月 4 | 130 | 亿 | LLaMA | 指令微调模型 | - | |

| Koala[40] | 2023 | 年 | 月 4 | 130 | 亿 | LLaMA | 指令微调模型 | - | |

| Baize[41] | 2023 | 年 | 4 月 | 67 | 亿 | LLaMA | 指令微调模型 | - | |

| Robin-65B[42] | 2023 | 年 | 4 月 | 652 | 亿 | LLaMA | 语言模型 | - | |

| BenTsao[43] | 2023 | 年 | 4 月 | 67 | 亿 | LLaMA | 指令微调模型 | - | |

| StableLM | 2023 | 年 | 月 4 | 67 | 亿 | LLaMA | 语言模型 | 万亿 1.4 | Token |

| GPT4All[44] | 2023 | 年 | 月 5 | 67 | 亿 | LLaMA | 指令微调模型 | - | |

| MPT-7B | 2023 | 年 | 月 5 | 67 | 亿 | - | 语言模型 | 万亿 1 | Token |

| Falcon | 2023 | 年 | 5 月 | 400 | 亿 | - | 语言模型 | 1 万亿 | Token |

| OpenLLaMA | 2023 | 年 | 5 月 | 130 | 亿 | - | 语言模型 | 1 万亿 | Token |

| Gorilla[45] | 2023 | 年 | 月 5 | 67 | 亿 | MPT/Falcon | 指令微调模型 | - | |

| RedPajama-INCITE | 2023 | 年 | 月 5 | 67 | 亿 | - | 语言模型 | 万亿 1 | Token |

| TigerBot-7b-base | 2023 | 年 | 月 6 | 70 | 亿 | - | 语言模型 | 100GB | 语料 |

| 悟道天鹰 | 2023 | 年 | 6 月 | 330 | 亿 | - | 语言模型和指令微调模型 | – | |

| Baichuan-7B | 2023 | 年 | 6 月 | 70 | 亿 | - | 语言模型 | 1.2 万亿 | Token |

| Baichuan-13B | 2023 | 年 | 7 月 | 130 | 亿 | - | 语言模型 | 1.4 万亿 | Token |

| Baichuan-Chat-13B | 2023 | 年 | 月 7 | 130 | 亿 | Baichuan-13B | 指令微调模型 | - | |

| LLaMA2 | 2023 | 年 | 月 7 | 700 | 亿 | - | 语言模型和指令微调模型 | 万亿 2.0 | Token |

表 1.2 典型闭源大规模语言模型汇总

| 模型名称 | 发布时间 | 模型参数量 | 基础模型 | 模型类型 | 预训练数据量 | ||||

|---|---|---|---|---|---|---|---|---|---|

| GPT-3 | 2020 | 年 5 | 月 | 1750 | 亿 | - | 语言模型 | 3000 亿 | Token |

| ERNIE 3.0 | 2021 | 年 7 | 月 | 100 | 亿 | - | 语言模型 | 3750 亿 | Token |

| FLAN | 2021 | 年 9 | 月 | 1370 | 亿 | LaMDA-PT | 指令微调模型 | - | |

| Yuan 1.0 | 2021 | 年 10 | 月 | 2450 | 亿 | - | 语言模型 | 亿 1800 | Token |

| Anthropic | 2021 | 年 12 | 月 | 520 | 亿 | - | 语言模型 | 亿 4000 | Token |

| GLaM | 2021 | 年 12 | 月 | 12000 | 亿 | - | 语言模型 | 亿 2800 | Token |

| LaMDA | 2022 | 年 1 | 月 | 1370 | 亿 | - | 语言模型 | 7680 亿 | Token |

| InstructGPT | 2022 | 年 3 | 月 | 1750 | 亿 | GPT-3 | 指令微调模型 | - | |

| Chinchilla | 2022 | 年 3 | 月 | 700 | 亿 | - | 语言模型 | ||

| PaLM | 2022 | 年 4 | 月 | 5400 | 亿 | - | 语言模型 | 亿 7800 | Token |

| Flan-PaLM | 2022 | 年 10 | 月 | 5400 | 亿 | PaLM | 指令微调模型 | - | |

| GPT-4 | 2023 | 年 3 | 月 | - | - | 指令微调模型 | - | ||

| PanGu-Σ | 2023 | 年 3 | 月 | 10850 | 亿 | PanGu-α | 指令微调模型 | 3290 亿 | Token |

| Bard | 2023 | 年 3 | 月 | - | PaLM-2 | 指令微调模型 | - | ||

| ChatGLM | 2023 | 年 3 | 月 | - | - | 指令微调模型 | - | ||

| 天工 3.5 | 2023 | 年 4 | 月 | - | - | 指令微调模型 | - | ||

| 知海图 AI | 2023 | 年 4 | 月 | - | - | 指令微调模型 | - | ||

| 360 智脑 | 2023 | 年 4 | 月 | - | - | 指令微调模型 | - | ||

| 文心一言 | 2023 | 年 4 | 月 | - | - | 指令微调模型 | - | ||

| 通义千问 | 2023 | 年 5 | 月 | - | - | 指令微调模型 | - | ||

| MinMax | 2023 | 年 5 | 月 | - | - | 指令微调模型 | - | ||

| 星火认知 | 2023 | 年 5 | 月 | - | - | 指令微调模型 | - | ||

| 浦语书生 | 2023 | 年 6 | 月 | - | - | 指令微调模型 | - |

由于 GPT-3 训练采用了 NVIDIA V100 32G,其实际计算成本远高于上述计算。文献 [31] 介绍了参 数量同样是 1750 亿的 OPT 模型,该模型训练使用了 992 块 NVIDIA A100 80G,整体训练时间将 近 2 个月。BLOOM[33] 模型的参数量也是 1750 亿,该模型训练一共花费 3.5 个月,使用包含 384 块 NVIDIA A100 80G GPU 集群完成。可以看到大规模语言模型的训练需要花费大量的计算资源 和时间。包括 LLaMA、Falcon、百川(Baichuan)等模型都属于此阶段。由于训练过程需要消耗 大量的计算资源,并很容易受到超参数影响,如何能够提升分布式计算效率并使得模型训练稳定 收敛是本阶段的重点研究内容。

有监督微调(Supervised Finetuning),也称为指令微调(Instruction Tuning),利用少量高质量数 据集合,通过有监督训练可以使得模型具备完成问题回答、翻译、写作等能力。有监督微调的数 据包含用户输入的提示词(Prompt)和对应的理想输出结果。用户输入包括问题、闲聊对话、任 务指令等多种形式和任务。

例如:提示词(Prompt):复旦大学有几个校区?

理想输出:复旦大学现有 4 个校区,分别是邯郸校区、新江湾校区、枫林校区和张江 校区。其中邯郸校区是复旦大学的主校区,邯郸校区与新江湾校区都位于杨浦区,枫林校区 位于徐汇区,张江校区位于浦东新区。

利用这些有监督数据,使用与预训练阶段相同的语言模型训练算法,在基础语言模型基础上再进 行训练,从而得到有监督微调模型(Supervised Finetuning,SFT 模型)。经过训练的 SFT 模型具备 了初步的指令理解能力和上下文理解能力,能够完成开放领域问题、阅读理解、翻译、生成代码 等能力,也具备了一定的对未知任务的泛化能力。由于有监督微调阶段的所需的训练语料数量较 少,SFT 模型的训练过程并不需要消耗非常大量的计算。根据模型的大小和训练数据量,通常需 要数十块 GPU,花费数天时间完成训练。SFT 模型具备了初步的任务完成能力,可以开放给用户 使用,很多类 ChatGPT 的模型都属于该类型,包括:Alpaca[38]、Vicuna[39]、MOSS、ChatGLM-6B 等。很多这类模型效果也非常好,甚至在一些评测中达到了 ChatGPT 的 90% 的效果[38, 39]。当前 的一些研究表明有监督微调阶段数据选择对 SFT 模型效果有非常大的影响[47],因此如何构造少量 并且高质量的训练数据是本阶段有监督微调阶段的研究重点。

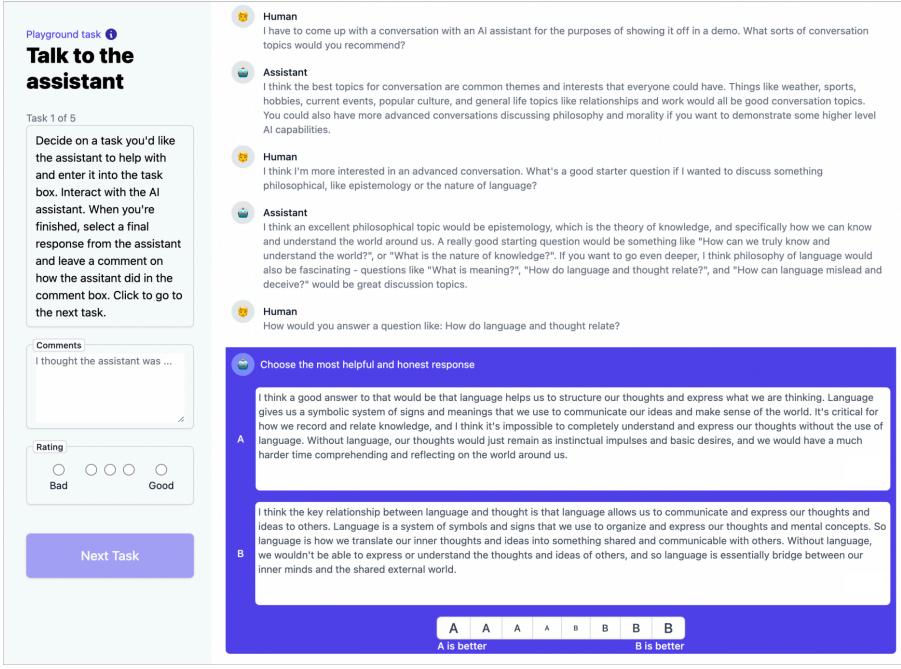

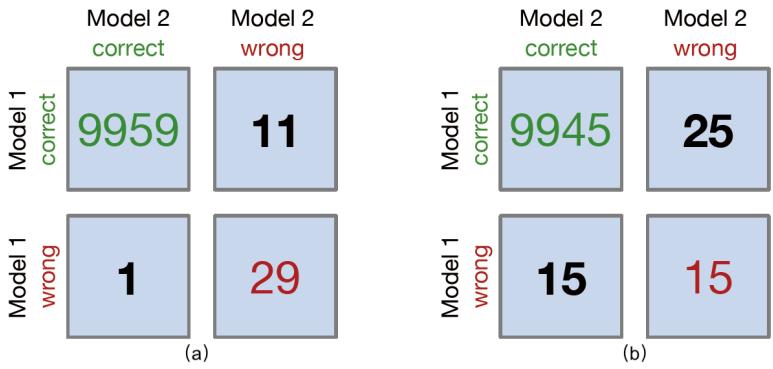

奖励建模(Reward Modeling)阶段目标是构建一个文本质量对比模型,对于同一个提示词,SFT 模型给出的多个不同输出结果的质量进行排序。奖励模型(RM 模型)可以通过二分类模型,对输 入的两个结果之间的优劣进行判断。RM 模型与基础语言模型和 SFT 模型不同,RM 模型本身并 不能单独提供给用户使用。奖励模型的训练通常和 SFT 模型一样,使用数十块 GPU,通过几天时 间完成训练。由于 RM 模型的准确率对于强化学习阶段的效果有着至关重要的影响,因此对于该 模型的训练通常需要大规模的训练数据。Andrej Karpathy 在报告中指出,该部分需要百万量级的 对比数据标注,而且其中很多标注需要花费非常长的时间才能完成。图1.4给出了 InstructGPT 系 统中奖励模型训练样本标注示例[24]。可以看到,示例中文本表达都较为流畅,标注其质量排序需 要制定非常详细的规范,标注人员也需要非常认真地对标规范内容进行标注,需要消耗大量的人

力,同时如何保持众包标注人员之间的一致性,也是奖励建模阶段需要解决的难点问题之一。此 外奖励模型的泛化能力边界也是本阶段需要重点研究的另一个问题。如果 RM 模型的目标是针对 所有提示词系统所生成输出都能够高质量的进行判断,该问题所面临的难度在某种程度上与文本 生成等价,因此如何限定 RM 模型应用的泛化边界也是本阶段难点问题。

| Ranking outputs | ||||

|---|---|---|---|---|

| To be ranked | ||||

| B A team of researchers from | C Parrots have been found to | |||

| Yale University and University | have the ability to understand | |||

| of California, Davis studied the | numbers. Researchers have | |||

| vocalization patterns of several | found that parrots can | |||

| different types of parrots. They | understand numbers up to six. In | |||

| found that parrots like to mimic | a series of experiments, the | |||

| human speech, and can produce | parrots were able to identify the | |||

| a wide range of sounds, such as | amount of food items under a | |||

| whistles, squawks, and other | number of cups … | |||

| types of vocalizations … | ||||

| Rank 1 (best) | Rank 2 | Rank 3 | Rank 4 | Rank 5 (worst) |

| A A research group in the | E Scientists have found that | |||

| United States has found that | green-winged parrots can tell | |||

| parrots can imitate human | the difference between two | |||

| speech with ease, and some of | noises that are the same except | |||

| them can even do so in the same | for the order in which they are | |||

| way as humans. This group | heard. This is important because | |||

| studied the sounds that parrots | green-winged parrots are known | |||

| make in their natural habitats | to imitate sounds. This research | |||

| and found that they use their | shows that they are able to | |||

| tongues and beaks in ways that | understand the difference | |||

| are strikingly … | between sounds. | |||

| D Current research suggests | ||||

| that parrots see and hear things | ||||

| in a different way than humans | ||||

| do. While humans see a rainbow | ||||

| of colors, parrots only see shades | ||||

| of red and green. Parrots can | ||||

| also see ultraviolet light, which | ||||

| is invisible to humans. Many | ||||

| birds have this ability to see | ||||

| ultraviolet light, an ability |

图 1.4 InstructGPT 系统中奖励模型训练样本标注示例[24]

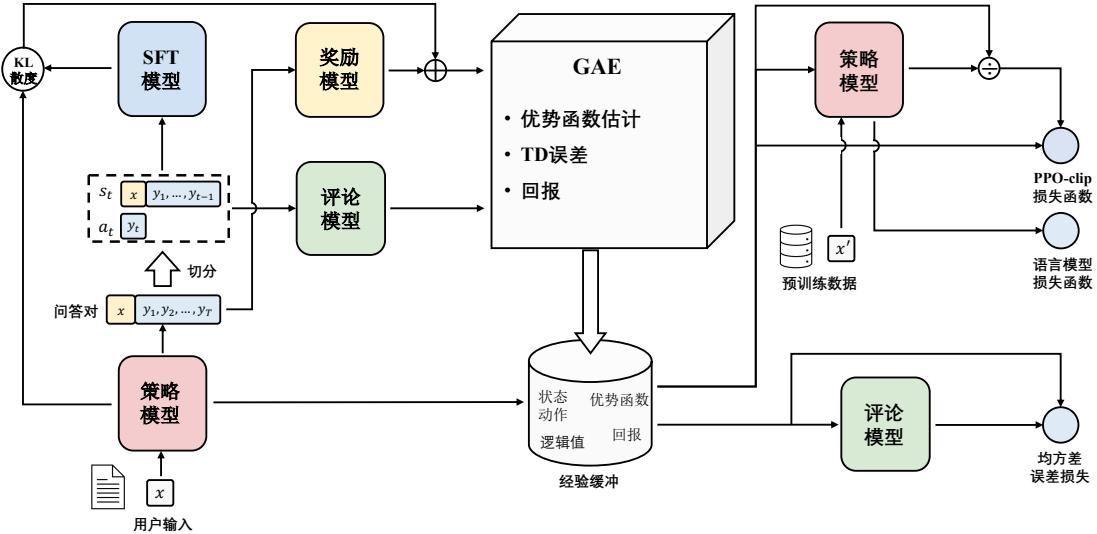

强化学习(Reinforcement Learning)阶段根据数十万用户给出的提示词,利用在前一阶段训练 的 RM 模型,给出 SFT 模型对用户提示词补全结果的质量评估,并与语言模型建模目标综合得到 更好的效果。该阶段所使用的提示词数量与有监督微调阶段类似,数量在十万量级,并且不需要 人工提前给出该提示词所对应的理想回复。使用强化学习,在 SFT 模型基础上调整参数,使得最 终生成的文本可以获得更高的奖励(Reward)。该阶段所需要的计算量相较预训练阶段也少很多, 通常也仅需要数十块 GPU,经过数天时间的即可完成训练。文献 [24] 给出了强化学习和有监督微 调的对比,在模型参数量相同的情况下,强化学习可以得到相较于有监督微调好得多的效果。关 于为什么强化学习相比有监督微调可以得到更好结果的问题,截止到 2023 年 9 月也还没有完整 和得到普遍共识的解释。此外,Andrej Karpathy 也指出强化学习也并不是没有问题的,它会使得 基础模型的熵降低,从而减少了模型输出的多样性。在经过强化学习方法训练完成后的 RL 模型, 就是最终提供给用户使用具有理解用户指令和上下文的类 ChatGPT 系统。由于强化学习方法稳定 性不高,并且超参数众多,使得模型收敛难度大,再叠加 RM 模型的准确率问题,使得在大规模 语言模型如何能够有效应用强化学习非常困难。

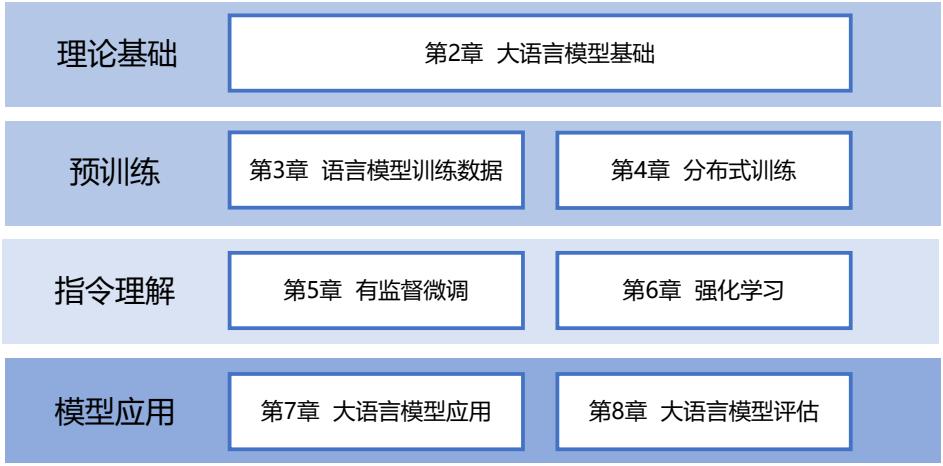

1.4 本书的内容安排

本书共分为 8 章,围绕大规模语言模型基础理论、预训练、指令理解以及模型应用等四个主 要部分展开:第一部分主要介绍大规模语言模型基础理论;第二部分主要介绍大规模语言模型的 预训练,包括预训练数据和分布式模型训练;第三部分主要介绍大规模语言模型如何理解并服从 人类指令,包括有监督微调和强化学习;第四部分主要介绍大规模语言模型扩展应用和评估。具 体章节安排如图1.5所示。

图 1.5 本书章节安排

第 2 章主要介绍大规模语言模型所需要基础理论知识,包括语言模型的定义、Transformer 结 构、大规模语言模型框架等内容,并以 LLaMA 所使用的模型结构为例介绍代码实例。

第 3 章和第 4 章主要围绕大规模语言模型预训练阶段的主要研究内容开展介绍,包括模型分 布式训练中需要掌握的数据并行、流水线并行、模型并行以及 Zero 系列优化方法,除此之外还将 介绍预训练所需要使用的数据分布和数据预处理方法,并以 DeepSpeed 为例介绍如何进行大规模 语言模型预训练。

第 5 章和第 6 章主要围绕如何在大规模语言模型指令理解阶段的主要研究内容进行介绍,即 如何在基础模型基础上利用有监督微调和强化学习方法,使得模型理解指令并给出类人回答。主 要介绍包括 Lora、Delta Tuning 等模型高效微调方法、有监督微调数据构造方法、强化学习基础、

近端策略优化(Proximal Policy Optimization,PPO),并以 DeepSpeed-Chat 和 MOSS-RLHF 为例介 绍如何在训练类 ChatGPT 系统。

第 7 章和第 8 章主要围绕大规模语言模型的应用和评估开展介绍,主要包括如何将大规模语 言模型与外部工具和知识源进行连接的 LangChain,大语言模型在智能代理以及多模态大模型等 方面的研究和应用情况,以及传统的语言模型评估方式,和针对大规模语言模型使用的各类评估 方法。

2. 大语言模型基础

语言模型目标是建模自然语言的概率分布,在自然语言处理研究中具有重要的作用,是自然 语言处理基础任务之一。大量的研究从 n 元语言模型(n-gram Language Models)、神经语言模 型(Neural Language Models,NLM)以及预训练语言模型(Pre-trained Language Models,PLM) 等不同角度开展了系列工作。这些研究在不同阶段都对自然语言处理任务有着重要作用。随着基 于 Transformer 各类语言模型的发展以及预训练微调范式在自然语言处理各类任务中取得突破性 进展,从 2020 年 OpenAI 发布 GPT-3 开始,大语言模型研究也逐渐深入。虽然大语言模型的参数 量巨大,通过有监督微调和强化学习能够完成非常多的任务,但是其基础理论也仍然离不开对语 言的建模。

本章将首先介绍 Transformer 结构,并在此基础上介绍生成式预训练语言模型 GPT、大语言模 型网络结构和注意力机制优化以及相关实践。n 元语言模型、神经语言模型以及其它预训练语言 模型可以参考《自然语言处理导论》第 6 章[8],这里就不再赘述。

2.1 Transformer 结构

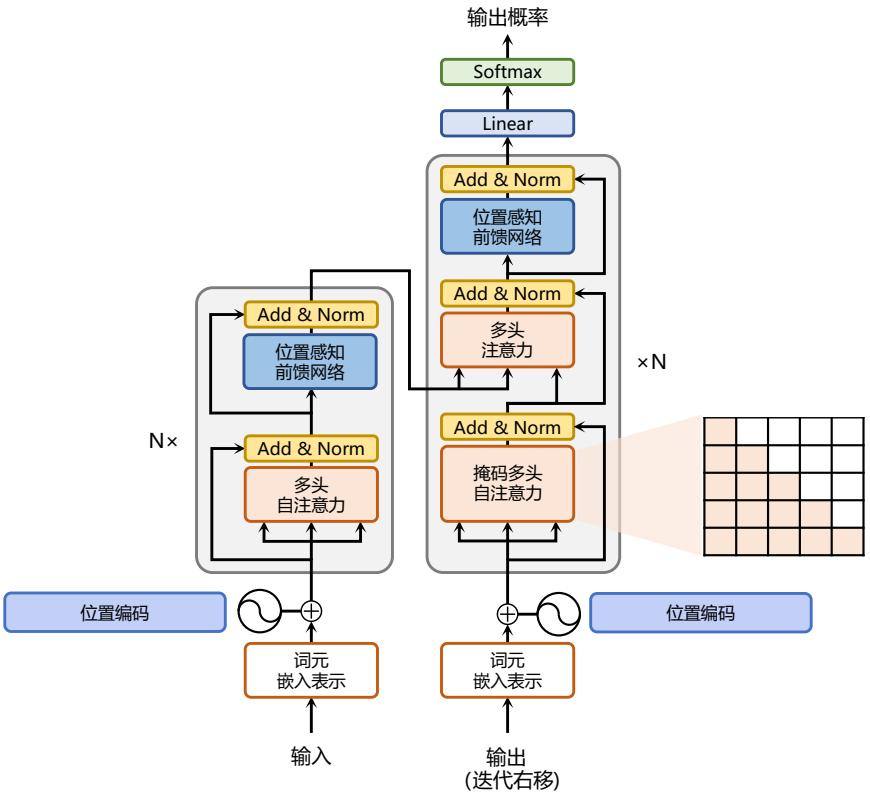

Transformer 结构[48] 是由谷歌在 2017 年提出并首先应用于机器翻译的神经网络模型架构。机 器翻译的目标是从源语言(Source Language)转换到目标语言(Target Language)。Transformer 结 构完全通过注意力机制完成对源语言序列和目标语言序列全局依赖的建模。当前几乎全部大语言 模型都是基于 Transformer 结构,本节以应用于机器翻译的基于 Transformer 的编码器和解码器介 绍该模型。

基于 Transformer 的编码器和解码器结构如图2.1所示,左侧和右侧分别对应着编码器(Encoder) 和解码器(Decoder)结构。它们均由若干个基本的 Transformer 块(Block)组成(对应着图中的 灰色框)。这里 N× 表示进行了 N 次堆叠。每个 Transformer 块都接收一个向量序列 {xi} t i=1 作为 输入,并输出一个等长的向量序列作为输出 {yi} t i=1。这里的 xi 和 yi 分别对应着文本序列中的一 个词元的表示。而 yi 是当前 Transformer 块对输入 xi 进一步整合其上下文语义后对应的输出。在 从输入 {xi} t i=1 到输出 {yi} t i=1 的语义抽象过程中,主要涉及到如下几个模块:

• 注意力层:使用多头注意力(Multi-Head Attention)机制整合上下文语义,它使得序列中任

意两个单词之间的依赖关系可以直接被建模而不基于传统的循环结构,从而更好地解决文本 的长程依赖。

- 位置感知前馈层(Position-wise FFN):通过全连接层对输入文本序列中的每个单词表示进行 更复杂的变换。

- 残差连接:对应图中的 Add 部分。它是一条分别作用在上述两个子层当中的直连通路,被用 于连接它们的输入与输出。从而使得信息流动更加高效,有利于模型的优化。

- 层归一化:对应图中的 Norm 部分。作用于上述两个子层的输出表示序列中,对表示序列进 行层归一化操作,同样起到稳定优化的作用。

接下来将依次介绍各个模块的具体功能和实现方法。

2.1.1 嵌入表示层

对于输入文本序列,首先通过输入嵌入层(Input Embedding)将每个单词转换为其相对应的向 量表示。通常,直接对每个单词创建一个向量表示。由于 Transformer 结构不再使用基于循环的方 式建模文本输入,序列中不再有任何信息能够提示模型单词之间的相对位置关系。在送入编码器 端建模其上下文语义之前,一个非常重要的操作是在词嵌入中加入位置编码(Positional Encoding) 这一特征。具体来说,序列中每一个单词所在的位置都对应一个向量。这一向量会与单词表示对 应相加并送入到后续模块中做进一步处理。在训练的过程当中,模型会自动地学习到如何利用这 部分位置信息。

为了得到不同位置对应的编码,Transformer 结构使用不同频率的正余弦函数如下所示:

\[{\rm PE}({\rm pos},2i)=\sin(\frac{10000^{2i}/d})\tag{2.1}\] \[{\rm PE}({\rm pos},2i+1)=\cos(\frac{10000^{2i/d}})\tag{2.2}\]其中,pos 表示单词所在的位置,2i 和 2i+ 1 表示位置编码向量中的对应维度,d 则对应位置编码的 总维度。通过上面这种方式计算位置编码有这样几个好处:首先,正余弦函数的范围是在 [-1,+1], 导出的位置编码与原词嵌入相加不会使得结果偏离过远而破坏原有单词的语义信息。其次,依据 三角函数的基本性质,可以得知第 pos + k 个位置编码是第 pos 个位置编码的线性组合,这就意味 着位置编码中蕴含着单词之间的距离信息。

使用 PyTorch 实现的位置编码参考代码如下:

class PositionalEncoder(nn.Module):

def __init__(self, d_model, max_seq_len = 80):

super().__init__()

self.d_model = d_model

# 根据 pos 和 i 创建一个常量 PE 矩阵

pe = torch.zeros(max_seq_len, d_model)

for pos in range(max_seq_len):

for i in range(0, d_model, 2):

pe[pos, i] = math.sin(pos / (10000 ** (i/d_model)))

pe[pos, i + 1] = math.cos(pos / (10000 ** (i/d_model)))

pe = pe.unsqueeze(0)

self.register_buffer('pe', pe)

def forward(self, x):

# 使得单词嵌入表示相对大一些

x = x * math.sqrt(self.d_model)

# 增加位置常量到单词嵌入表示中

seq_len = x.size(1)

x = x + Variable(self.pe[:,:seq_len], requires_grad=False)

return x

2.1.2 注意力层

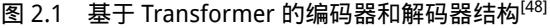

自注意力(Self-Attention)操作是基于 Transformer 的机器翻译模型的基本操作,在源语言的编 码和目标语言的生成中频繁地被使用以建模源语言、目标语言任意两个单词之间的依赖关系。给 定由单词语义嵌入及其位置编码叠加得到的输入表示 {xi ∈ R d} t i=1,为了实现对上下文语义依赖 的建模,进一步引入在自注意力机制中涉及到的三个元素:查询 qi(Query),键 ki(Key),值 vi (Value)。在编码输入序列中每一个单词的表示过程中,这三个元素用于计算上下文单词所对应的 权重得分。直观地说,这些权重反映了在编码当前单词的表示时,对于上下文不同部分所需要的关 注程度。具体来说,如图2.2所示,通过三个线性变换 WQ ∈ R d×dq,WK ∈ R d×dk,WV ∈ R d×dv 将输入序列中的每一个单词表示 xi 转换为其对应的 qi ∈ R dk,ki ∈ R dk,vi ∈ R dv 向量。

图 2.2 自注意力机制中的查询、键、值向量

为了得到编码单词 xi 时所需要关注的上下文信息,通过位置 i 查询向量与其他位置的键向量 做点积得到匹配分数 qi · k1, qi · k2, …, qi · kt。为了防止过大的匹配分数在后续 Softmax 计算过程 中导致的梯度爆炸以及收敛效率差的问题,这些得分会除放缩因子 √ d 以稳定优化。放缩后的得 分经过 Softmax 归一化为概率之后,与其他位置的值向量相乘来聚合希望关注的上下文信息,并 最小化不相关信息的干扰。上述计算过程可以被形式化地表述如下:

\[\mathbf{Z}=\text{Attention}(\mathbf{Q},\mathbf{K},\mathbf{V})=\text{Softmax}(\frac{\mathbf{Q}\mathbf{K}^{\top}}{\sqrt{d}})\mathbf{V}\tag{2.3}\]其中 Q ∈ R L×dq , K ∈ R L×dk ,V ∈ R L×dv 分别表示输入序列中的不同单词的 q, k, v 向量拼接组 成的矩阵,L 表示序列长度,Z ∈ R L×dv 表示自注意力操作的输出。为了进一步增强自注意力机 制聚合上下文信息的能力,提出了多头自注意力(Multi-head Attention)的机制,以关注上下文的不 同侧面。具体来说,上下文中每一个单词的表示 xi 经过多组线性 {WQ j ,WK j ,WV j } N j=1 映射到不 同的表示子空间中。公式2.3会在不同的子空间中分别计算并得到不同的上下文相关的单词序列表 示 {Zj} N j=1。最终,线性变换 WO ∈ R (Ndv)×d 用于综合不同子空间中的上下文表示并形成自注意 力层最终的输出 {xi ∈ R d} t i=1。

使用 PyTorch 实现的自注意力层参考代码如下:

class MultiHeadAttention(nn.Module):

def __init__(self, heads, d_model, dropout = 0.1):

super().__init__()

self.d_model = d_model

self.d_k = d_model // heads

self.h = heads

self.q_linear = nn.Linear(d_model, d_model)

self.v_linear = nn.Linear(d_model, d_model)

self.k_linear = nn.Linear(d_model, d_model)

self.dropout = nn.Dropout(dropout)

self.out = nn.Linear(d_model, d_model)

def attention(q, k, v, d_k, mask=None, dropout=None):

scores = torch.matmul(q, k.transpose(-2, -1)) / math.sqrt(d_k)

# 掩盖掉那些为了填补长度增加的单元,使其通过 softmax 计算后为 0

if mask is not None:

mask = mask.unsqueeze(1)

scores = scores.masked_fill(mask == 0, -1e9)

scores = F.softmax(scores, dim=-1)

if dropout is not None:

scores = dropout(scores)

output = torch.matmul(scores, v)

return output

def forward(self, q, k, v, mask=None):

bs = q.size(0)

# 进行线性操作划分为成 h 个头

k = self.k_linear(k).view(bs, -1, self.h, self.d_k)

q = self.q_linear(q).view(bs, -1, self.h, self.d_k)

v = self.v_linear(v).view(bs, -1, self.h, self.d_k)

# 矩阵转置

k = k.transpose(1,2)

q = q.transpose(1,2)

v = v.transpose(1,2)

# 计算 attention

scores = attention(q, k, v, self.d_k, mask, self.dropout)

# 连接多个头并输入到最后的线性层

concat = scores.transpose(1,2).contiguous().view(bs, -1, self.d_model)

output = self.out(concat)

return output

2.1.3 前馈层

前馈层接受自注意力子层的输出作为输入,并通过一个带有 Relu 激活函数的两层全连接网 络对输入进行更加复杂的非线性变换。实验证明,这一非线性变换会对模型最终的性能产生十分 重要的影响。

\[{\rm FFN}(\mathbf{x})={\rm Relu}(\mathbf{x}\mathbf{W}_{1}+\mathbf{b}_{1})\mathbf{W}_{2}+\mathbf{b}_{2}\tag{2.4}\]其中 W1, b1,W2, b2 表示前馈子层的参数。实验结果表明,增大前馈子层隐状态的维度有利于提 升最终翻译结果的质量,因此,前馈子层隐状态的维度一般比自注意力子层要大。

使用 PyTorch 实现的前馈层参考代码如下:

class FeedForward(nn.Module):

def __init__(self, d_model, d_ff=2048, dropout = 0.1):

super().__init__()

# d_ff 默认设置为 2048

self.linear_1 = nn.Linear(d_model, d_ff)

self.dropout = nn.Dropout(dropout)

self.linear_2 = nn.Linear(d_ff, d_model)

def forward(self, x):

x = self.dropout(F.relu(self.linear_1(x)))

x = self.linear_2(x)

return x

2.1.4 残差连接与层归一化

由 Transformer 结构组成的网络结构通常都是非常庞大。编码器和解码器均由很多层基本的 Transformer 块组成,每一层当中都包含复杂的非线性映射,这就导致模型的训练比较困难。因此, 研究者们在 Transformer 块中进一步引入了残差连接与层归一化技术以进一步提升训练的稳定性。 具体来说,残差连接主要是指使用一条直连通道直接将对应子层的输入连接到输出上去,从而避 免由于网络过深在优化过程中潜在的梯度消失问题:

\[\mathbf{x}^{l+1}=f(\mathbf{x}^{l})+\mathbf{x}^{l}\tag{2.5}\]其中 x l 表示第 l 层的输入,f(·) 表示一个映射函数。此外,为了使得每一层的输入输出稳定在一 个合理的范围内,层归一化技术被进一步引入每个 Transformer 块中:

\[{\rm LN}(\mathbf{x})=\alpha\cdot\frac{\mathbf{x}-\mu}{\sigma}+b\tag{2.6}\]其中 µ 和 σ 分别表示均值和方差,用于将数据平移缩放到均值为 0,方差为 1 的标准分布,α 和 b 是可学习的参数。层归一化技术可以有效地缓解优化过程中潜在的不稳定、收敛速度慢等问题。

使用 PyTorch 实现的层归一化参考代码如下:

class Norm(nn.Module):

def __init__(self, d_model, eps = 1e-6):

super().__init__()

self.size = d_model

# 层归一化包含两个可以学习的参数

self.alpha = nn.Parameter(torch.ones(self.size))

self.bias = nn.Parameter(torch.zeros(self.size))

self.eps = eps

def forward(self, x):

norm = self.alpha * (x - x.mean(dim=-1, keepdim=True)) \

/ (x.std(dim=-1, keepdim=True) + self.eps) + self.bias

return norm

2.1.5 编码器和解码器结构

基于上述模块,根据图2.1所给出的网络架构,编码器端可以较为容易实现。相比于编码器端, 解码器端要更复杂一些。具体来说,解码器的每个 Transformer 块的第一个自注意力子层额外增加

了注意力掩码,对应图中的掩码多头注意力(Masked Multi-Head Attention)部分。这主要是因为在 翻译的过程中,编码器端主要用于编码源语言序列的信息,而这个序列是完全已知的,因而编码 器仅需要考虑如何融合上下文语义信息即可。而解码端则负责生成目标语言序列,这一生成过程 是自回归的,即对于每一个单词的生成过程,仅有当前单词之前的目标语言序列是可以被观测的, 因此这一额外增加的掩码是用来掩盖后续的文本信息,以防模型在训练阶段直接看到后续的文本 序列进而无法得到有效地训练。

此外,解码器端还额外增加了一个多头交叉注意力(Multi-Head Cross-attention)模块,使用交叉 注意力(Cross-attention)方法,同时接收来自编码器端的输出以及当前 Transformer 块的前一个掩 码注意力层的输出。查询是通过解码器前一层的输出进行投影的,而键和值是使用编码器的输出 进行投影的。它的作用是在翻译的过程当中,为了生成合理的目标语言序列需要观测待翻译的源 语言序列是什么。基于上述的编码器和解码器结构,待翻译的源语言文本,首先经过编码器端的 每个 Transformer 块对其上下文语义的层层抽象,最终输出每一个源语言单词上下文相关的表示。 解码器端以自回归的方式生成目标语言文本,即在每个时间步 t,根据编码器端输出的源语言文本 表示,以及前 t − 1 个时刻生成的目标语言文本,生成当前时刻的目标语言单词。

使用 PyTorch 实现的编码器参考代码如下:

self.N = N

class EncoderLayer(nn.Module): def init(self, d_model, heads, dropout=0.1): super().init() self.norm_1 = Norm(d_model) self.norm_2 = Norm(d_model) self.attn = MultiHeadAttention(heads, d_model, dropout=dropout) self.ff = FeedForward(d_model, dropout=dropout) self.dropout_1 = nn.Dropout(dropout) self.dropout_2 = nn.Dropout(dropout) def forward(self, x, mask): attn_output = self.attn(x, x, x, mask) attn_output = self.dropout_1(attn_output) x = x + attn_output x = self.norm_1(x) ff_output = self.ff(x) ff_output = self.dropout_2(ff_output) x = x + ff_output x = self.norm_2(x) return x class Encoder(nn.Module): def init(self, vocab_size, d_model, N, heads, dropout): super().init()

self.embed = Embedder(vocab_size, d_model)

self.pe = PositionalEncoder(d_model, dropout=dropout)

self.layers = get_clones(EncoderLayer(d_model, heads, dropout), N)

self.norm = Norm(d_model)

def forward(self, src, mask):

x = self.embed(src)

x = self.pe(x)

for i in range(self.N):

x = self.layers[i](x, mask)

return self.norm(x)

使用 PyTorch 实现的解码器参考代码如下:

class DecoderLayer(nn.Module):

def __init__(self, d_model, heads, dropout=0.1):

super().__init__()

self.norm_1 = Norm(d_model)

self.norm_2 = Norm(d_model)

self.norm_3 = Norm(d_model)

self.dropout_1 = nn.Dropout(dropout)

self.dropout_2 = nn.Dropout(dropout)

self.dropout_3 = nn.Dropout(dropout)

self.attn_1 = MultiHeadAttention(heads, d_model, dropout=dropout)

self.attn_2 = MultiHeadAttention(heads, d_model, dropout=dropout)

self.ff = FeedForward(d_model, dropout=dropout)

def forward(self, x, e_outputs, src_mask, trg_mask):

attn_output_1 = self.attn_1(x, x, x, trg_mask)

attn_output_1 = self.dropout_1(attn_output_1)

x = x + attn_output_1

x = self.norm_1(x)

attn_output_2 = self.attn_2(x, e_outputs, e_outputs, src_mask)

attn_output_2 = self.dropout_2(attn_output_2)

x = x + attn_output_2

x = self.norm_2(x)

ff_output = self.ff(x)

ff_output = self.dropout_3(ff_output)

x = x + ff_output

x = self.norm_3(x)

return x

class Decoder(nn.Module):

def __init__(self, vocab_size, d_model, N, heads, dropout):

super().__init__()

self.N = N

self.embed = Embedder(vocab_size, d_model)

self.pe = PositionalEncoder(d_model, dropout=dropout)

self.layers = get_clones(DecoderLayer(d_model, heads, dropout), N)

self.norm = Norm(d_model)

def forward(self, trg, e_outputs, src_mask, trg_mask):

x = self.embed(trg)

x = self.pe(x)

for i in range(self.N):

x = self.layers[i](x, e_outputs, src_mask, trg_mask)

return self.norm(x)

基于 Transformer 的编码器和解码器结构整体实现参考代码如下:

class Transformer(nn.Module):

def __init__(self, src_vocab, trg_vocab, d_model, N, heads, dropout):

super().__init__()

self.encoder = Encoder(src_vocab, d_model, N, heads, dropout)

self.decoder = Decoder(trg_vocab, d_model, N, heads, dropout)

self.out = nn.Linear(d_model, trg_vocab)

def forward(self, src, trg, src_mask, trg_mask):

e_outputs = self.encoder(src, src_mask)

d_output = self.decoder(trg, e_outputs, src_mask, trg_mask)

output = self.out(d_output)

return output

可以使用如下代码对上述模型结构进行训练和测试:

# 模型参数定义

d_model = 512

heads = 8

N = 6

src_vocab = len(EN_TEXT.vocab)

trg_vocab = len(FR_TEXT.vocab)

model = Transformer(src_vocab, trg_vocab, d_model, N, heads)

for p in model.parameters():

if p.dim() > 1:

nn.init.xavier_uniform_(p)

optim = torch.optim.Adam(model.parameters(), lr=0.0001, betas=(0.9, 0.98), eps=1e-9)

# 模型训练

def train_model(epochs, print_every=100):

model.train()

start = time.time()

temp = start

total_loss = 0

for epoch in range(epochs):

for i, batch in enumerate(train_iter):

src = batch.English.transpose(0,1)

trg = batch.French.transpose(0,1)

# 将我们输入的法语句子中的所有单词翻译成中文,

# 除了最后一个单词,因为它正在使用每个单词来预测下一个单词。

trg_input = trg[:, :-1]

# 试图预测单词

targets = trg[:, 1:].contiguous().view(-1)

# 使用掩码代码创建函数来制作掩码

src_mask, trg_mask = create_masks(src, trg_input)

preds = model(src, trg_input, src_mask, trg_mask)

optim.zero_grad()

loss = F.cross_entropy(preds.view(-1, preds.size(-1)),

results, ignore_index=target_pad)

loss.backward()

optim.step()

total_loss += loss.data[0]

if (i + 1) % print_every == 0:

loss_avg = total_loss / print_every

print("time = %dm, epoch %d, iter = %d, loss = %.3f,

%ds per %d iters" % ((time.time() - start) // 60,

epoch + 1, i + 1, loss_avg, time.time() - temp,

print_every))

total_loss = 0

temp = time.time()

# 模型测试

def translate(model, src, max_len = 80, custom_string=False):

model.eval()

if custom_sentence == True:

src = tokenize_en(src)

sentence=Variable(torch.LongTensor([[EN_TEXT.vocab.stoi[tok] for tok

in sentence]])).cuda()

src_mask = (src != input_pad).unsqueeze(-2)

e_outputs = model.encoder(src, src_mask)

outputs = torch.zeros(max_len).type_as(src.data)

outputs[0] = torch.LongTensor([FR_TEXT.vocab.stoi['<sos>']])

for i in range(1, max_len):

trg_mask = np.triu(np.ones((1, i, i),

k=1).astype('uint8')

trg_mask= Variable(torch.from_numpy(trg_mask) == 0).cuda()

out = model.out(model.decoder(outputs[:i].unsqueeze(0),

e_outputs, src_mask, trg_mask))

out = F.softmax(out, dim=-1)

val, ix = out[:, -1].data.topk(1)

outputs[i] = ix[0][0]

if ix[0][0] == FR_TEXT.vocab.stoi['<eos>']:

break

return ' '.join(

[FR_TEXT.vocab.itos[ix] for ix in outputs[:i]]

)

2.2 生成式预训练语言模型 GPT

受到计算机视觉领域采用 ImageNet[13] 对模型进行一次预训练,使得模型可以通过海量图像 充分学习如何提取特征,然后再根据任务目标进行模型微调的范式影响,自然语言处理领域基于 预训练语言模型的方法也逐渐成为主流。以 ELMo[3] 为代表的动态词向量模型开启了语言模型预 训练的大门,此后以 GPT[4] 和 BERT[1] 为代表的基于 Transformer 的大规模预训练语言模型的出 现,使得自然语言处理全面进入了预训练微调范式新时代。利用丰富的训练语料、自监督的预训 练任务以及 Transformer 等深度神经网络结构,预训练语言模型具备了通用且强大的自然语言表示 能力,能够有效地学习到词汇、语法和语义信息。将预训练模型应用于下游任务时,不需要了解 太多的任务细节,不需要设计特定的神经网络结构,只需要”微调”预训练模型,即使用具体任 务的标注数据在预训练语言模型上进行监督训练,就可以取得显著的性能提升。

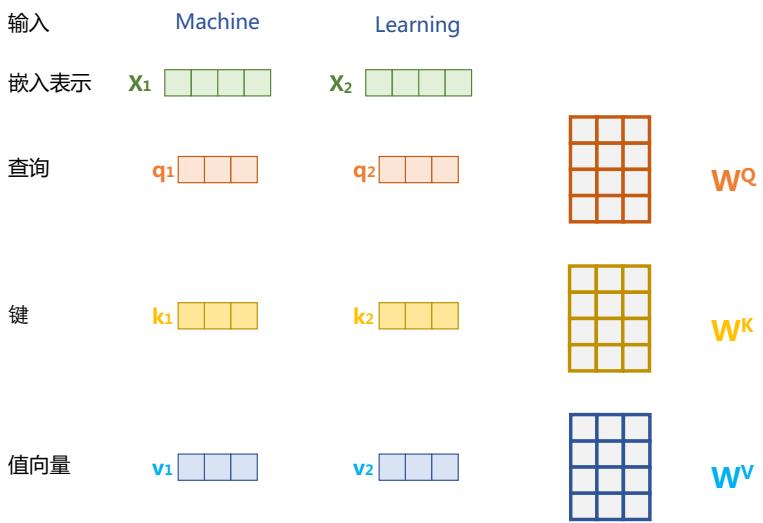

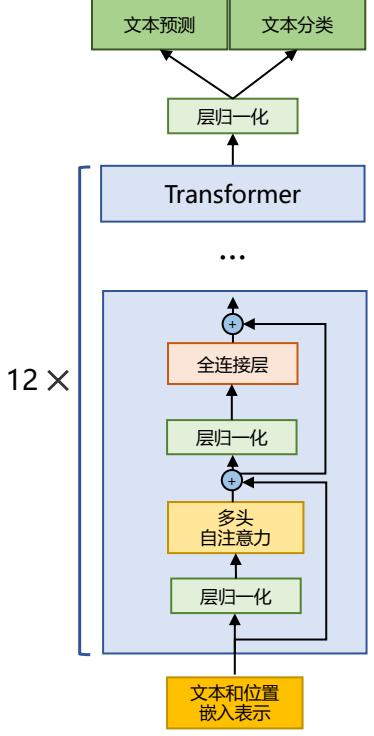

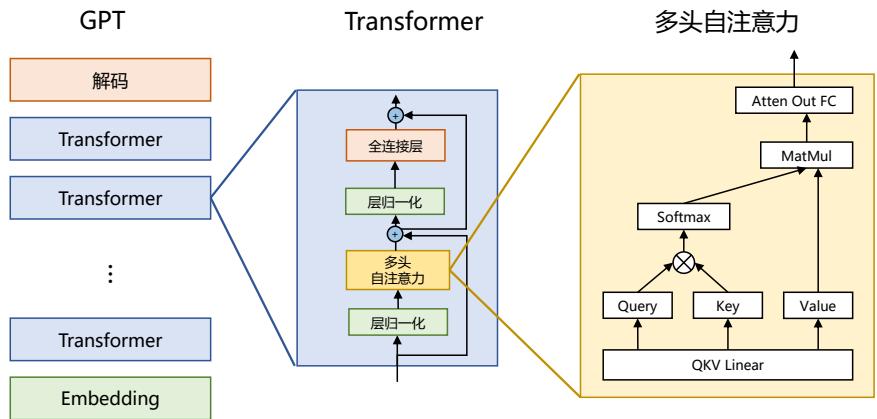

OpenAI 公司在 2018 年提出的生成式预训练语言模型(Generative Pre-Training,GPT)[4] 是典 型的生成式预训练语言模型之一。GPT 模型结构如图2.3所示,由多层 Transformer 组成的单向语 言模型,主要分为输入层,编码层和输出层三部分。

本节将重点介绍 GPT 无监督预训练、有监督下游任务微调以及基于 HuggingFace 的预训练语 言模型实践。

2.2.1 无监督预训练

GPT 采用生成式预训练方法,单向意味着模型只能从左到右或从右到左对文本序列建模,所 采用的 Transformer 结构和解码策略保证了输入文本每个位置只能依赖过去时刻的信息。

图 2.3 GPT 预训练语言模型结构

给定文本序列 w = w1w2, …, wn,GPT 首先在输入层中将其映射为稠密的向量:

$\mathbf{v}{i}=\mathbf{v}{i}^{t}+\mathbf{v}_{i}^{p}$

其中,v t i 是词 wi 的词向量,v p i 是词 wi 的位置向量,vi 为第 i 个位置的单词经过模型输入层(第 0 层)后的输出。GPT 模型的输入层与前文中介绍的神经网络语言模型的不同之处在于其需要添加 位置向量,这是 Transformer 结构自身无法感知位置导致的,因此需要来自输入层的额外位置信息。

经过输入层编码,模型得到表示向量序列 v = v1, …, vn,随后将 v 送入模型编码层。编码层 由 L 个 Transformer 模块组成,在自注意力机制的作用下,每一层的每个表示向量都会包含之前位 置表示向量的信息,使每个表示向量都具备丰富的上下文信息,并且经过多层编码后,GPT 能得 到每个单词层次化的组合式表示,其计算过程表示如下:

$\mathbf{h}^{(L)}=$ Transformer-Block${}^{(L)}(\mathbf{h}^{(0)})$ (2.8)

其中 h (L) ∈ R d×n 表示第 L 层的表示向量序列,n 为序列长度,d 为模型隐藏层维度,L 为模型总 层数。

GPT 模型的输出层基于最后一层的表示 h (L),预测每个位置上的条件概率,其计算过程可以 表示为:

P(wi w1, …, wi−1) = Softmax(Weh (L) i + b out) (2.9)

| 其中,We ∈ R | V | ×d 为词向量矩阵, | V | 为词表大小。 |

单向语言模型是按照阅读顺序输入文本序列 w,用常规语言模型目标优化 w 的最大似然估计,

使之能根据输入历史序列对当前词能做出准确的预测:

\[{\cal L}^{\rm PT}(w)=-\sum_{i=1}^{n}\log P(w_{i}|w_{0}...w_{i-1};\mathbf{\theta})\tag{2.10}\]其中 θ 代表模型参数。也可以基于马尔可夫假设,只使用部分过去词进行训练。预训练时通常使 用随机梯度下降法进行反向传播优化该负对数似然函数。

2.2.2 有监督下游任务微调

通过无监督语言模型预训练,使得 GPT 模型具备了一定的通用语义表示能力。下游任务微调 (Downstream Task Fine-tuning)的目的是在通用语义表示基础上,根据下游任务的特性进行适配。 下游任务通常需要利用有标注数据集进行训练,数据集合使用 D 进行表示,每个样例由输入长度 为 n 的文本序列 x = x1x2…xn 和对应的标签 y 构成。

首先将文本序列 x 输入 GPT 模型,获得最后一层的最后一个词所对应的隐藏层输出 h (L) n ,在 此基础上通过全连接层变换结合 Softmax 函数,得到标签预测结果。

\[P(y|x_{1}...x_{n})=\mbox{Softmax}(\mathbf{h}_{n}^{(L)}\mathbf{W}^{y})\tag{2.11}\]其中 Wy ∈ R d×k 为全连接层参数,k 为标签个数。通过对整个标注数据集 D 优化如下目标函数 精调下游任务:

\[{\cal L}^{\rm FT}({\mathbb{D}})=-\sum_{(x,y)}\log P(y|x_{1}...x_{n})\tag{2.12}\]下游任务在微调过程中,针对任务目标进行优化,很容易使得模型遗忘预训练阶段所学习到 的通用语义知识表示,从而损失模型的通用性和泛化能力,造成灾难性遗忘(Catastrophic Forgetting) 问题。因此,通常会采用混合预训练任务损失和下游微调损失的方法来缓解上述问题。在实际应 用中,通常采用如下公式进行下游任务微调:

\[{\cal L}={\cal L}^{\rm FT}({\mathbb{D}})+\lambda{\cal L}^{\rm PT}({\mathbb{D}})\tag{2.13}\]其中 λ 取值为 [0,1],用于调节预训练任务损失占比。

2.2.3 基于 HuggingFace 的预训练语言模型实践

HuggingFace 是一个开源自然语言处理软件库。其的目标是通过提供一套全面的工具、库和模 型,使得自然语言处理技术对开发人员和研究人员更加易于使用。HuggingFace 最著名的贡献之一 是 Transformer 库,基于此研究人员可以快速部署训练好的模型以及实现新的网络结构。除此之外, HuggingFace 还提供了 Dataset 库,可以非常方便地下载自然语言处理研究中最常使用的基准数据 集。本节中,将以构建 BERT 模型为例,介绍基于 Huggingface 的 BERT 模型构建和使用方法。

1. 数据集合准备

常见的用于预训练语言模型的大规模数据集都可以在 Dataset 库中直接下载并加载。例如,如 果使用维基百科的英文语料集合,可以直接通过如下代码完成数据获取:

from datasets import concatenate_datasets, load_dataset

bookcorpus = load_dataset("bookcorpus", split="train")

wiki = load_dataset("wikipedia", "20230601.en", split="train")

# 仅保留 'text' 列

wiki = wiki.remove_columns([col for col in wiki.column_names if col != "text"])

dataset = concatenate_datasets([bookcorpus, wiki])

# 将数据集合切分为 90% 用于训练,10% 用于测试

d = dataset.train_test_split(test_size=0.1)

接下来将训练和测试数据分别保存在本地文件中,代码如下所示:

def dataset_to_text(dataset, output_filename="data.txt"):

""" 将数据集文本保存到磁盘的通用函数"""

with open(output_filename, "w") as f:

for t in dataset["text"]:

print(t, file=f)

# 将训练集保存为 train.txt

dataset_to_text(d["train"], "train.txt")

# 将测试集保存为 test.txt

dataset_to_text(d["test"], "test.txt")

- 训练词元分析器(Tokenizer)

BERT 采用了 WordPiece 分词,根据训练语料中的词频决定是否将一个完整的词切分为多个 词元。因此,需要首先训练词元分析器(Tokenizer)。可以使用 transformers 库中的 BertWordPiece-Tokenizer 类来完成任务,代码如下所示:

special_tokens = [

"[PAD]", "[UNK]", "[CLS]", "[SEP]", "[MASK]", "<S>", "<T>"

]

# 如果要根据训练和测试两个集合训练词元分析器,需要修改 files

# files = ["train.txt", "test.txt"]

# 仅根据训练集合训练词元分析器

files = ["train.txt"]

# BERT 中采用的默认词表大小 30522,可以随意修改

vocab_size = 30_522

# 最大序列长度,长度越低训练速度越快

max_length = 512

# 是否将长样本截断

truncate_longer_samples = False

初始化 WordPiece 词元分析器 tokenizer = BertWordPieceTokenizer() # 训练词元分析器 tokenizer.train(files=files, vocab_size=vocab_size, special_tokens=special_tokens) # 允许截断达到最大 512 词元 tokenizer.enable_truncation(max_length=max_length)

model_path = “pretrained-bert”

如果文件夹不存在,则首先创建文件夹 if not os.path.isdir(model_path): os.mkdir(model_path) # 保存词元分析器模型 tokenizer.save_model(model_path) # 将一些词元分析器中的配置保存到配置文件,包括特殊词元,转换为小写,最大序列长度等。 with open(os.path.join(model_path, “config.json”), “w”) as f: tokenizer_cfg = { “do_lower_case”: True, “unk_token”: “[UNK]”, “sep_token”: “[SEP]”, “pad_token”: “[PAD]”, “cls_token”: “[CLS]”, “mask_token”: “[MASK]”, “model_max_length”: max_length, “max_len”: max_length, }

json.dump(tokenizer_cfg, f)

当词元分析器进行训练和配置时,将其装载到 BertTokenizerFast tokenizer = BertTokenizerFast.from_pretrained(model_path)

3. 预处理语料集合

在启动整个模型训练之前,还需要将预训练语料根据训练好的 Tokenizer 进行处理。如果文档 长度超过 512 个词元(Token),那么就直接进行截断。数据处理代码如下所示:

def encode_with_truncation(examples): ””” 使用词元分析对句子进行处理并截断的映射函数(Mapping function)””” return tokenizer(examples[“text”], truncation=True, padding=”max_length”, max_length=max_length, return_special_tokens_mask=True)

def encode_without_truncation(examples): ””” 使用词元分析对句子进行处理但是不截断的映射函数(Mapping function)””” return tokenizer(examples[“text”], return_special_tokens_mask=True)

编码函数将依赖于 truncate_longer_samples 变量 encode = encode_with_truncation if truncate_longer_samples else encode_without_truncation # 对训练数据集进行分词处理

train_dataset = d["train"].map(encode, batched=True)

# 对测试数据集进行分词处理

test_dataset = d["test"].map(encode, batched=True)

if truncate_longer_samples:

# 移除其他列,并将 input_ids 和 attention_mask 设置为 PyTorch 张量

train_dataset.set_format(type="torch", columns=["input_ids", "attention_mask"])

test_dataset.set_format(type="torch", columns=["input_ids", "attention_mask"])

else:

# 移除其他列,将它们保留为 Python 列表

test_dataset.set_format(columns=["input_ids", "attention_mask", "special_tokens_mask"])

train_dataset.set_format(columns=["input_ids", "attention_mask", "special_tokens_mask"])

truncate_longer_samples 布尔变量来控制用于对数据集进行词元处理的 encode() 回调函数。如 果设置为 True,则会截断超过最大序列长度(max_length)的句子。否则,不会截断。如果设为 truncate_longer_samples 为 False,需要将没有截断的样本连接起来,并组合成固定长度的向量。

from itertools import chain

# 主要数据处理函数,拼接数据集中的所有文本并生成最大序列长度的块

def group_texts(examples):

# 拼接所有文本

concatenated_examples = {k: list(chain(*examples[k])) for k in examples.keys()}

total_length = len(concatenated_examples[list(examples.keys())[0]])

# 舍弃了剩余部分,如果模型支持填充而不是舍弃,你可以根据需要自定义这部分

if total_length >= max_length:

total_length = (total_length // max_length) * max_length

# 按照最大长度分割成块

result = {

k: [t[i : i + max_length] for i in range(0, total_length, max_length)]

for k, t in concatenated_examples.items()

}

return result

# 请注意,使用 batched=True,此映射一次处理 1,000 个文本

# 因此 group_texts 会为这 1,000 个文本组抛弃不足的部分。

# 可以在这里调整 batch_size,但较高的值可能会使预处理速度较慢

#

# 为了加速这一部分,我们使用了多进程处理。

# 请查看 map 方法的文档以获取更多信息

# https://huggingface.co/docs/datasets/package_reference/main_classes.html#datasets.Dataset.map

if not truncate_longer_samples:

train_dataset = train_dataset.map(group_texts, batched=True,

desc=f"Grouping texts in chunks of {max_length}")

test_dataset = test_dataset.map(group_texts, batched=True,

desc=f"Grouping texts in chunks of {max_length}")

# 将它们从列表转换为 PyTorch 张量

train_dataset.set_format("torch")

test_dataset.set_format("torch")

4. 模型训练

在构建了处理好的预训练语料之后,就可以开始模型训练。代码如下所示:

使用配置文件初始化模型 model_config = BertConfig(vocab_size=vocab_size, max_position_embeddings=max_length) model = BertForMaskedLM(config=model_config) # 初始化数据整理器,随机屏蔽 20%(默认为 15%)的标记, # 用于遮盖语言建模(MLM)任务。 data_collator = DataCollatorForLanguageModeling( tokenizer=tokenizer, mlm=True, mlm_probability=0.2 ) training_args = TrainingArguments( output_dir=model_path, # 输出目录,用于保存模型检查点 evaluation_strategy=”steps”, # 每隔 logging_steps 步进行评估。 overwrite_output_dir=True, num_train_epochs=10, # 训练时的轮数,可以根据需要进行调整 per_device_train_batch_size=10, # 训练批量大小,请根据您的 GPU 内存容量将其设置得尽可能大 gradient_accumulation_steps=8, # 在更新权重之前累积梯度 per_device_eval_batch_size=64, # 评估批量大小 logging_steps=1000, # 每隔 1000 步进行评估,记录并保存模型检查点 save_steps=1000, # load_best_model_at_end=True, # 是否在训练结束时加载最佳模型(根据损失) # save_total_limit=3, # 如果磁盘空间有限,您可以限制只保存 3 个模型权重 ) trainer = Trainer( model=model, args=training_args, data_collator=data_collator, train_dataset=train_dataset, eval_dataset=test_dataset, ) # 训练模型

trainer.train()

训练开始后,可以得到如下输出结果:

| [10135/79670 18:53:08 < 129:35:53, 0.15 it/s, Epoch 1.27/10] | ||

|---|---|---|

| Step | Training Loss | Validation Loss |

| 1000 | 6.904000 | 6.558231 |

| 2000 | 6.498800 | 6.401168 |

| 3000 | 6.362600 | 6.277831 |

| 4000 | 6.251000 | 6.172856 |

| 5000 | 6.155800 | 6.071129 |

| 6000 | 6.052800 | 5.942584 |

| 7000 | 5.834900 | 5.546123 |

8000 5.537200 5.248503 9000 5.272700 4.934949 10000 4.915900 4.549236

5. 模型使用

基于训练好的模型,可以针对不同应用需求进行使用,以句子补全为例的代码如下所示:

加载模型检查点 model = BertForMaskedLM.from_pretrained(os.path.join(model_path, “checkpoint-10000”)) # 加载分词器 tokenizer = BertTokenizerFast.from_pretrained(model_path) fill_mask = pipeline(“fill-mask”, model=model, tokenizer=tokenizer) # 进行预测 examples = [ “Today’s most trending hashtags on [MASK] is Donald Trump”, “The [MASK] was cloudy yesterday, but today it’s rainy.”, ] for example in examples: for prediction in fill_mask(example): print(f”{prediction[‘sequence’]}, confidence: {prediction[‘score’]}”) print(“=”*50)

通过上述代码可以得到如下输出:

today’s most trending hashtags on twitter is donald trump, confidence: 0.1027069091796875 today’s most trending hashtags on monday is donald trump, confidence: 0.09271949529647827 today’s most trending hashtags on tuesday is donald trump, confidence: 0.08099588006734848 today’s most trending hashtags on facebook is donald trump, confidence: 0.04266013577580452 today’s most trending hashtags on wednesday is donald trump, confidence: 0.04120611026883125 ==================================================

the weather was cloudy yesterday, but today it’s rainy., confidence: 0.04445931687951088 the day was cloudy yesterday, but today it’s rainy., confidence: 0.037249673157930374 the morning was cloudy yesterday, but today it’s rainy., confidence: 0.023775646463036537 the weekend was cloudy yesterday, but today it’s rainy., confidence: 0.022554103285074234 the storm was cloudy yesterday, but today it’s rainy., confidence: 0.019406016916036606 ==================================================

2.3 大语言模型结构

当前绝大多数大语言模型结构都采用了类似 GPT 架构,使用基于 Transformer 架构构造的仅 由解码器组成的网络结构,采用自回归的方式构建语言模型。但是在位置编码、层归一化位置以 及激活函数等细节上各有不同。文献 [5] 介绍了 GPT-3 模型的训练过程,包括模型架构、训练数

据组成、训练过程以及评估方法。由于 GPT-3 并没有开放源代码,根据论文直接重现整个训练过 程并不容易,因此文献 [31] 介绍了根据 GPT-3 的描述复现的过程,并构造开源了系统 OPT(Open Pre-trained Transformer Language Models)。Meta AI 也仿照 GPT-3 架构开源了 LLaMA 模型[37],公 开评测结果以及利用该模型进行有监督微调后的模型都有非常好的表现。由于自 GPT-3 模型之后, OpenAI 就不再开源也没有开源模型,因此并不清楚 ChatGPT 和 GPT-4 所采用的模型架构。

本节将以 LLaMA 模型为例,介绍大语言模型架构在 Transformer 原始结构上的改进,并介绍 Transformer 结构中空间和时间占比最大的注意力机制优化方法。

2.3.1 LLaMA 的模型结构

文献 [37] 介绍了 LLaMA 所采用的 Transformer 结构和细节,与在本章 2.2 节所介绍的 Transformer 架构不同的地方包括采用了前置层归一化(Pre-normalization)并使用 RMSNorm 归一化函 数(Root Mean Square Normalizing Function)、激活函数更换为 SwiGLU,并使用了旋转位置嵌入 (RoPE),整体 Transformer 架构与 GPT-2 类似,如图2.4所示。

图 2.4 GPT-2 模型结构

接下来,将分别介绍 RMSNorm 归一化函数、SwiGLU 激活函数和旋转位置嵌入(RoPE)的 具体内容和实现。

1. RMSNorm 归一化函数

为了使得模型训练过程更加稳定,GPT-2 相较于 GPT 就引入了前置层归一化方法,将第一个 层归一化移动到多头自注意力层之前,第二个层归一化也移动到了全连接层之前,同时残差连接的 位置也调整到了多头自注意力层与全连接层之后。层归一化中也采用了 RMSNorm 归一化函数[49]。 针对输入向量 a,RMSNorm 函数计算公式如下:

\({\rm RMS}(\mathbf{a})=\sqrt{\frac{1}{n}\Sigma_{i=1}^{n}\mathbf{a}_{i}^{2}}\tag{2.14}\) \(\overline{\mathbf{a}}_{i}=a_{i}\tag{2.15}\)

\[\overline{a}_{i}=\frac{\overline{a}_{i}}{\text{RMS}(a)}\tag{2.15}\]此外,RMSNorm 还可以引入可学习的缩放因子 gi 和偏移参数 bi,从而得到 ai = ai RMS(a) gi + bi。 RMSNorm 在 HuggingFace Transformer 库中代码实现如下所示:

class LlamaRMSNorm(nn.Module):

def __init__(self, hidden_size, eps=1e-6):

"""

LlamaRMSNorm 等同于 to T5LayerNorm

"""

super().__init__()

self.weight = nn.Parameter(torch.ones(hidden_size))

self.variance_epsilon = eps # eps 防止取倒数之后分母为 0

def forward(self, hidden_states):

input_dtype = hidden_states.dtype

variance = hidden_states.to(torch.float32).pow(2).mean(-1, keepdim=True)

hidden_states = hidden_states * torch.rsqrt(variance + self.variance_epsilon)

# weight 是末尾乘的可训练参数, 即 g_i

return (self.weight * hidden_states).to(input_dtype)

2. SwiGLU 激活函数

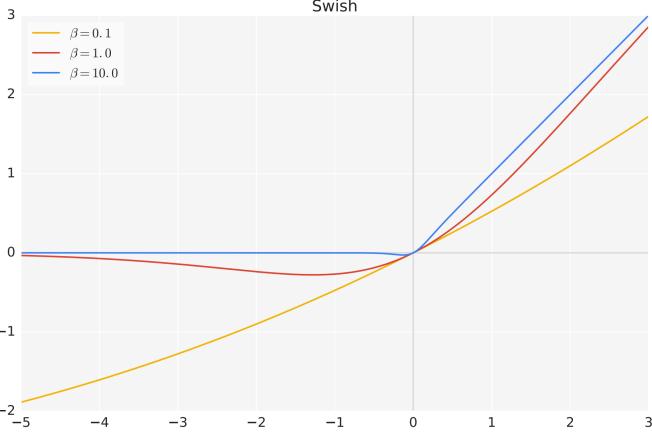

SwiGLU[50] 激活函数是 Shazeer 在文献 [50] 中提出,并在 PaLM[14] 等模型中进行了广泛应用, 并且取得了不错的效果,相较于 ReLU 函数在大部分评测中都有不少提升。在 LLaMA 中全连接 层使用带有 SwiGLU 激活函数的 FFN(Position-wise Feed-Forward Network)的计算公式如下:

\[{\rm FFN}_{\rm SwiGLU}(\mathbf{x},\mathbf{W},\mathbf{V},\mathbf{W}_{2})={\rm SwiGLU}(\mathbf{x},\mathbf{W},\mathbf{V})\mathbf{W}_{2}\tag{2.16}\] \[\mbox{SwiGLU}(\mathbf{x},\mathbf{W},\mathbf{V})=\mbox{Swish}_{\beta}(\mathbf{x}\mathbf{W})\otimes\mathbf{x}\mathbf{V}\tag{2.17}\] \[{\rm Swish}_{\beta}(\mathbf{x})=\mathbf{x}\sigma(\mathbf{\beta}\mathbf{x})\tag{2.18}\]其中,σ(x) 是 Sigmoid 函数。图2.5给出了 Swish 激活函数在参数 β 不同取值下的形状。可以看到 当 β 趋近于 0 时,Swish 函数趋近于线性函数 y = x,当 β 趋近于无穷大时,Swish 函数趋近于 ReLU 函数,β 取值为 1 时,Swish 函数是光滑且非单调。在 HuggingFace 的 Transformer 库中 Swish 函数使用 silu 函数[51] 代替。

图 2.5 Swish 激活函数在参数 β 不同取值下的形状

3. 旋转位置嵌入(RoPE)

在位置编码上,使用旋转位置嵌入(Rotary Positional Embeddings,RoPE)[52] 代替原有的绝 对位置编码。RoPE 借助了复数的思想,出发点是通过绝对位置编码的方式实现相对位置编码。其 目标是通过下述运算来给 q,k 添加绝对位置信息:

$\tilde{\mathbf{q}}{m}=f(\mathbf{q},m),\tilde{\mathbf{k}}{n}=f(\mathbf{k},n)$ (2.19)

经过上述操作后,q˜m 和 k˜ n 就带有位置 m 和 n 的绝对位置信息。

详细的证明和求解过程可以参考文献 [52],最终可以得到二维情况下用复数表示的 RoPE:

\[f(\mathbf{q},m)=R_{f}(\mathbf{q},m)e^{i\Theta_{f}(\mathbf{q},m)}=||\mathbf{q}||e^{i(\Theta(\mathbf{q})+m\theta)}=\mathbf{q}e^{im\theta}\tag{2.20}\]根据复数乘法的几何意义,上述变换实际上是对应向量旋转,所以位置向量称为”旋转式位置编 码”。还可以使用矩阵形式表示:

\[f(\mathbf{q},m)=\begin{pmatrix}\cos m\theta&-\sin m\theta\\ \sin m\theta&\cos m\theta\end{pmatrix}\begin{pmatrix}\mathbf{q}_{0}\\ \mathbf{q}_{1}\end{pmatrix}\tag{2.21}\]根据内积满足线性叠加的性质,任意偶数维的 RoPE,都可以表示为二维情形的拼接,即:

| | cos | mθ0 | sin − | mθ0 | 0 | 0 | · · · | 0 | 0 | | | q0 | | ||||||

|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|

| | sin | mθ0 | cos | mθ0 | 0 | 0 | · · · | 0 | 0 | | | q1 | | ||||||

| | 0 | 0 | cos | mθ1 | − sin | mθ1 | · · · | 0 | 0 | | | q2 | | ||||||

| f(q, m) = | | 0 | 0 | sin | mθ1 | cos | mθ1 | · · · | 0 | 0 | | | q3 | | |||||

| | · · · | · · · | · · · | · · · | . . . | · · · | · · · | | | · · · | | ||||||||

| | 0 | 0 | 0 | 0 | · · · | cos | mθd/2−1 | − | sin mθd/2−1 | | | qd−2 | | ||||||

| 0 | 0 | 0 | 0 | · · · | sin | mθd/2−1 | cosmθd/2−1 | qd−1 | |||||||||||

| {z Rd | } |

(2.22)

由于上述矩阵 Rn 具有稀疏性,因此可以使用逐位相乘 ⊗ 操作进一步加快计算速度。RoPE 在 HuggingFace Transformer 库中代码实现如下所示:

class LlamaRotaryEmbedding(torch.nn.Module): def init(self, dim, max_position_embeddings=2048, base=10000, device=None): super().init() inv_freq = 1.0 / (base ** (torch.arange(0, dim, 2).float().to(device) / dim)) self.register_buffer(“inv_freq”, inv_freq) # 在这里构建,以便使 torch.jit.trace 正常工作 self.max_seq_len_cached = max_position_embeddings t = torch.arange(self.max_seq_len_cached, device=self.inv_freq.device, dtype=self.inv_freq.dtype) freqs = torch.einsum(“i,j->ij”, t, self.inv_freq) # 与论文不同,使用了不同的排列, # 以便获得相同的计算结果 emb = torch.cat((freqs, freqs), dim=-1) dtype = torch.get_default_dtype() self.register_buffer(“cos_cached”, emb.cos()[None, None, :, :].to(dtype), persistent=False) self.register_buffer(“sin_cached”, emb.sin()[None, None, :, :].to(dtype), persistent=False) def forward(self, x, seq_len=None): # x: [bs, num_attention_heads, seq_len, head_size] # 在我们在 __init__ 中构建了 sin/cos 之后,这个 if 块不太可能被执行 # 为了万一,保留这里的逻辑 if seq_len > self.max_seq_len_cached: self.max_seq_len_cached = seq_len t = torch.arange(self.max_seq_len_cached, device=x.device, dtype=self.inv_freq.dtype) freqs = torch.einsum(“i,j->ij”, t, self.inv_freq) # 与论文不同,使用了不同的排列, # 以便获得相同的计算结果 emb = torch.cat((freqs, freqs), dim=-1).to(x.device) self.register_buffer(“cos_cached”, emb.cos()[None, None, :, :].to(x.dtype), persistent=False) self.register_buffer(“sin_cached”, emb.sin()[None, None, :, :].to(x.dtype), persistent=False)

return (

self.cos_cached[:, :, :seq_len, ...].to(dtype=x.dtype),

self.sin_cached[:, :, :seq_len, ...].to(dtype=x.dtype),

)

def rotate_half(x):

""" 将输入的一半隐藏维度进行旋转。"""

x1 = x[..., : x.shape[-1] // 2]

x2 = x[..., x.shape[-1] // 2 :]

return torch.cat((-x2, x1), dim=-1)

def apply_rotary_pos_emb(q, k, cos, sin, position_ids):

# cos 和 sin 的前两个维度始终为 1,因此我们可以对它们进行 `squeeze` 操作

cos = cos.squeeze(1).squeeze(0) # [seq_len, dim]

sin = sin.squeeze(1).squeeze(0) # [seq_len, dim]

cos = cos[position_ids].unsqueeze(1) # [bs, 1, seq_len, dim]

sin = sin[position_ids].unsqueeze(1) # [bs, 1, seq_len, dim]

q_embed = (q * cos) + (rotate_half(q) * sin)

k_embed = (k * cos) + (rotate_half(k) * sin)

return q_embed, k_embed

4. 模型整体框架

基于上述模型和网络结构可以实现解码器层,根据自回归方式利用训练语料进行模型的过程 与本章第 2.3.4 节介绍的过程基本一致。不同规模 LLaMA 模型所使用的具体超参数如表2.1所示。 但是由于大语言模型的参数量非常大,并且需要大量的数据进行训练,因此仅利用单个 GPU 很难 完成训练,需要依赖分布式模型训练框架(本书第 4 章将详细介绍相关内容)。

| 参数规模 | 层数 | 自注意力头数 | 嵌入表示维度 | 学习率 | 全局批次大小 | 训练 | Token | 数 |

|---|---|---|---|---|---|---|---|---|

| 6.7B | 32 | 32 | 4096 | 3.0e-4 | 万 400 | 1.0 | 万亿 | |

| 13.0B | 40 | 40 | 5120 | 3.0e-4 | 400 万 | 1.0 | 万亿 | |

| 32.5B | 60 | 52 | 6656 | 1.5e-4 | 400 万 | 1.4 | 万亿 | |

| 65.2B | 80 | 64 | 8192 | 1.5e-4 | 万 400 | 1.4 | 万亿 |

表 2.1 LLaMA 不同模型规模下的具体超参数细节[37]

HuggingFace Transformer 库中 LLaMA 解码器整体实现代码实现如下所示:

class LlamaDecoderLayer(nn.Module):

def __init__(self, config: LlamaConfig):

super().__init__()

self.hidden_size = config.hidden_size

self.self_attn = LlamaAttention(config=config)

self.mlp = LlamaMLP(

hidden_size=self.hidden_size,

intermediate_size=config.intermediate_size,

hidden_act=config.hidden_act,

)

self.input_layernorm = LlamaRMSNorm(config.hidden_size, eps=config.rms_norm_eps)

self.post_attention_layernorm = LlamaRMSNorm(config.hidden_size, eps=config.rms_norm_eps)

def forward(

self,

hidden_states: torch.Tensor,

attention_mask: Optional[torch.Tensor] = None,

position_ids: Optional[torch.LongTensor] = None,

past_key_value: Optional[Tuple[torch.Tensor]] = None,

output_attentions: Optional[bool] = False,

use_cache: Optional[bool] = False,

) -> Tuple[torch.FloatTensor, Optional[Tuple[torch.FloatTensor, torch.FloatTensor]]]:

residual = hidden_states

hidden_states = self.input_layernorm(hidden_states)

# 自注意力模块

hidden_states, self_attn_weights, present_key_value = self.self_attn(

hidden_states=hidden_states,

attention_mask=attention_mask,

position_ids=position_ids,

past_key_value=past_key_value,

output_attentions=output_attentions,

use_cache=use_cache,

)

hidden_states = residual + hidden_states

# 全连接层

residual = hidden_states

hidden_states = self.post_attention_layernorm(hidden_states)

hidden_states = self.mlp(hidden_states)

hidden_states = residual + hidden_states

outputs = (hidden_states,)

if output_attentions:

outputs += (self_attn_weights,)

if use_cache:

outputs += (present_key_value,)

return outputs

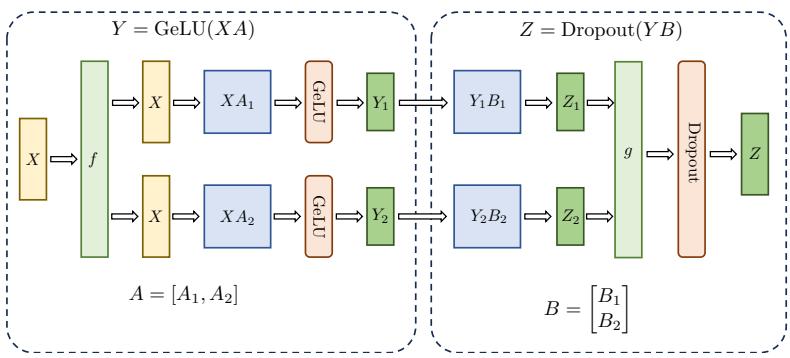

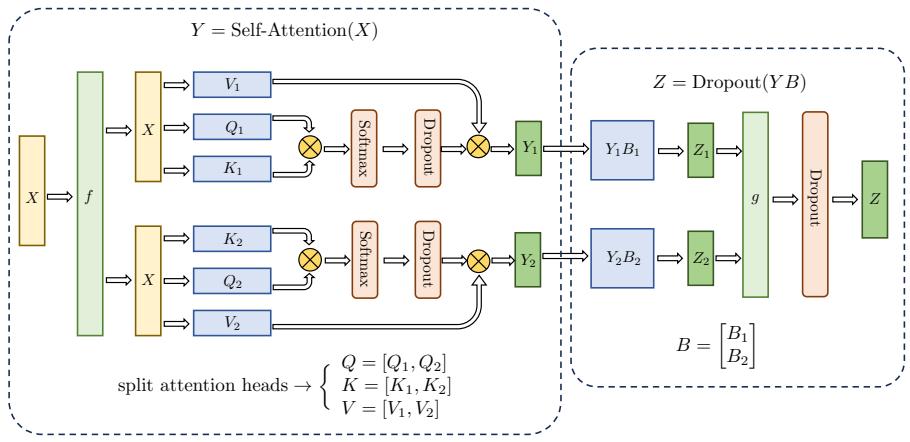

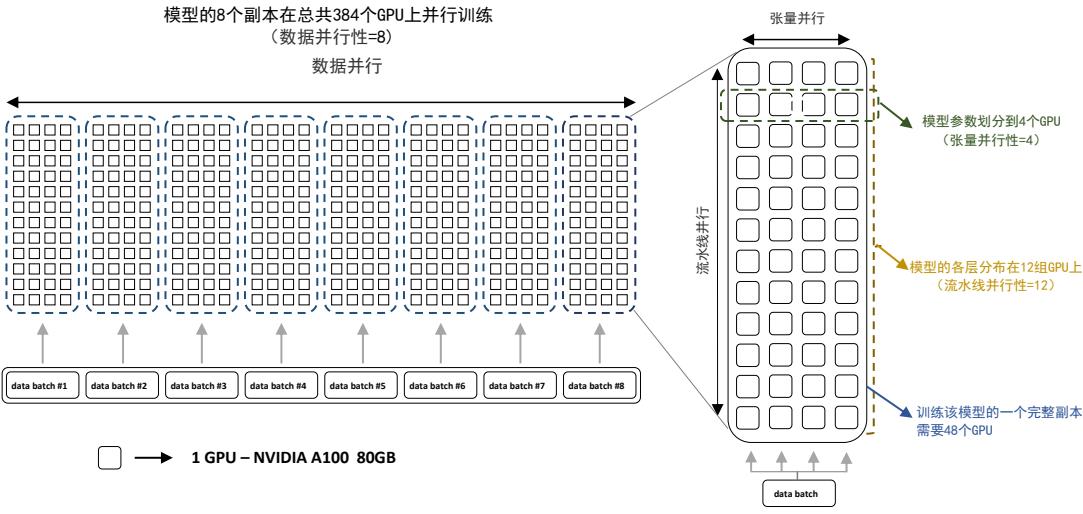

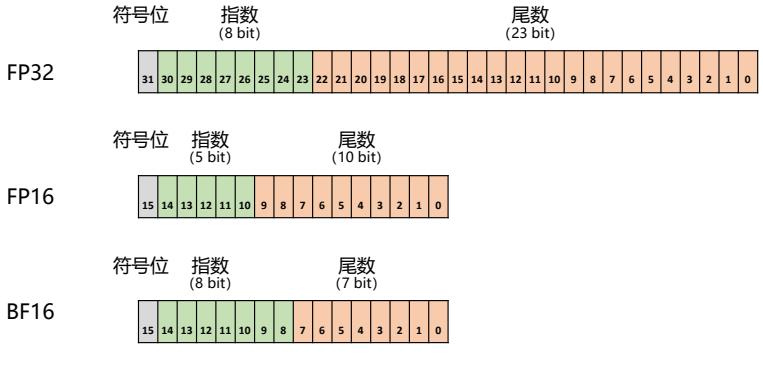

2.3.2 注意力机制优化

在 Transformer 结构中,自注意力机制的时间和存储复杂度与序列的长度呈平方的关系,因此 占用了大量的计算设备内存和并消耗大量计算资源。因此,如何优化自注意力机制的时空复杂度、 增强计算效率是大语言模型需要面临的重要问题。一些研究从近似注意力出发,旨在减少注意力

计算和内存需求,提出了包括稀疏近似、低秩近似等方法。此外,也有一些研究从计算加速设备本 身的特性出发,研究如何更好利用硬件特性对 Transformer 中注意力层进行高效计算。本节中,将 分别介绍上述两类方法。

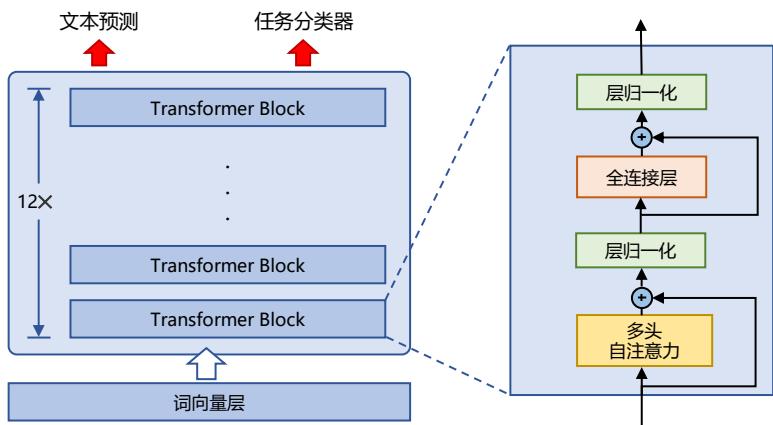

1. 稀疏注意力机制

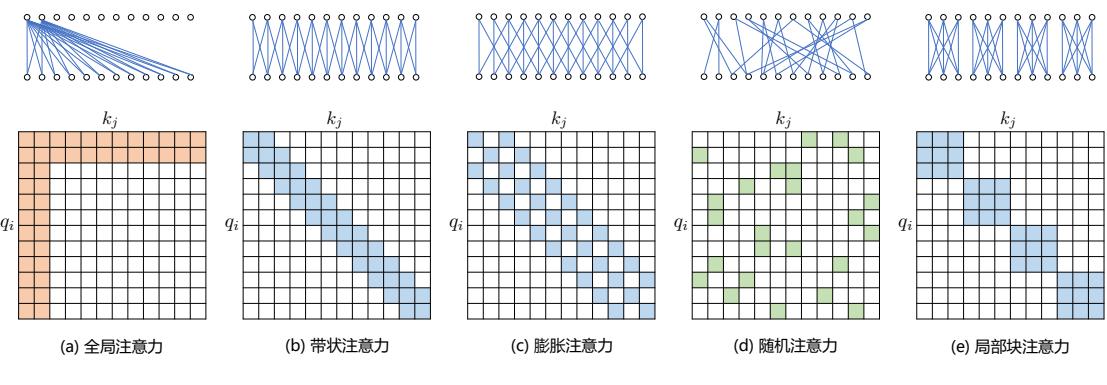

通过对一些训练好的 Transformer 结构中的注意力矩阵进行分析发现,其中很多通常是稀疏 的,因此可以通过限制 Query-Key 对的数量来减少计算复杂度。这类方法就称为稀疏注意力(Sparse Attention)机制。可以将稀疏化方法进一步分成两类:基于位置信息和基于内容。

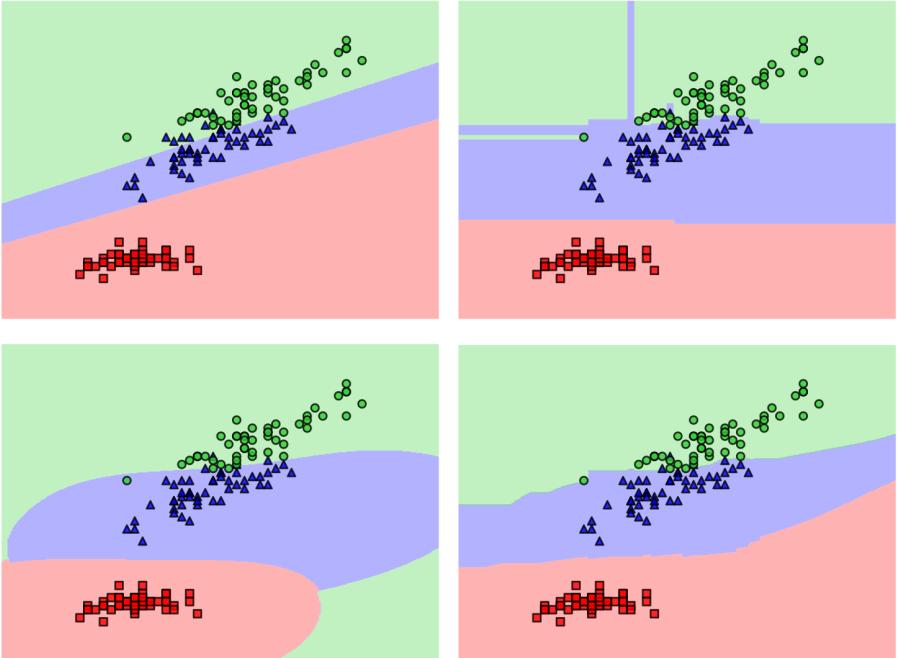

基于位置的稀疏注意力机制的基本类型如图2.6所示,主要包含如下五种类型:(1)全局注意 力(Global Attention):为了增强模型建模长距离依赖关系的能力,可以加入一些全局节点;(2) 带状注意力(Band Attention):大部分数据都带有局部性,限制 Query 只与相邻的几个节点进行交 互;(3)膨胀注意力(Dilated Attention);与 CNN 中的 Dilated Conv 类似,通过增加空隙以获取更 大的感受野;(4)随机注意力(Random Attention):通过随机采样,提升非局部的交互;(5)局 部块注意力(Block Local Attention):使用多个不重叠的块(Block)来限制信息交互。

图 2.6 五种基于位置的稀疏注意力基本类型[53]

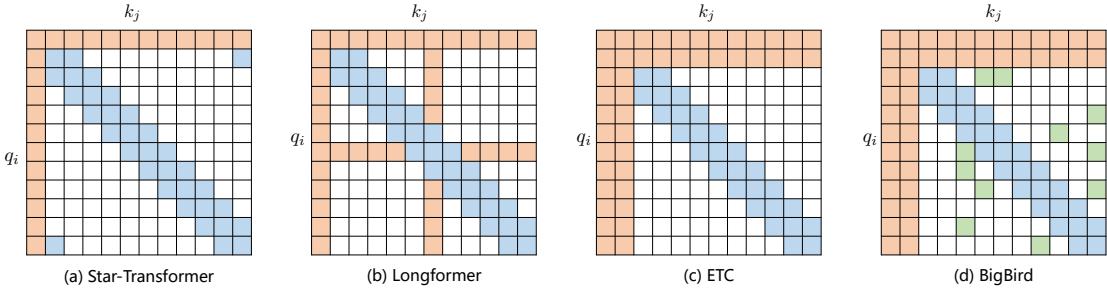

现有的稀疏注意力机制,通常是基于上述五种基于位置的稀疏注意力机制的复合模式,图2.7给 出了一些典型的稀疏注意力模型。Star-Transformer[54] 使用带状注意力和全局注意力的组合。具体 来说,Star-Transformer 只包括一个全局注意力节点和宽度为 3 的带状注意力,其中任意两个非相 邻节点通过一个共享的全局注意力连接,而相邻节点则直接相连。Longformer[55] 使用带状注意力 和内部全局节点注意力(Internal Global-node Attention)的组合。此外,Longformer 还将上层中的 一些带状注意力头部替换为具有膨胀窗口的注意力,在增加感受野同时并不增加计算量。Extended Transformer Construction(ETC)[56] 利用带状注意力和外部全局节点注意力(External Global-node Attention)的组合。ETC 稀疏注意力还包括一种掩码机制来处理结构化输入,并采用对比预测编 码(Contrastive Predictive Coding,CPC)[57] 进行预训练。BigBird[58] 使用带状和全局注意力,还 使用额外的随机注意力来近似全连接注意力,此外还揭示了稀疏编码器和稀疏解码器的使用可以 模拟任何图灵机,这也在一定程度上解释了,为什么稀疏注意力模型可以取得较好的结果原因。

图 2.7 基于位置复合稀疏注意力类型[53]

基于内容的稀疏注意力是是根据输入数据来创建稀疏注意力,其中一种很简单的方法是选择 和给定查询(Query)有很高相似度的键(Key)。Routing Transformer[59] 采用 K-means 聚类方法, 针对 Query{qi} T i=1 和 Key{ki} T i=1 一起进行聚类,类中心向量集合为 {µi} k i=1,其中 k 是类中心个 数。每个 Query 只与其处在相同簇(Cluster)下的 Key 进行交互。中心向量采用滑动平均的方法 进行更新:

\[\mu_{l}\leftarrow\lambda\mu_{l}+\frac{(1-\lambda)}{2}\left(\sum_{i:\mu(\mathbf{q}_{i})=\mu_{l}}\mathbf{q}_{i}+\sum_{j:\mu(\mathbf{k}_{j})=\mu_{l}}\mathbf{k}_{j}\right)\tag{2.23}\]| $c_{\mu_{l}}\leftarrow\lambda c_{\mu_{l}}+(1-\lambda) | \mu_{l} | $ (2.24) |

| 其中 | µl | 表示在簇 µl 中向量的数量。 |

Reformer[60] 则采用局部敏感哈希(Local-Sensitive Hashing,LSH)方法来为每个 Query 选择 Key-Value 对。其主要思想使用 LSH 函数将 Query 和 Key 进行哈希计算,将它们划分到多个桶内。 提升在同一个桶内的 Query 和 Key 参与交互的概率。假设 b 是桶的个数,给定一个大小为 [Dk, b/2] 随机矩阵 R,LSH 函数定义为:

$h(\mathbf{x})=\arg\max([\mathbf{x}R;-\mathbf{x}R])$ (2.26)

如果 hqi = hkj 时,qi 才可以与相应的 Key-Value 对进行交互。

2. FlashAttention

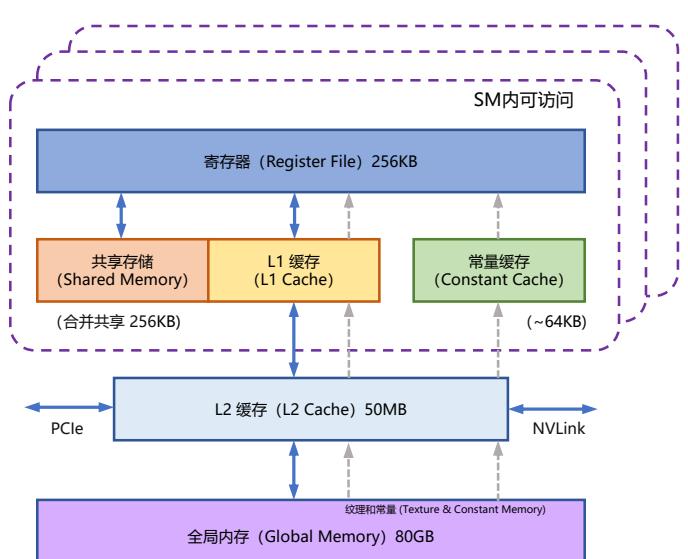

NVIDIA GPU 中的内存(显存)按照它们物理上是在 GPU 芯片内部还是板卡 RAM 存储芯片 上,决定了它们的速度、大小以及访问限制。GPU 显存分为全局内存(Global memory)、本地内存 (Local memory)、共享内存(Shared memory,SRAM)、寄存器内存(Register memory)、常量内存 (Constant memory)、纹理内存(Texture memory)等六大类。图2.8给出了 NVIDIA GPU 内存的整 体结构。其中全局内存、本地内存、共享内存和寄存器内存具有读写能力。全局内存和本地内存 使用的高带宽显存(High Bandwidth Memory,HBM)位于板卡 RAM 存储芯片上,该部分内存容 量很大。全局内存是所有线程都可以访问,而本地内存则只能当前线程访问。NVIDIA H100 中全 局内存有 80GB 空间,其访问速度虽然可以达到 3.35TB/s,但是如果全部线程同时访问全局内存 时,其平均带宽仍然很低。共享内存和寄存器位于 GPU 芯片上,因此容量很小,并且共享内存只 有在同一个 GPU 线程块(Thread Block)内的线程才可以共享访问,而寄存器仅限于同一个线程 内部才能访问。NVIDIA H100 中每个 GPU 线程块在流式多处理器(Stream Multi-processor,SM) 可以使用的共享存储容量仅有 228KB,但是其速度非常快,远高于全局内存的访问速度。

图 2.8 NVIDIA GPU 的整体内存结构图

在本章第 2.2 节中介绍了自注意力机制的原理,在 GPU 中进行计算时,传统的方法还需要引 入两个中间矩阵 S 和 P 并存储到全局内存中。具体计算过程如下:

$\mathbf{S}=\mathbf{Q}\times\mathbf{K},\ \ \mathbf{P}=\mbox{Softmax}(\mathbf{S}),\ \ \mathbf{Q}=\mathbf{P}\times\mathbf{V}$ (2.27)

按照上述计算过程,需要首先从全局内存中读取矩阵 Q 和 K,并将计算好的矩阵 S 再写入全局 内存,之后再从全局内存中获取矩阵 S,计算 Softmax 得到矩阵 P,再写入全局内存,之后读取 矩阵 P 和矩阵 V ,计算得到矩阵 O。这样的过程会极大占用显存的带宽。在自注意力机制中,计 算速度比内存速度快得多,因此计算效率越来越多地受到全局内存访问的瓶颈。

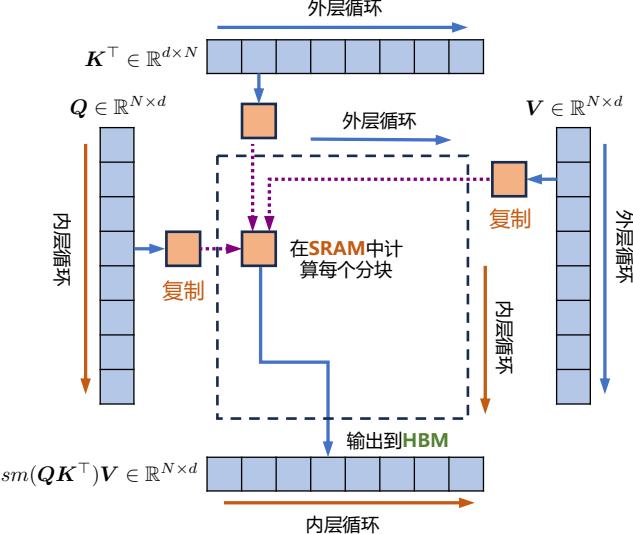

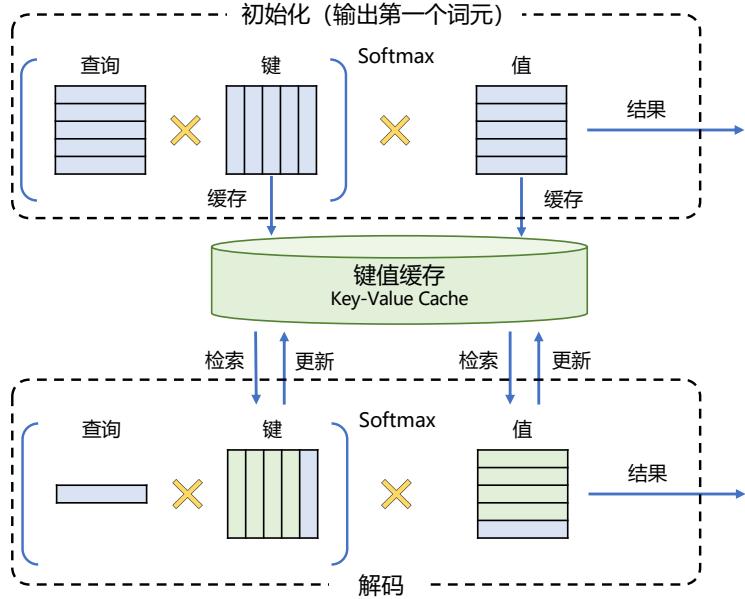

FlashAttention[61] 就是通过利用 GPU 硬件中的特殊设计,针对全局内存和共享存储的 I/O 速 度的不同,尽可能地避免 HBM 中读取或写入注意力矩阵。FlashAttention 目标是尽可能高效地使 用 SRAM 来加快计算速度,避免从全局内存中读取和写入注意力矩阵。达成该目标需要能做到 在不访问整个输入的情况下计算 Softmax 函数,并且后向传播中不能存储中间注意力矩阵。标准 Attention 算法中,Softmax 计算按行进行,即在与 V 做矩阵乘法之前,需要将 Q、K 的各个分块 完成一整行的计算。在得到 Softmax 的结果后,再与矩阵 V 分块做矩阵乘。而在 FlashAttention 中, 将输入分割成块,并在输入块上进行多次传递,从而以增量方式执行 Softmax 计算。

自注意力算法的标准实现将计算过程中的矩阵 S、P 写入全局内存中,而这些中间矩阵的大 小与输入的序列长度有关且为二次型。因此,FlashAttention 就提出了不使用中间注意力矩阵,通 过存储归一化因子来减少全局内存的消耗。FlashAttention 算法并没有将 S、P 整体写入全局内 存,而是通过分块写入,存储前向传递的 Softmax 归一化因子,在后向传播中快速重新计算片上 注意力,这比从全局内存中读取中间注意力矩阵的标准方法更快。由于大幅度减少了全局内存的 访问量,即使重新计算导致 FLOPs 增加,但其运行速度更快并且使用更少的内存。具体算法如代 码2.1所示,其中内循环和外循环所对应的计算可以参考图2.9。

图 2.9 FlashAttention 计算流程图[61]

代码 2.1: FlashAttention 算法

输入: Q, K, V ∈ R N×d 位于高速显存(HBM)中,GPU 芯片中的 SRAM 大小为 M 输出: O Bc = ⌈ M 4d ⌉,Br = min(⌈ M 4d ⌉, d) // 设置块大小(block size) 在 HBM 中初始化 O = (0)N×d ∈ R N×d,l = (0)N ∈ R N,m = (−∞)N ∈ R N 将矩阵 Q 切分成 Tr = ⌈ M Br ⌉ 块 Q1, . . . , QTr,Qi ∈ R Br×d 将矩阵 K 切分成 Tc = ⌈ M Bc ⌉ 块 K1, . . . , KTc,Ki ∈ R Bc×d 将矩阵 V 切分成 Tc 块 V1, . . . , VTc ,Vi ∈ R Bc×d 将矩阵 O 切分成 Tr 块 O1, . . . , OTr,Oi ∈ R Br×d 将 l 切分成 Tr 块 l1, . . . ,lTr,li ∈ R Br 将 m 切分成 Tr 块 m1, . . . ,mTr,mi ∈ R Br for j = 1 to Tc do 将 Kj 和 Vj 从 HBM 中读入芯片存储 SRAM for i = 1 to Tr do 计算 Sij = QiKT j ∈ R Br×Bc 计算 m˜ ij=rowmax(Sij ) ∈ R Br,P˜ ij=exp(Sij − m˜ ij ) ∈ R Br×Bc 计算 ˜lij=rowsum(P˜ ij ) ∈ R Br 计算 mnew i = max(mi ,m˜ ij ) ∈ R Br,l new i = emi−mnew i li + em˜ ij−mnew i ˜lij ∈ R 将 O ← diag(l new i ) −1 (diag(li)emi−mnew i Oi + em˜ ij−mnew i P˜ ijVj ) 写回 HBM 中 将 li ← l new i 和 mi ← mnew i 写回 HBM 中 end end return O

PyTorch 2.0 中已经可以支持 FlashAttention,使用”torch.backends.cuda.enable_flash_sdp()”启 用或者关闭 FlashAttention 的使用。

Br

3. 多查询注意力

多查询注意力(Multi Query Attention)[62] 是多头注意力的一种变体。其主要区别在于,在多 查询注意力中不同的注意力头共享一个键和值的集合,每个头只单独保留了一份查询参数。因此 键和值的矩阵仅有一份,这大幅度减少了显存占用,使其更高效。由于多查询注意力改变了注意力 机制的结构,因此模型通常需要从训练开始就支持多查询注意力。文献 [63] 的研究结果表明,可 以通过对已经训练好的模型进行微调来添加多查询注意力支持,仅需要约 5% 的原始训练数据量 就可以达到不错的效果。包括 Falcon[64]、SantaCoder[65]、StarCoder[66] 等在内很多模型都采用了多 查询注意力机制。

以 LLM Foundry 为例,多查询注意力实现代码如下:

class MultiQueryAttention(nn.Module):

""" 多查询自注意力

使用 torch 或 triton 实现的注意力允许用户还可以使用加性偏置

"""

def __init__(

self,

d_model: int,

n_heads: int,

device: Optional[str] = None,

):

super().__init__()

self.d_model = d_model

self.n_heads = n_heads

self.head_dim = d_model // n_heads

self.Wqkv = nn.Linear( # Multi-Query Attention 创建

d_model,

d_model + 2 * self.head_dim, # 只创建 查询 的 头向量,所以只有 1 个 d_model

device=device, # 而 键 和 值 则共享各自的一个 head_dim 的向量

)

self.attn_fn = scaled_multihead_dot_product_attention

self.out_proj = nn.Linear(

self.d_model,

self.d_model,

device=device

)

self.out_proj._is_residual = True

def forward(

self,

x,

):

qkv = self.Wqkv(x) # (1, 512, 960)

query, key, value = qkv.split( # query -> (1, 512, 768)

[self.d_model, self.head_dim, self.head_dim], # key -> (1, 512, 96)

dim=2 # value -> (1, 512, 96)

)

context, attn_weights, past_key_value = self.attn_fn(

query,

key,

value,

self.n_heads,

multiquery=True,

)

return self.out_proj(context), attn_weights, past_key_value

与 LLM Foundry 中实现的多头自注意力代码相对比,其区别仅在于建立 Wqkv 层上:

# Multi Head Attention

self.Wqkv = nn.Linear( # Multi-Head Attention 的创建方法

self.d_model,

3 * self.d_model, # 查询、键和值 3 个矩阵, 所以是 3 * d_model

device=device

)

query, key, value = qkv.chunk( # 每个 tensor 都是 (1, 512, 768)

3,

dim=2

)

# Multi Query Attention

self.Wqkv = nn.Linear( # Multi-Query Attention 的创建方法

d_model,

d_model + 2 * self.head_dim, # 只创建查询的头向量,所以是 1* d_model

device=device, # 而键和值不再具备单独的头向量

)

query, key, value = qkv.split( # query -> (1, 512, 768)

[self.d_model, self.head_dim, self.head_dim], # key -> (1, 512, 96)

dim=2 # value -> (1, 512, 96)

)

2.4 实践思考

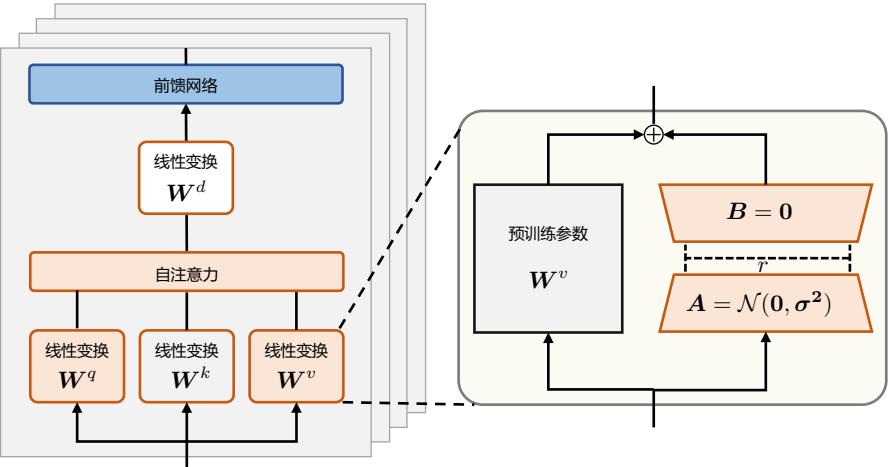

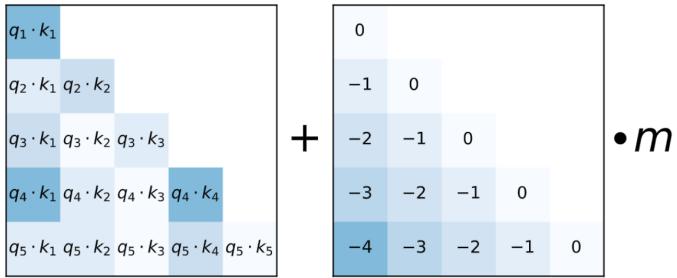

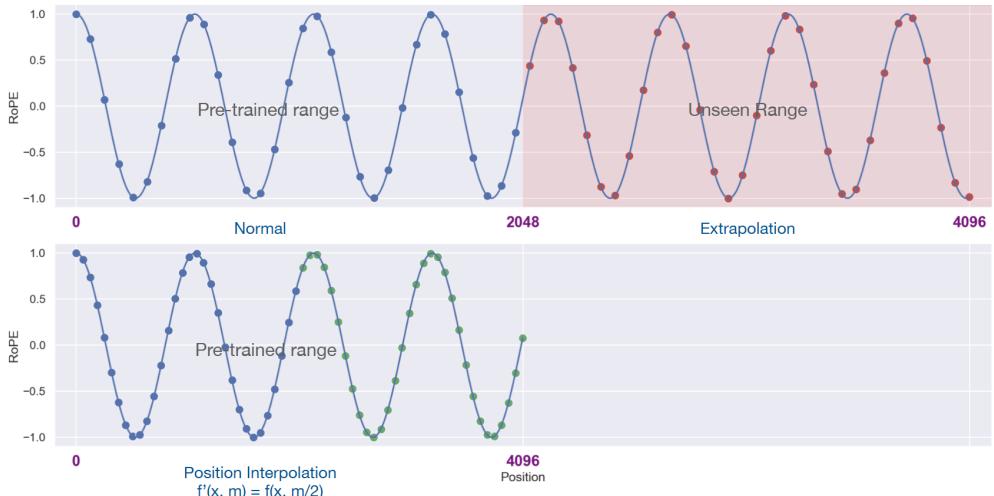

预训练语言模型除了本章介绍的自回归(Autoregressive)模型 GPT 之外,还有自编码模型 (Autoencoding)BERT[1],编-解码(Encoder-Decoder)模型 BART[67],以及融合上述三种方法的 自回归填空(Autoregressive Blank Infilling)模型 GLM(General Language Model)[68]。ChatGPT 的出现,使得目前几乎所有大语言模型神经网络结构都趋于相同,采用自回归模型,基础架构与 GPT-2 相同。但是在归一化函数、激活函数以及位置编码等细节方面有所不同。归一化函数和激 活函数的选择对于大模型收敛性具有一定影响,因此在 LLaMA 模型之后,大多数开源模型都沿 用了 RMSNorm 和 SwiGLU 组合。但是由于 LLaMA 模型所采用的位置编码方法 RoPE 的外推能 力不好,因此后续一些研究采用了 ALiBi[69] 等具有更好外推能力的位置编码,从而使得模型具有 更长的上下文建模能力。

大语言模型训练需要使用大量计算资源,其中计算设备的内存是影响计算效率的最重要因素 之一,因此注意力机制改进算法也是在模型架构层的研究热点。在本章中介绍了注意力机制优化 的典型方法,在这些方法基础上,有很多研究陆续开展,比如 FlashAttention-2[70] 等。如何能够更 加有效地利用计算设备内存,以及如何使得内存消耗与模型上下文近似线性扩展都是重要的研究 方向。

本章中所介绍的方法都围绕 GPT-3 架构,而 OpenAI 发布的 GPT-4 相较于 ChatGPT 有显著的 提升。然而,GPT-4 的神经网络模型结构和参数规模尚未公开,由于模型参数庞大且计算成本高 昂,不仅对于高校等研究机构很难支撑万亿规模大语言模型架构研究,对于大规模互联网企业来 说也不容易提供支持。因此,大模型的未来架构研究该如何进行需要各方面的努力。有未经证实 的消息称,GPT-4 采用了专家混合模型(Mixture of Experts,MoE)架构,总共有 1.8 万亿个参数。 GPT-4 使用了 16 个专家,每个专家的参数约为 1110 亿,每次前向传递使用 2 个专家进行路由,同 时还有 550 亿个共享参数用于注意力机制。MoE 架构在减少推理时所需的参数量的同时,仍然可 以使用更大规模的模型参数。然而,更多模型架构细节尚未提供,仍然需要进一步的研究。

3. 大语言模型预训练数据

大语言模型训练需要数万亿的各类型数据。如何构造海量”高质量”数据对于大语言模型的 训练具有至关重要的作用。虽然,截止到 2023 年 9 月为止,还没有非常好的大模型的理论分析和 解释,也缺乏对语言模型训练数据的严格说明和定义。但是,大多数研究人员都普遍认为训练数 据是影响大语言模型效果以及样本泛化能力的关键因素之一。从此前的研究来看,预训练数据需 要涵盖各种类型,包括网络数据、图书、论文、百科和社交媒体等,还需要覆盖尽可能多的领域、 语言、文化和视角,从而提高大语言模型的泛化能力和适应性。

本章将介绍常见的大语言模型训练数据的来源、处理方法、预训练数据对大语言模型影响的 分析以及开源数据集合等。

3.1 数据来源

文献 [5] 介绍了 OpenAI 训练 GPT-3 所使用的主要数据来源,包含经过过滤的 CommonCrawl 数据集[19]、WebText2、Books1、Books2 以及英文 Wikipedia 等数据集合。其中 CommonCrawl 的 原始数据有 45TB,进行过滤后仅保留了 570GB 的数据。通过词元方式对上述语料进行切分,大 约一共包含 5000 亿词元。为了保证模型使用更多高质量数据进行训练,在 GPT-3 训练时,根据语 料来源的不同,设置不同的采样权重。在完成 3000 亿词元训练时,英文 Wikipedia 的语料平均训 练轮数为 3.4 次,而 CommonCrawl 和 Books 2 仅有 0.44 次和 0.43 次。由于 CommonCrawl 数据集 合的过滤过程繁琐复杂,Meta 公司的研究人员在训练 OPT[31] 模型时则采用了混合 RoBERTa[71]、 Pile[72] 和 PushShift.io Reddit[73] 数据的方法。由于这些数据集合中包含的绝大部分都是英文数据, 因此 OPT 也从 CommonCrawl 数据集中抽取了部分非英文数据加入训练语料。

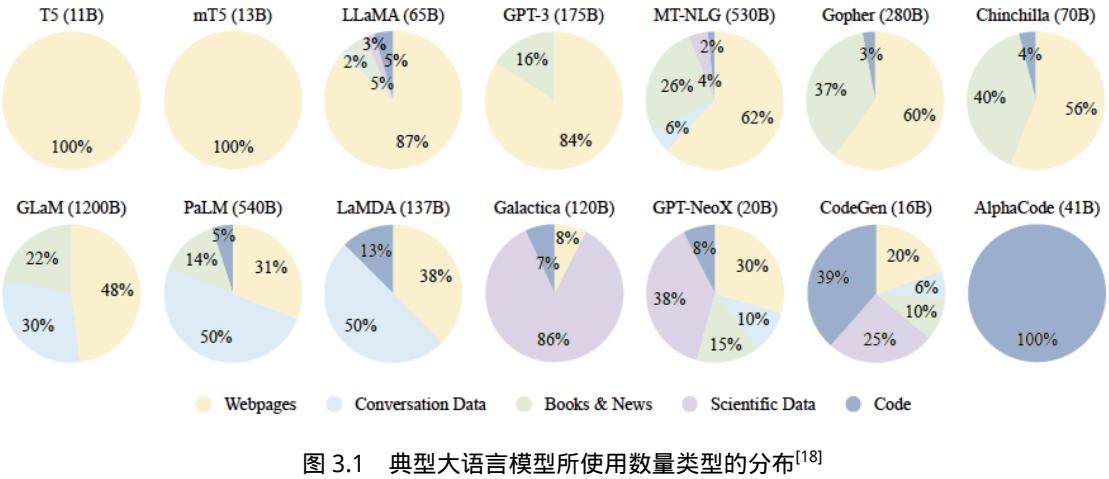

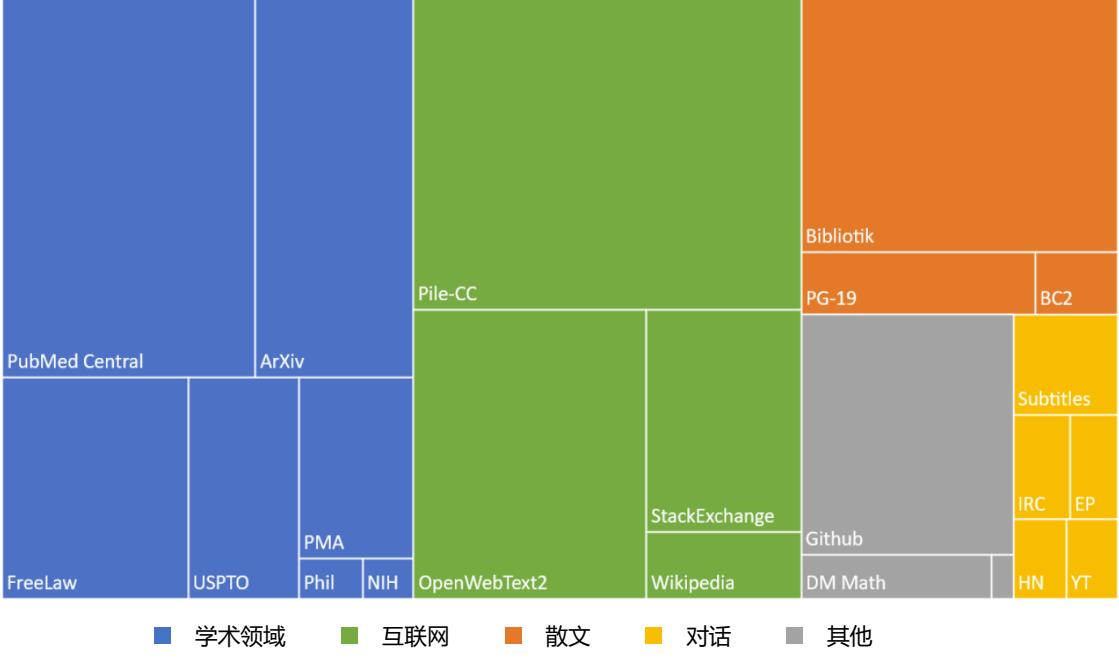

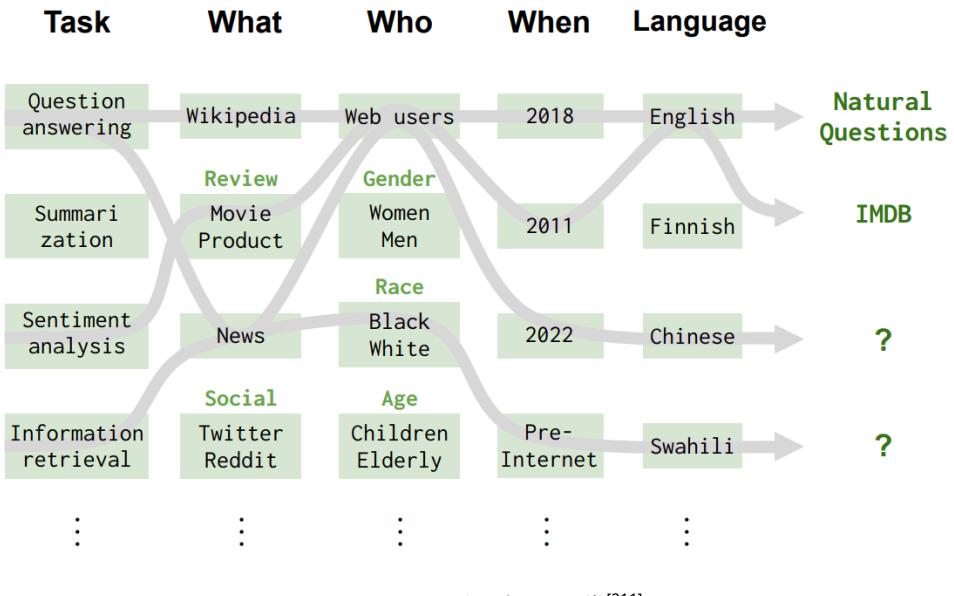

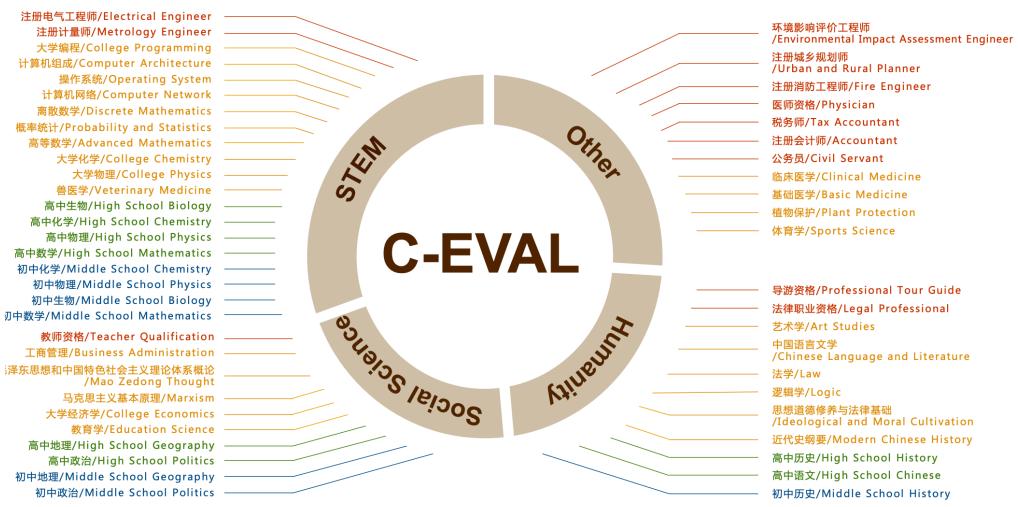

大语言模型训练所需的数据来源大体上可以分为通用数据和专业数据两大类。通用数据(General Data)包括网页、图书、新闻、对话文本等内容[14, 31, 46]。通用数据具有规模大、多样性和易获 取等特点,因此可以支持大语言模型的语言建模和泛化能力。专业数据(Specialized Data)包括多 语言数据、科学数据、代码以及领域特有资料等数据。通过在预训练阶段引入专业数据可以有效提 供大语言模型的任务解决能力。图3.1给出了一些典型大语言模型所使用数量类型的分布情况。可 以看到不同的大语言模型在训练类型分布上的差距很大,截止 2023 年 9 月为止,还没有得到广泛

认可数据类型分布比例。

3.1.1 通用数据

通用数据在大模型训练数据中占比通常非常高,主要包括网页、书籍、对话文本等类型,为 大模型提供了大规模且多样的训练数据。

网页(Webpages)是通用数据中数量最大的一类。随着互联网的大规模普及,人们通过网站、 论坛、博客、APP 等各种类型网站和应用,创造了海量的数据。根据 2016 年 Google 公开的数据, 其搜索引擎索引处理了超过 130 万亿网页。网页数据所包含的海量内容,使得语言模型能够获得 多样化的语言知识并增强其泛化能力[4, 19]。爬取和处理这些海量网页内容并不是一件容易的事情, 因此一些研究人员构建了包括 ClueWeb09[74]、ClueWeb12[75]、SogouT-16[76]、CommonCrawl 等在 内的开源网页数据集。但是,这些爬取的网络数据虽然包含大量高质量的文本,如维基百科,但 也包含非常多低质量的文本,如垃圾邮件等。因此,如何过滤和处理网页以提高质量数据对于大 语言模型训练来说非常重要。

对话数据(Conversation Text)是指包含两个或更多参与者之间交流的文本内容。对话数据包 含书面形式的对话、聊天记录、论坛帖子、社交媒体评论等。当前的一些研究也表明,对话数据 可以有效增强语言模型的对话能力[31],并潜在地提高其在多种问答任务上的表现[14]。对话数据可 以通过收集、清洗、归并等过程从社会媒体、论坛、邮件组等构建。相较于网页数据,对话数据 收集和处理更加困难,数据数量也相对少非常多。常见的对话数据集包括 PushShift.io Reddit[73, 77]、 Ubuntu Dialogue Corpus[78]、Douban Conversation Corpus、Chromium Conversations Corpus 等。此 外,文献 [79] 也提出了如何使用大语言模型自动生成对话数据的 UltraChat 方法。

书籍(Book)是人类知识的主要积累方式之一,从古代经典著作到现代学术著述,书籍承载

了丰富多样的人类思想。书籍通常包含广泛的词汇,包括专业术语、文学表达以及各种主题词汇。 利用书籍数据进行训练,语言模型可以接触到多样化的词汇,从而提高其对不同领域和主题的理 解能力。相较于其他语料库,书籍也是最重要的,甚至是唯一的长文本书面语的数据来源。书籍 提供了完整的句子和段落,使得语言模型可以学习到上下文之间的联系。这对于模型理解句子中 的复杂结构、逻辑关系和语义连贯性非常重要。书籍涵盖了各种文体和风格,包括小说、科学著 作、历史记录等等。通过使用书籍数据训练语言模型,可以使模型学习到不同的写作风格和表达 方式,提高大语言模型在各种文本类型上的能力。由于版权因素,开源书籍数据集合很少,现有 的开源大语言模型研究通常采用 Pile 数据集[72] 中提供的 Books3 和 Bookcorpus2 数据集。

3.1.2 专业数据

专业数据在通用大语言模型中所占比例通常较低,但是专业数据对于改进大语言模型在下游 任务上的特定能力有着非常重要的作用。专业数据有非常多的种类,文献 [18] 总结了当前大语言 模型使用的三类专业数据,包括多语言数据、科学文本以及代码。

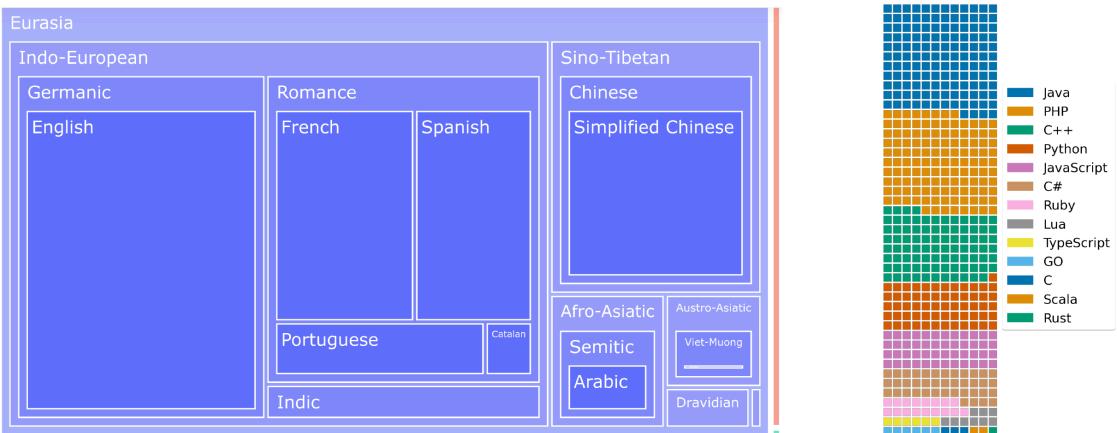

多语言数据(Multilingual Text)对于增强大语言模型语言理解和生成多语言能力具有至关重 要的作用。当前的大语言模型训练除了需要目标语言中的文本之外,通常还要整合多语言语料库。 例如,BLOOM[33] 的预训练语料中包含 46 种语言,而 PaLM[14] 的训练语料中甚至高达 122 种语 言的数据。此前的研究发现,通过多语言混合训练,预训练模型中可以在一定程度上自动构建多 语言之间的语义关联[80]。因此,多语言数据混合训练,可以有效提升翻译、多语言摘要和多语言 问答等任务能力。此外,由于不同语言中不同类型的知识获取难度不同,多语言数据还可以有效 增加数据的多样性和知识的丰富性。

科学文本(Scientific Text)包括教材、论文、百科以及其他相关资源。这些数据对于提升大 型语言模型在理解科学知识方面具有重要作用[34]。科学文本数据的来源主要包括 arXiv 论文[81]、 PubMed 论文[82]、教材、课件和教学网页等。由于科学领域涉及众多专业领域且数据形式复杂,通 常还需要对公式、化学式、蛋白质序列等采用特定的符号标记进行预处理。例如,公式可以使用 LaTeX 语法进行表示,化学结构可以使用 SMILES(Simplified Molecular Input Line Entry System) 表示,蛋白质序列可以使用单字母代码或三字母代码。这样可以将不同格式的数据转换为统一的 形式,使得语言模型更好地处理和分析科学文本数据。

代码(Code)数据是进行程序生成任务所必须的训练数据。最近的研究和 ChatGPT 的结果表 明,通过在大量代码上进行预训练,大语言模型可以有效提升代码生成的效果[83, 84]。代码数据不 仅包含程序代码本身,还包含大量的注释信息。与自然语言文本相比,代码数据具有一些显著的 区别。代码是一种格式化语言,它对应着长程依赖和准确的执行逻辑[85]。代码的语法结构、关键字 和特定的编程范式都对其含义和功能起着重要的作用。代码数据的主要来源是编程问答社区(如 Stack Exchange[86, 87])和公共软件仓库(如 GitHub[29, 83, 88])。编程问答社区中的数据包含了开发者 提出的问题、其他开发者的回答以及相关代码示例。这些数据提供了丰富的语境和真实世界中的 代码使用场景。公共软件仓库中的数据则包含了大量的开源代码,涵盖了各种编程语言和领域。这 些代码库中的很多代码经过了严格的代码评审和实际的使用测试,因此具有一定的质量和可靠性。

3.2 数据处理

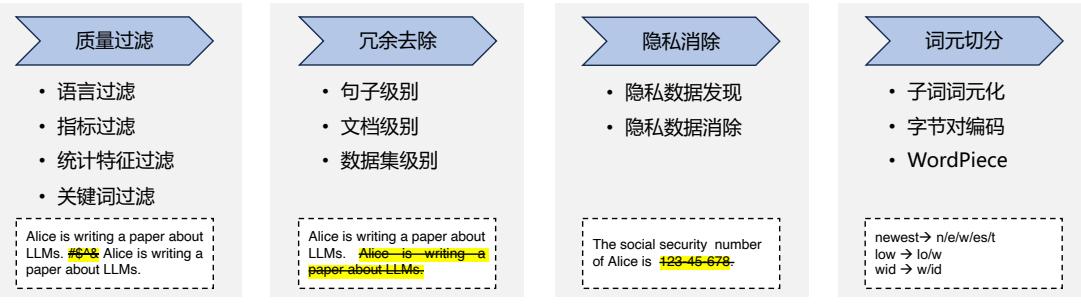

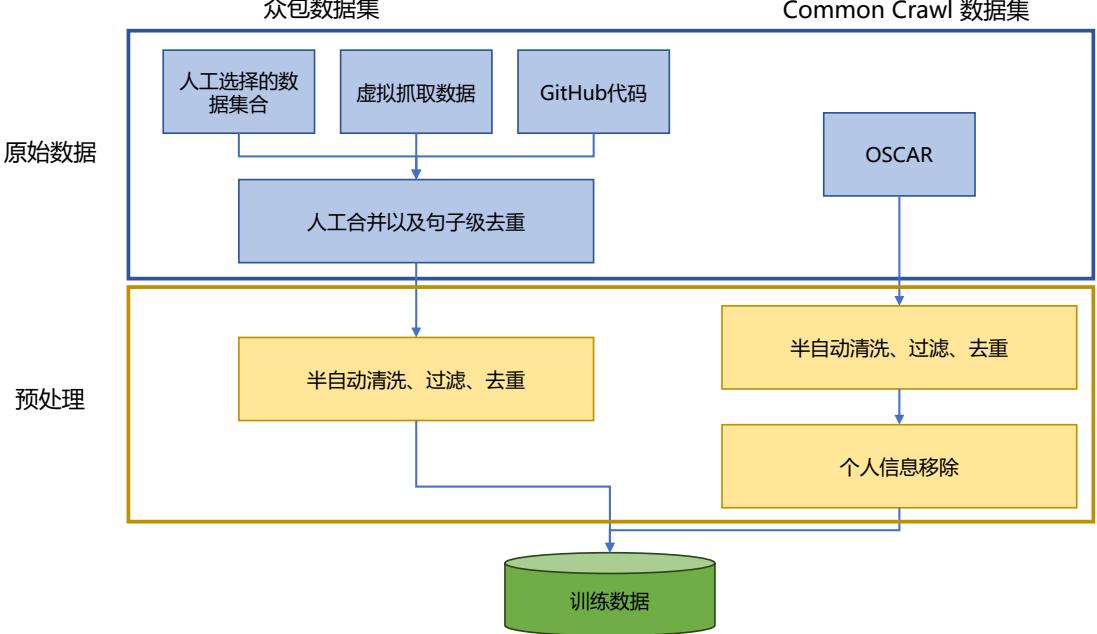

大语言模型的相关研究表明,数据质量对于模型的影响非常大。因此在收集到各类型数据之 后,需要对数据进行处理,去除低质量数据、重复数据、有害信息、个人隐私等内容[14, 89]。典型的 数据处理过程如图3.2所示,主要包含质量过滤、冗余去除、隐私消除、词元切分等几个步骤。本 节将依次介绍上述内容。

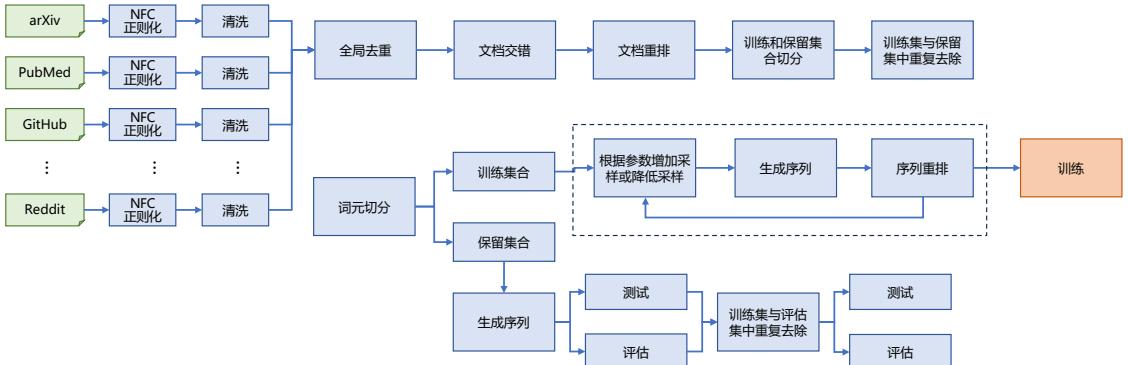

图 3.2 典型大语言模型数据处理流程图[18]

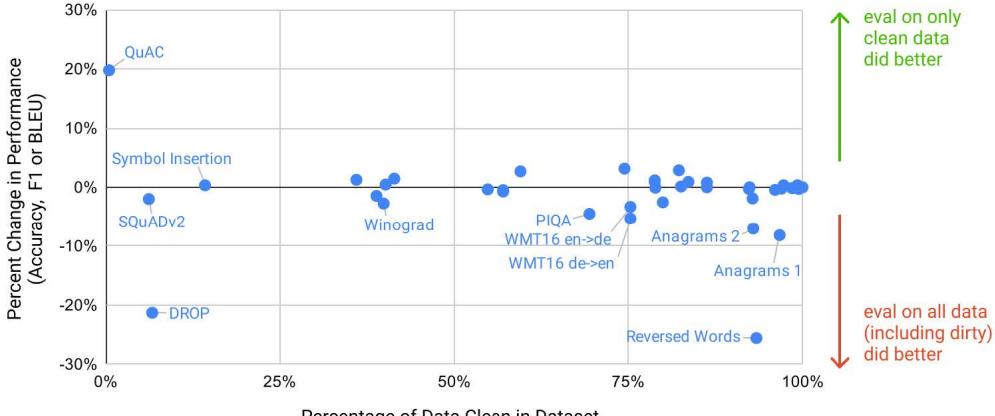

3.2.1 低质过滤

互联网上的数据质量参差不齐,无论是 OpenAI 联合创始人 Andrej Karpathy 在微软 Build 2023 的报告,还是当前的一些研究都表明,训练数据的质量对于大语言模型效果具有非常重要的影响。 因此,如何从收集到的数据中删除低质量数据成为大语言模型训练中的重要步骤。大语言模型训 练中所使用的低质量数据过滤方法可以大致分为两类:基于分类器的方法和基于启发式的方法。

基于分类器的方法目标是训练文本质量判断模型,并利用该模型识别并过滤低质量数据。GPT-3 [46]、PALM[14] 以及 GLam[90] 模型在训练数据构造时都使用了基于分类器的方法。文献 [90] 采用 了基于特征哈希的线性分类器(Feature Hash Based Linear Classifier),可以非常高效地完成文本质 量判断。该分类器使用一组精选文本(维基百科、书籍和一些选定的网站)进行训练,目标是将 与训练数据类似的网页给定较高分数。利用这个分类器可以评估网页的内容质量。在实际应用中, 还可以通过使用 Pareto 分布对网页进行采样,根据其得分选择合适的阈值,从而选定合适的数据 集合。但是,一些研究也发现,基于分类器的方法可能会删除包含方言或者口语的高质量文本,从 而损失一定的多样性[89, 90]。

基于启发式的方法则通过一组精心设计的规则来消除低质量文本,BLOOM[33] 和 Gopher[89] 采用了基于启发式的方法。这些启发式规则主要包括:

- 语言过滤:如果一个大语言模型仅关注一种或者几种语言,那么就可以大幅度地过滤掉数据 中其他语言的文本。

- 指标过滤:利用评测指标也可以过滤低质量文本。例如,可以使用语言模型对于给定文本的 困惑度(Perplexity)进行计算,利用该值可以过滤掉非自然的句子。

- 统计特征过滤:针对文本内容可以计算包括标点符号分布、符号字比(Symbol-to-Word Ratio)、 句子长度等等在内的统计特征,利用这些特征过滤低质量数据。

- 关键词过滤:根据特定的关键词集,可以识别和删除文本中的噪声或无用元素,例如,HTML 标签、超链接以及冒犯性词语等。

在大语言模型出现之前,在自然语言处理领域已经开展了很多文章质量判断(Text Quality Evaluation)相关研究,主要应用于搜索引擎、社会媒体、推荐系统、广告排序以及作文评分等任务中。 在搜索和推荐系统中,结果的内容质量是影响用户体验的的重要因素之一,因此,此前很多工作 都是针对用户生成内容(User-Generated Content,UGC)质量进行判断。自动作文评分也是文章质 量判断领域的一个重要子任务,自 1998 年文献 [91] 提出了使用贝叶斯分类器进行作文评分预测 以来,基于 SVM[92]、CNN-RNN[93]、BERT[94, 95] 等方法的作文评分算法也相继提出,并取得了较 大的进展。这些方法也都可以应用于大语言模型预训练数据过滤中。但是由于预训练数据量非常 大,并且对于质量判断的准确率并不要求非常高,因此一些基于深度学习以及基于预训练的方法 还没有应用于低质过滤中。

3.2.2 冗余去除

文献 [96] 指出大语言模型训练语料库中的重复数据,会降低语言模型的多样性,并可能导致 训练过程不稳定,从而影响模型性能。因此,需要对预训练语料库中的重复进行处理,去除其中的 冗余部分。文本冗余发现(Text Duplicate Detection)也称为文本重复检测,是自然语言处理和信息 检索中的基础任务之一,其目标是发现不同粒度上的文本重复,包括句子、段落以及文档等不同 级别。冗余去除就是在不同的粒度上进行去除重复内容,包括句子、文档和数据集等粒度的重复。

在句子级别上,文献 [97] 指出,包含重复单词或短语的句子很可能造成语言建模中引入重复的 模式。这对语言模型来说会产生非常严重的影响,使得模型在预测时容易陷入重复循环(Repetition Loops)。例如,使用 GPT-2 模型,对于给定的上下文:”In a shocking finding, scientist discovered a herd of unicorns living in a remote, previously unexplored valley, in the Andes Mountains. Even more surprising to the researchers was the fact that the unicorns spoke perfect English.”。如果使用束 搜索(Beam Search),在设置 b = 32 时,模型就会产生如下输出,进入了重复循环模式。”The study, published in the Proceedings of the National Academy of Sciences of the United States of America (PNAS), was conducted by researchers from the Universidad Nacional Autónoma de México (UNAM) and the Universidad Nacional Autónoma de México (UNAM/Universidad Nacional Autónoma de México/Universidad Nacional Autónoma de México/Universidad Nacional Autónoma de México/Universidad Nacional Autónoma de …“。由于重复循环对于语言模型生成的文本质量有非常大的影响,因此在 预训练语料中需要删除这些包含大量重复单词或者短语的句子。

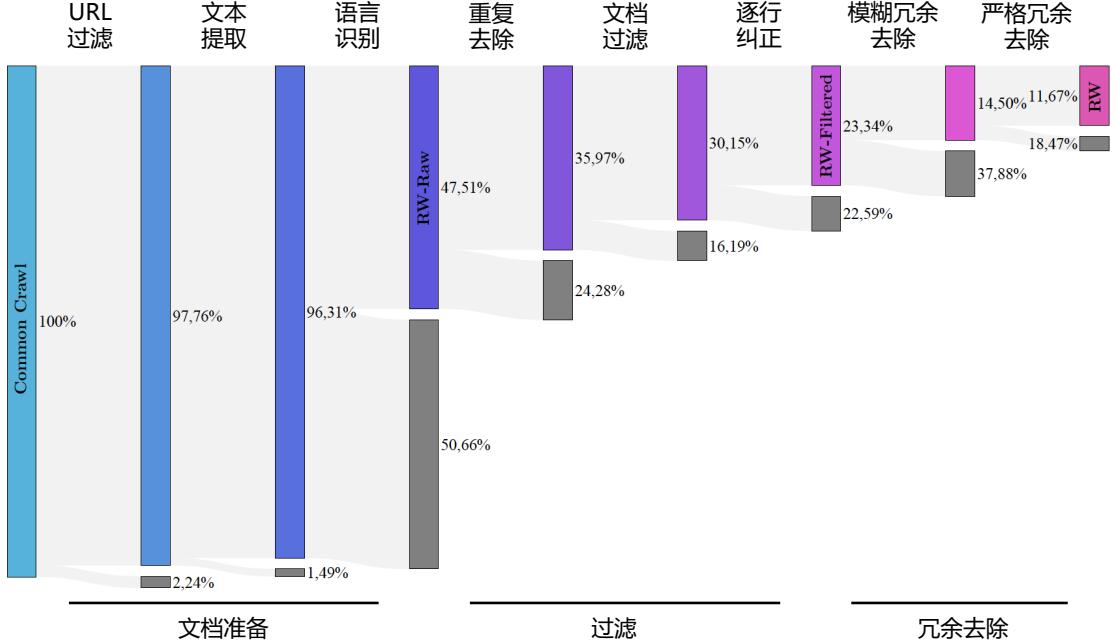

| RefinedWeb[64] 构造过程中也进行了句子级别的过滤。使用了文献 [98] 所提出的过滤方法,提 取并过滤文档间超过一定长度的相同字符串。给定两个文档 xi 和 xj,其中存在长度为 k 的公共 子串 x a…a+k i = x b…b+k j 。当 k ⩾ 50 时,就将其中一个子串过滤。公共子串匹配的关键是如何高效 完成字符串匹配,文献 [64] 将整个文档 D 转换为一个超长的字符串序列 S,之后构造序列 S 的后 缀数组(Suffix Array)A。该数组包含在该序列中的所有后缀按字典顺序排列的列表。具体而言, 后缀数组 A 是一个整数数组,其中每个元素表示 S 中的一个后缀的起始位置。A 中的元素按照后 缀的字典顺序排列。例如,序列”banana”的后缀包括”banana”,”anana”,”nana”,”ana”,”na” 和”a”,对应的后缀数组 A 为 [6, 4, 2, 1, 5, 3]。根据数组 A,可以很容易地找出相同的子串。如 果 Si..i+ | s | = Sj..j+ | s | ,那么 i 和 j 在数组 A 中一定在紧邻的位置上。文献 [98] 中设计了并行的 后缀数组构造方法,针对 Wiki-40B 训练语料(约包含 4GB 文本内容),使用拥有 96 核 CPU 以及 768GB 内存的服务器,可以在 2.3 分钟内完成计算。对于包含 350GB 文本的 C4 数据集合,仅需 要 12 小时可以完成后缀数组构造。 |

在文档级别上,大部分大语言模型都是依靠文档之间的表面特征相似度(例如 n-gram 重叠比 例)进行检测并删除重复文档[33, 37, 64, 98]。LLaMA[37] 采用 CCNet[99] 的处理模式,首先将文档拆分 为段落,并把所有字符转换为小写字符、将数字替换为占位符,以及删除所有 Unicode 标点符号 和重音符号来对每个段落进行规范化处理。然后,使用为 SHA-1 方法为每个段落计算一个哈希码 (Hash Code),并使用前 64 位数字作为键。最后,利用每个段落的键进行重复判断。RefinedWeb[64] 首先去除掉页面中菜单、标题、页脚、广告等内容,仅抽取页面中的主要内容。在此基础上,在 文档级别进行过滤,采用与文献 [89] 类似的方法,使用 n-gram 重叠程度来衡量句子、段落以及文 档的相似度。如果重复程度超过预先设定的阈值,则会过滤掉重复段落或文档。

此外,数据集层面也可能存在一定数量的重复情况,比如很多大语言模型预训练集合都会包 含 GitHub、Wikipedia、C4 等数据集。还需要特别注意的是,预训练语料中混入测试语料,从而造 成数据集污染的情况。在实际产生预训练数据时,需要从数据集、文档以及句子三个级别去除重 复,这对于改善语言模型的训练具有重要的作用[14, 100]。

3.2.3 隐私消除

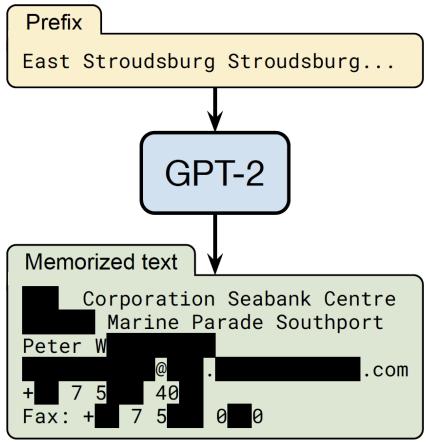

由于绝大多数预训练数据源于互联网,因此不可避免地会包含涉及敏感或个人信息(Personally Identifiable Information,PII)的用户生成内容,这可能会增加隐私泄露的风险[101]。如图3.3所示, 输入前缀词”East Stroudsburg Stroudsburg”,语言模型在此基础上补全了姓名、电子邮件地址、电 话号码、传真号码以及实际地址。这些信息都是模型从预训练语料中学习得到的。因此,非常有 必要从预训练语料库中删除包含个人身份信息的内容。

删除隐私数据最直接的方法是采用基于规则的算法,BigScience ROOTS Corpus[102] 构建过程

图 3.3 从大语言模型中获得隐私数据的例子[101]

中就是采用了基于命名实体识别的方法,利用命名实体识别算法检测姓名、地址和电话号码等个 人信息内容并进行删除或者替换。该方法使用了基于 Transformer 的模型,并结合机器翻译技术, 可以处理超过 100 种语言的文本,消除其中的隐私信息。该算法被集成在 muliwai 类库中。

3.2.4 词元切分

传统的自然语言处理通常以单词为基本处理单元,模型都依赖预先确定的词表 V,在编码输入 词序列时,这些词表示模型只能处理词表中存在的词。因此,在使用中,如果遇到不在词表中的未 登录词,模型无法为其生成对应的表示,只能给予这些未登录词(Out-of-Vocabulary,OOV)一个默认 的通用表示。在深度学习模型中,词表示模型会预先在词表中加入一个默认的”[UNK]”(unknown) 标识,表示未知词,并在训练的过程中将 [UNK] 的向量作为词表示矩阵的一部分一起训练,通过 引入某些相应机制来更新 [UNK] 向量的参数。在使用时,对于全部的未登录词,都使用 [UNK] 的 向量作为这些词的表示向量。此外,基于固定词表的词表示模型对词表大小的选择比较敏感。当 词表大小过小时,未登录词的比例较高,影响模型性能。而当词表大小过大时,大量低频词出现 在词表中,而这些词的词向量很难得到充分学习。理想模式下,词表示模型应能覆盖绝大部分的 输入词,并避免词表过大所造成的数据稀疏问题。

为了缓解未登录词问题,一些工作通过利用亚词级别的信息构造词表示向量。一种直接的解决 思路是为输入建立字符级别表示,并通过字符向量的组合来获得每个单词的表示,以解决数据稀疏 问题。然而,单词中的词根、词缀等构词模式往往跨越多个字符,基于字符表示的方法很难学习跨 度较大的模式。为了充分学习这些构词模式,研究人员们提出了子词词元化(Subword Tokenization) 方法,试图缓解上文介绍的未登录词问题。词元表示模型会维护一个词元词表,其中既存在完整 的单词,也存在形如”c”, “re”, “ing”等单词部分信息,称为子词(Subword)。词元表示模

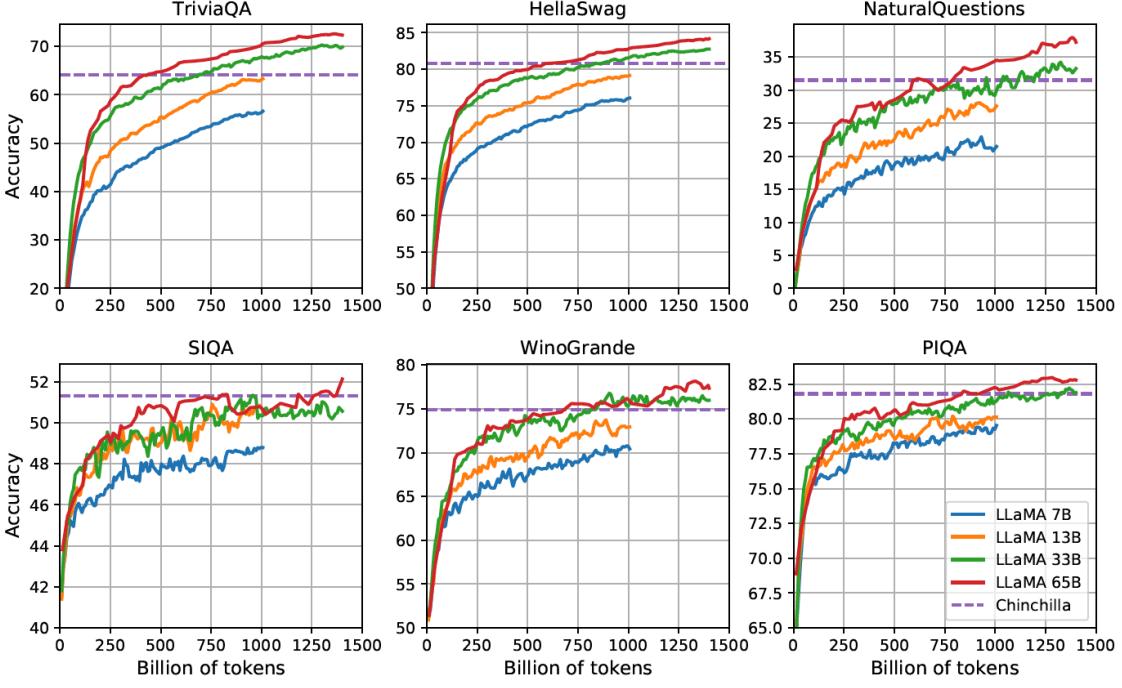

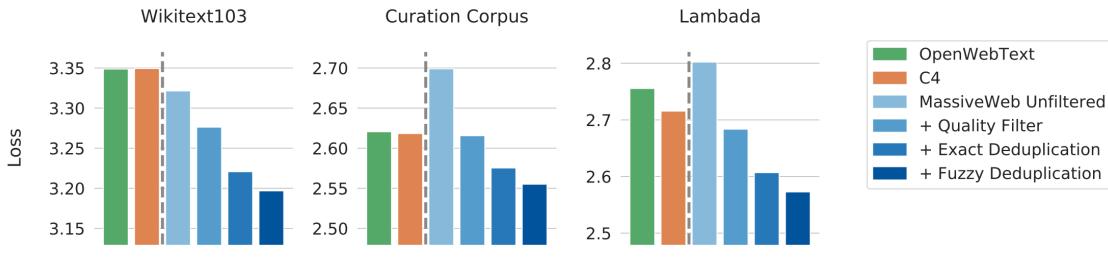

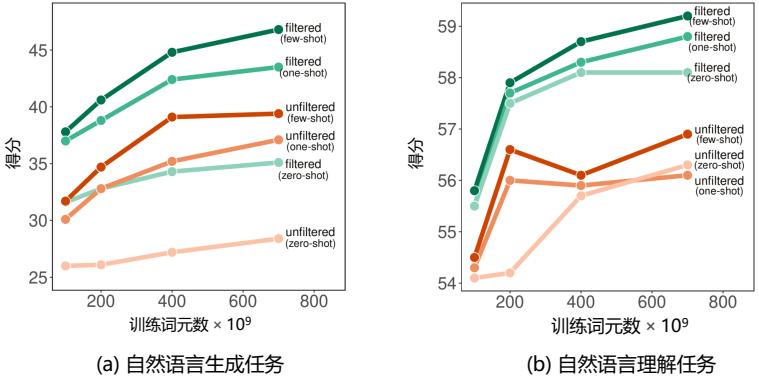

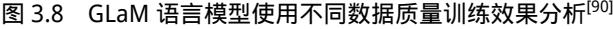

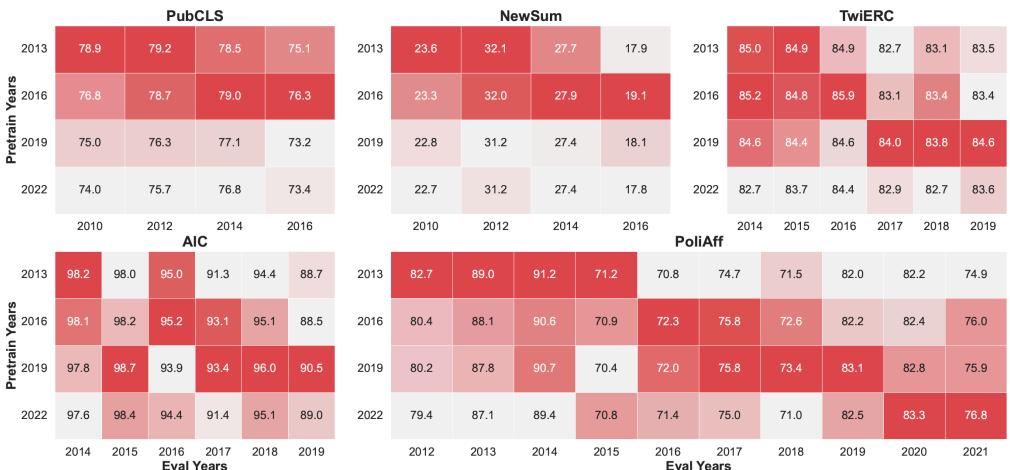

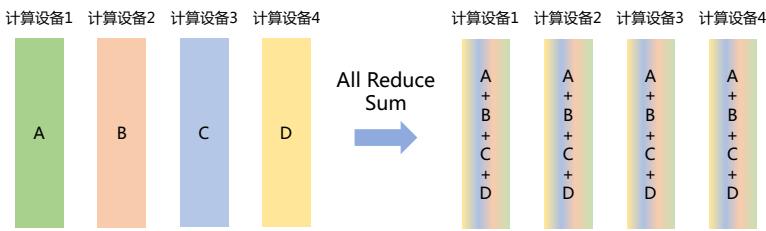

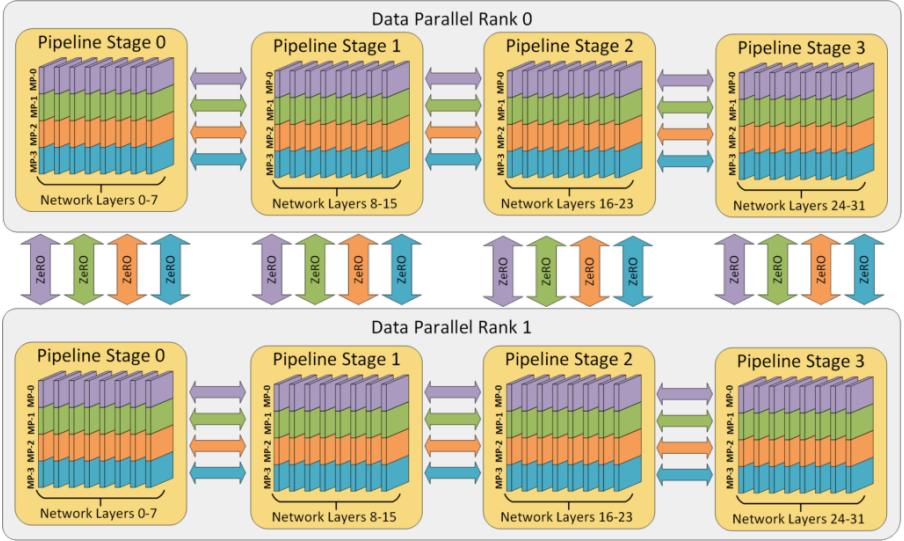

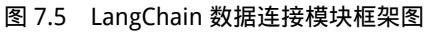

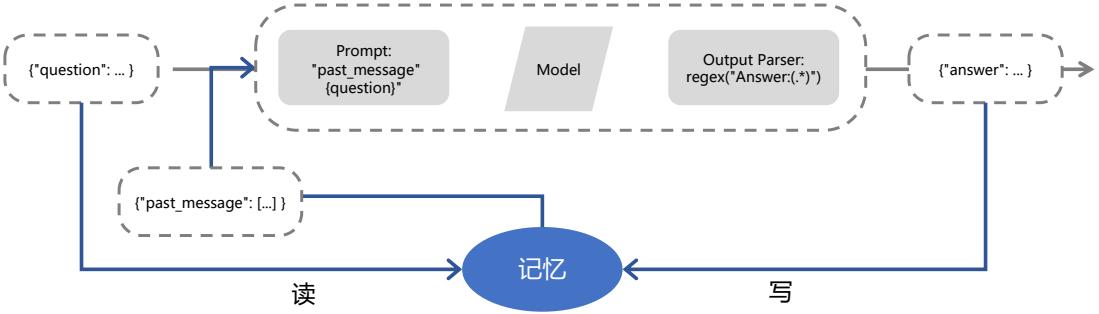

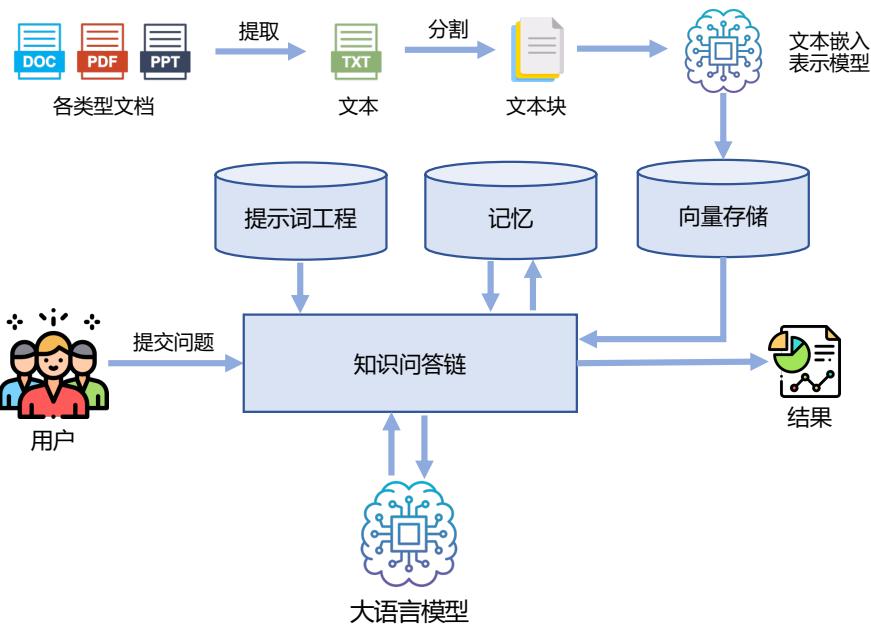

型对词表中的每个词元计算一个定长向量表示,供下游模型使用。对于输入的词序列,词元表示 模型将每个词拆分为词表内的词元。例如,将单词”reborn”拆分为”re”和”born”。模型随后 查询每个词元的表示,将输入重新组成为词元表示序列。当下游模型需要计算一个单词或词组的 表示时,可以将对应范围内的词元表示合成为需要的表示。因此,词元表示模型能够较好地解决 自然语言处理系统中未登录词的问题。词元分析(Tokenization)目标是将原始文本分割成由词元 (Token)序列的过程。词元切分也是数据预处理中至关重要的一步。